資訊專欄INFORMATION COLUMN

小編寫這篇文章的主要目的,就是給大家介紹關于Python的一些總結,比如使用Python爬蟲Xpath定位數據,那么,在定位數據的時候,有兩種方法,具體有什么方法介紹呢?下面就給大家詳細的解答下。

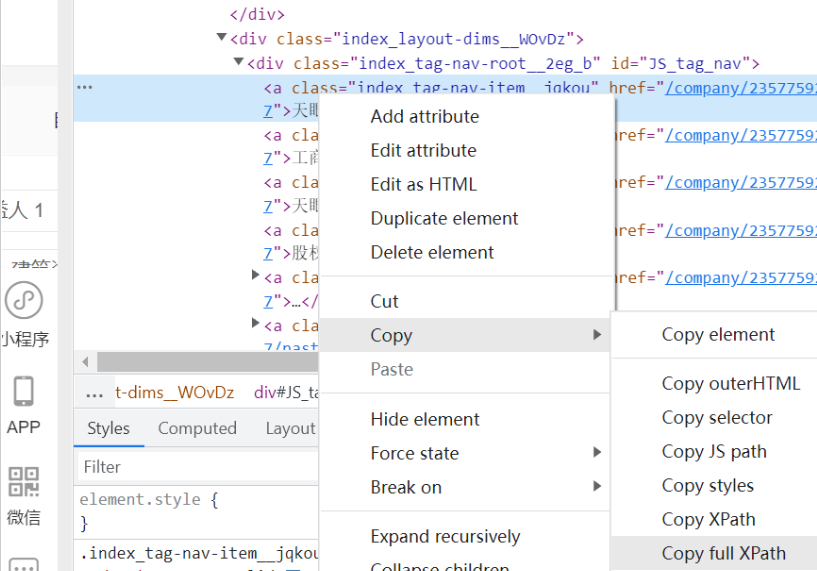

方法一:直接右鍵,將文章路徑復制下來點擊Copy full Xpath

使用selenium+lxml中的etree進行配合使用,使用etree解析html網頁

</>復制代碼

import requests from lxml import etree import time import socket import csv from selenium import webdriver from configparser import ConfigParser from selenium.webdriver import Chrome from selenium.webdriver import ChromeOptions #禁止圖片和css加載 chrome_options=webdriver.ChromeOptions() prefs={"profile.managed_default_content_settings.images":2} chrome_options.add_experimental_option("prefs",prefs) option=ChromeOptions() option.add_experimental_option('excludeSwitches',['enable-automation']) #如果想加載圖片,就把下面第二句話改第一句話,刪掉上面的“禁止圖片和css加載”部分 #wb=Chrome(options=option) wb=webdriver.Chrome(options=chrome_options) #最大化窗口、輸入網址、等待至網頁加載完成(防止元素還沒加載出來就開始爬了這樣自然爬不到數據。如果一直加載不出就等10秒,加載好了就立刻結束等待) wb.maximize_window() wb.get("https://www.tianyancha.com/") wb.implicitly_wait(5) 然后獲取網頁數據,這里表明哪怕后面出錯了,仍然可以延續wb的位置繼續控制瀏覽器 data=wb.page_source time.sleep(3) data=wb.page_source time.sleep(3) page_all.append(data) html=etree.HTML(data) company=html.xpath('/html/body/div/div/div[2]/div/div[1]/div[1]/div[3]/div[1]/div[1]/div[1]/h1/text()') print(company)

方法二:使用制定標簽屬性,搜索指定位置

這樣的好處就是,對于批量處理的網頁,有的標簽位置不在同一個地方,那么我們就是不使用全Xpath路徑,而使用相對路徑,用制定某種屬性的標簽,下載相關數據

</>復制代碼

"//div[class='mainArea']/ul/li"

使用//div[class=‘mainArea’]的意思是:從根部(//)查找class值為mainArea的Node.

所以,那么就很簡單了//某元素[class=‘CLASS值’]

大家可以按照這個公式來查找class的元素了。

剩下的/ul/li表示的是,繼續查找class='mainArea’的div包括的ul元素下面的li節點集合。

這篇內容就為大家介紹到這里了,希望可以給大家帶來更多幫助。

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/128254.html

摘要:然而讓蟲師們垂涎的并不是以上的種種,而是其通過驅動瀏覽器獲得的解析的能力。所以說這貨在動態爬取方面簡直是掛逼級別的存在,相較于手動分析更簡單易用,節省分析打碼時間。一旦設置了隱式等待時間,它的作用范圍就是對象實例的整個生命周期。 selenium——自動化測試工具,專門為Web應用程序編寫的一個驗收測試工具,測試其兼容性,功能什么的。然而讓蟲師們垂涎的并不是以上的種種,而是其通過驅動瀏...

摘要:起初的提出的初衷是將其作為一個通用的介于與間的語法模型。的基本使用要使用我們需要下載,在爬蟲入門到精通環境的搭建這一章也說明怎么裝,如果還沒有安裝的話,那就去下載安裝吧直接看代碼實戰吧。 本文章屬于爬蟲入門到精通系統教程第六講 在爬蟲入門到精通第五講中,我們了解了如何用正則表達式去抓取我們想要的內容.這一章我們來學習如何更加簡單的來獲取我們想要的內容. xpath的解釋 XPath即為...

摘要:上一篇文章網絡爬蟲實戰與正則表達式抓取貓眼電影排行下一篇文章網絡爬蟲實戰解析庫的使用上一節我們實現了一個最基本的爬蟲,但提取頁面信息時我們使用的是正則表達式,用過之后我們會發現構造一個正則表達式還是比較的繁瑣的,而且萬一有一點地 上一篇文章:Python3網絡爬蟲實戰---27、Requests與正則表達式抓取貓眼電影排行下一篇文章:Python3網絡爬蟲實戰---29、解析庫的使用:...

摘要:介紹是一個用于應用程序測試的工具,測試直接運行在瀏覽器中,就像真正的用戶在操作一樣。支持的瀏覽器包括,,,,,等,它在的領域里的引用能使初學者大大的省去解析網頁中代加密的一些麻煩。 Selenium介紹 Selenium 是一個用于Web應用程序測試的工具,Selenium測試直接運行在瀏覽...

摘要:所以只要得到登錄后的并必要時進行更新,服務器就會認定其為登錄狀態。看看人家知乎,加密到連名字都沒有了,還混淆,如何下手綜上,適用于沒有加密的登錄或者加密算法比較簡單并且不常更新的網站。遇上無解的加密算法要么手操拷貝,要么請大佬出場。 某些網站,登錄和沒登錄,用戶的權限是不一樣的,帳號登錄之后才能獲取更多的信息。更有甚者一上來就是登錄界面,不登錄就不給你進去(如p站)。爬取目標不用登錄固...

閱讀 925·2023-01-14 11:38

閱讀 897·2023-01-14 11:04

閱讀 756·2023-01-14 10:48

閱讀 2058·2023-01-14 10:34

閱讀 963·2023-01-14 10:24

閱讀 842·2023-01-14 10:18

閱讀 511·2023-01-14 10:09

閱讀 589·2023-01-14 10:02