資訊專欄INFORMATION COLUMN

此篇文章主要是給大家介紹了caffe的python插口制作loss和accuracy曲線圖實(shí)例詳細(xì)說明,感興趣的小伙伴可以參考借鑒一下,希望可以有一定的幫助,祝愿大家多多的發(fā)展,盡早漲薪

前言

使用python插口來運(yùn)行caffe程序流程,根本原因是python很容易數(shù)據(jù)可視化。所以才建議大家在cmd下邊運(yùn)行python程序流程。如果一定要在cmd下邊運(yùn)作,不如直接用c++算了。

強(qiáng)烈推薦使用jupyternotebook,spyder等設(shè)備來運(yùn)行python編碼,這樣也和它數(shù)據(jù)可視化完美融合在一起。

anaconda庫(kù)

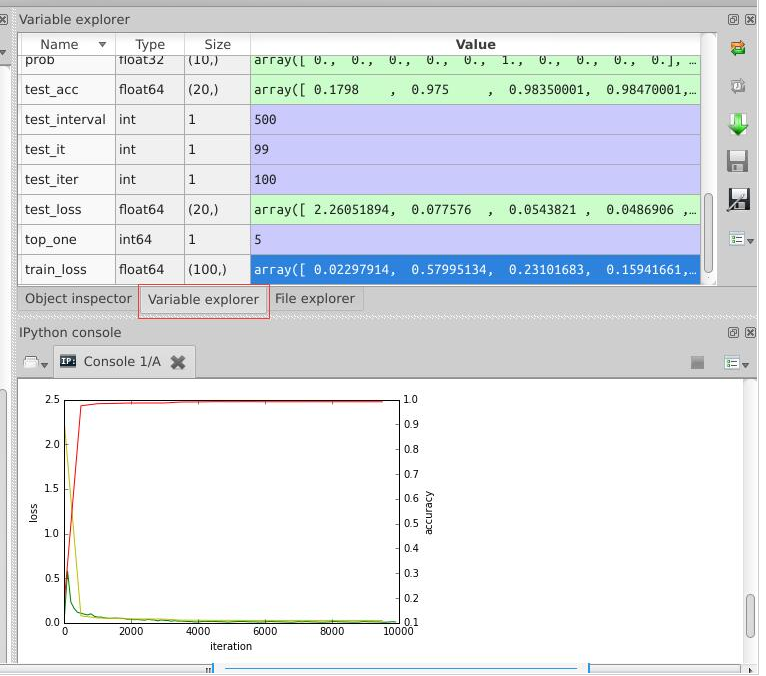

我屬于用anaconda來組裝一連串python三方庫(kù)的,因此我所使用的是spyder,與matlab頁(yè)面類似的這款在線編輯器,在運(yùn)行中,可以看一下各自變量數(shù)值,有利于了解,如下圖所示:

只要安裝了anaconda,運(yùn)行方式也非常方便,直接在終端輸入spyder命令就可以了。

python接口實(shí)現(xiàn)

在caffe的訓(xùn)練過程中,我們?nèi)绻胫滥硞€(gè)階段的loss值和accuracy值,并用圖表畫出來,用python接口就對(duì)了。

#-*-coding:utf-8-*-

"""

Created on Tue Jul 19 16:22:22 2016

author:root

"""

import matplotlib.pyplot as plt

import caffe

caffe.set_device(0)

caffe.set_mode_gpu()

#使用SGDSolver,即隨機(jī)梯度下降算法

solver=caffe.SGDSolver('/home/xxx/mnist/solver.prototxt')

#等價(jià)于solver文件中的max_iter,即最大解算次數(shù)

niter=9380

#每隔100次收集一次數(shù)據(jù)

display=100

#每次測(cè)試進(jìn)行100次解算,10000/100

test_iter=100

#每500次訓(xùn)練進(jìn)行一次測(cè)試(100次解算),60000/64

test_interval=938

#初始化

train_loss=zeros(ceil(niter*1.0/display))

test_loss=zeros(ceil(niter*1.0/test_interval))

test_acc=zeros(ceil(niter*1.0/test_interval))

#iteration 0,不計(jì)入

solver.step(1)

#輔助變量

_train_loss=0;_test_loss=0;_accuracy=0

#進(jìn)行解算

for it in range(niter):

#進(jìn)行一次解算

solver.step(1)

#每迭代一次,訓(xùn)練batch_size張圖片

_train_loss+=solver.net.blobs['SoftmaxWithLoss1'].data

if it%display==0:

#計(jì)算平均train loss

train_loss[it//display]=_train_loss/display

_train_loss=0

if it%test_interval==0:

for test_it in range(test_iter):

#進(jìn)行一次測(cè)試

solver.test_nets[0].forward()

#計(jì)算test loss

_test_loss+=solver.test_nets[0].blobs['SoftmaxWithLoss1'].data

#計(jì)算test accuracy

_accuracy+=solver.test_nets[0].blobs['Accuracy1'].data

#計(jì)算平均test loss

test_loss[it/test_interval]=_test_loss/test_iter

#計(jì)算平均test accuracy

test_acc[it/test_interval]=_accuracy/test_iter

_test_loss=0

_accuracy=0

#繪制train loss、test loss和accuracy曲線

print'nplot the train loss and test accuracyn'

_,ax1=plt.subplots()

ax2=ax1.twinx()

#train loss->綠色

ax1.plot(display*arange(len(train_loss)),train_loss,'g')

#test loss->黃色

ax1.plot(test_interval*arange(len(test_loss)),test_loss,'y')

#test accuracy->紅色

ax2.plot(test_interval*arange(len(test_acc)),test_acc,'r')

ax1.set_xlabel('iteration')

ax1.set_ylabel('loss')

ax2.set_ylabel('accuracy')

plt.show()最后生成的圖表在上圖中已經(jīng)顯示出來了。

綜上所述,這篇文章就給大家解答完畢了,希望可以給大家?guī)韼椭?/p>

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/128756.html

此篇文章主要是詳細(xì)介紹了caffe的python插口形成環(huán)境變量學(xué)習(xí)培訓(xùn),感興趣的小伙伴可以參考借鑒一下,希望可以有一定的幫助,祝愿大家多多的發(fā)展,盡早漲薪 caffe是C++語言表達(dá)所寫的,可能大家不太熟,所以想要更方便的編程語言來達(dá)到。caffe給予matlab接口和python插口,這幾種語言表達(dá)就比較簡(jiǎn)單,并且很容易開展數(shù)據(jù)可視化,導(dǎo)致學(xué)習(xí)培訓(xùn)更為迅速,了解更加深刻。 一年前,我在...

文中主要是給大家介紹了caffe的python插口之手寫數(shù)字識(shí)別mnist案例詳細(xì)說明,感興趣的小伙伴可以參考借鑒一下,希望可以有一定的幫助,祝愿大家多多的發(fā)展,盡早漲薪 論文引言 機(jī)器學(xué)習(xí)第一個(gè)案例一般都是是mnist,只需這個(gè)案例徹底搞懂了,其他的便是觸類旁通的事了。因?yàn)樽謹(jǐn)?shù)緣故,文中不簡(jiǎn)單介紹環(huán)境變量里邊每一個(gè)指標(biāo)的具體函義,如果要搞明白的,請(qǐng)參考我之前的微博文章: 數(shù)據(jù)訪問層及主...

本文主要是給大家介紹了caffe的python插口生成deploy文件學(xué)習(xí)培訓(xùn)及其用練習(xí)好一點(diǎn)的實(shí)體模型(caffemodel)來歸類新的圖片實(shí)例詳細(xì)說明,感興趣的小伙伴可以參考借鑒一下,希望可以有一定的幫助,祝愿大家多多的發(fā)展,盡早漲薪 caffe的python插口生成deploy文件 假如要將練習(xí)好一點(diǎn)的實(shí)體模型用于檢測(cè)新的圖片,那必然必須得一個(gè)deploy.prototxt文件,這一...

小編寫這篇文章的一個(gè)主要目的,主要是給大家做一個(gè)詳細(xì)的介紹,介紹的內(nèi)容主要是利用Python知識(shí),利用Python去實(shí)現(xiàn)RNN與堆疊的RNN,具體的實(shí)例代碼,下面就給大家詳細(xì)的去做一個(gè)解答。 1、雙向RNN 雙向RNN(Bidirectional RNN)的結(jié)構(gòu)如下圖所示。 雙向的RNN是同時(shí)考慮過去和未來的信息。上圖是一個(gè)序列長(zhǎng)度為4的雙向RNN結(jié)構(gòu)。 雙向RNN就像是我們做閱...

本文主要是給大家介紹了caffe的python插口形成solver文件詳細(xì)說明學(xué)習(xí)培訓(xùn)實(shí)例,感興趣的小伙伴可以參考借鑒一下,希望可以有一定的幫助,祝愿大家多多的不斷進(jìn)步,盡早漲薪 也有一些基本參數(shù)必須計(jì)算出來的,并不是亂設(shè)定。 solver.prototxt的文件參數(shù)設(shè)置 caffe在訓(xùn)練的時(shí)候,需要一些參數(shù)設(shè)置,我們一般將這些參數(shù)設(shè)置在一個(gè)叫solver.prototxt的文件里面,如...

閱讀 919·2023-01-14 11:38

閱讀 891·2023-01-14 11:04

閱讀 750·2023-01-14 10:48

閱讀 2039·2023-01-14 10:34

閱讀 956·2023-01-14 10:24

閱讀 834·2023-01-14 10:18

閱讀 506·2023-01-14 10:09

閱讀 583·2023-01-14 10:02