資訊專欄INFORMATION COLUMN

注意力機制最開始被用于NLP行業,Attention就是為了給實體模型意識到信息中哪一塊是最關鍵的,給它分派更多的權重值,獲得更多集中注意力在某些特點上,讓實體模型主要表現更強,文中關鍵為大家介紹了有關YOLOv5改善實例教程之加上注意力機制的資料,必須的小伙伴可以借鑒一下

文中關鍵為大家講解一下下,怎樣在yolov5中加入注意力機制,

這兒給予SE通道專注力的改進方案,別的專注力的加上方式,如出一轍

最先尋找SE注意力機制的pytorch編碼

classSELayer(nn.Module): def__init__(self,c1,r=16): super(SELayer,self).__init__() self.avgpool=nn.AdaptiveAvgPool2d(1) self.l1=nn.Linear(c1,c1//r,bias=False) self.relu=nn.ReLU(inplace=True) self.l2=nn.Linear(c1//r,c1,bias=False) self.sig=nn.Sigmoid() defforward(self,x): b,c,_,_=x.size() y=self.avgpool(x).view(b,c) y=self.l1(y) y=self.relu(y) y=self.l2(y) y=self.sig(y) y=y.view(b,c,1,1) returnx*y.expand_as(x)

直接將SE注意力機制程序,拷貝到modele文件夾下邊的common.py文件中

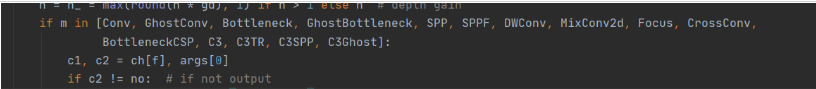

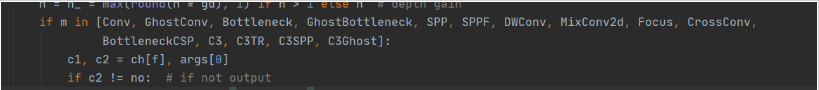

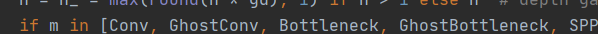

隨后尋找yolo.py,在這樣一個文檔中尋找下邊這個行業

并把SE導入到這一注冊表文件里,

直接從C3Ghost后邊加上SELayer

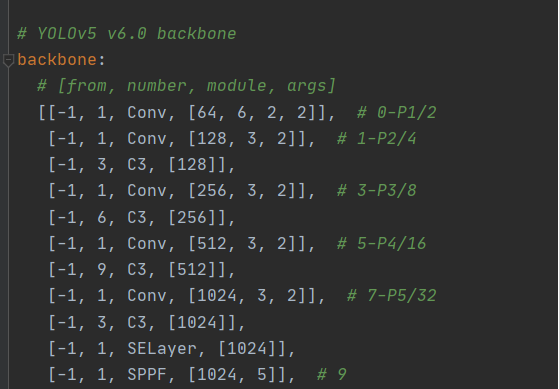

然后就是要改動yaml文件,針對SE這類1394連接的注意力機制,輸入輸出的通道數一樣,因此也不會影響別的模塊運作

注意力機制也可以裝在別處,一定要注意把通道數相匹配滿意就好

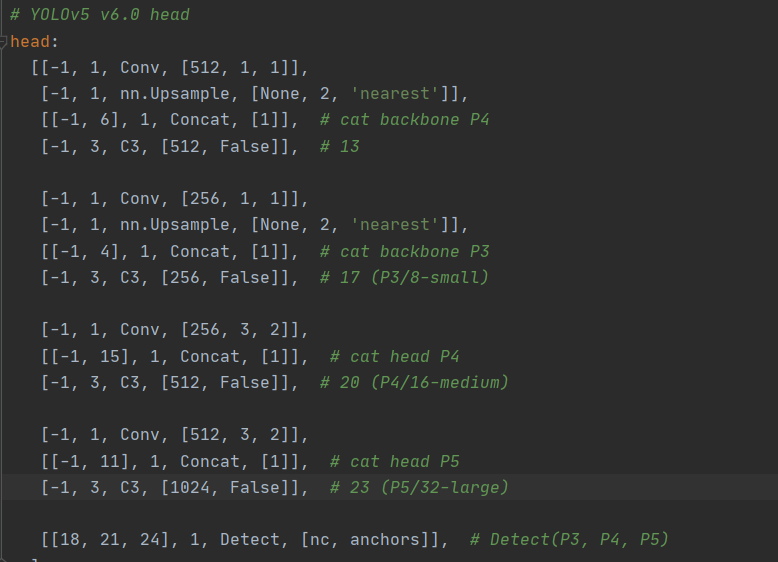

隨后head一部分也要進行一定的改動,只要我們多多一層,因此需要維持head及其最后輸出層不會改變就要略微改一下head一部分,一樣,注意力機制也要放在head里頭,跟加進backbone里邊的方式一樣。

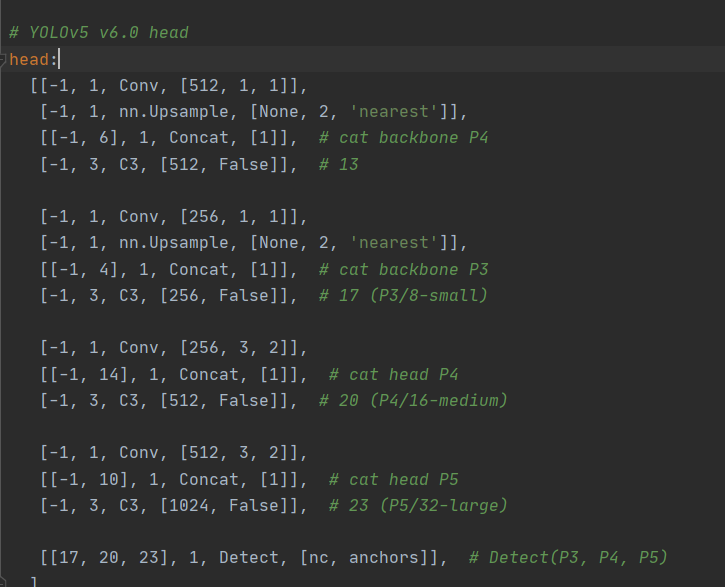

這也是初始的head一部分,必須改動成下邊那樣

只要我們把SE注意力機制插到第八層以后,因此原來的14層就會變成15層,相同的,最后導出也要把疊加層數加一點。

加上這種注意力機制是yolov5最基本的改善,但說實話,注意力機制能夠加上在許多的區域,未必會出效果,因此插在哪里效果最佳就需要我們自主探討了。注意力機制有很多種,se注意力機制應當屬于最基本的通道注意力了啊

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/129078.html

注意力機制最開始被用于NLP行業,Attention就是為了給實體模型意識到信息中哪一塊是最關鍵的,給它分派更多的權重值,獲得更多專注力在有些特點上,讓實體模型主要表現更強,文中關鍵為大家介紹了有關YOLOv5改善實例教程之再加上注意力機制的資料,必須的小伙伴可以借鑒一下 文中關鍵為大家講解一下下,怎樣在yolov5中加入注意力機制, 在這里給予SE通道專注力的改進方案,別的專注力的再加上...

摘要:的安裝下載好之后雙擊打開可執行安裝文件選擇安裝目錄,需要的內存較多,建議將其安裝在盤或者盤,不建議放在系統盤盤。 yolov5無從下手?一篇就夠的保姆級教程,202...

如今yolov5的neck用的都是PANet,在efficient文章中給出了BiFPN結構,也有更為很不錯的特性,接下來本文關鍵為大家介紹了對于如何將yolov5里的PANet層改成BiFPN的資料,需用的小伙伴可以借鑒一下 一、Add 1.在common.py后放入如下所示編碼 #融合BiFPN設定可學習培訓主要參數學習培訓不一樣支系的權重值 #2個支系add實際操作 cl...

閱讀 919·2023-01-14 11:38

閱讀 891·2023-01-14 11:04

閱讀 750·2023-01-14 10:48

閱讀 2039·2023-01-14 10:34

閱讀 956·2023-01-14 10:24

閱讀 834·2023-01-14 10:18

閱讀 506·2023-01-14 10:09

閱讀 583·2023-01-14 10:02