資訊專欄INFORMATION COLUMN

摘要:深度學(xué)習(xí)框架作為熱身,我們先看一下深度學(xué)習(xí)框架。在年有急劇的增長,但在過去幾個(gè)月被超越。

你是否使用過 Google Trends?相當(dāng)?shù)目幔阍诶锩孑斎腙P(guān)鍵詞,看一下谷歌搜索中這一詞條如何隨時(shí)間變化的。我想,過去 5 年中 arxiv-sanity 數(shù)據(jù)庫中剛好有 28303 篇機(jī)器學(xué)習(xí)論文,為什么不做一些類似的工作,看一下過去 5 年機(jī)器學(xué)習(xí)研究有何進(jìn)化?結(jié)果相當(dāng)?shù)挠腥ぃ晕野阉N了出來。

arXiv 奇點(diǎn)

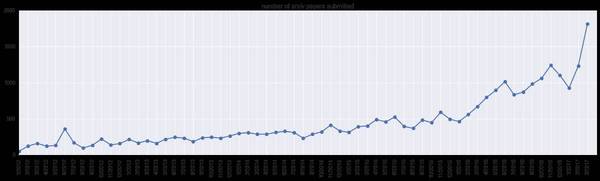

首先,讓我們看一下在 arxiv-sanity 類別下(cs.AI、cs.LG、cs.CV、cs.CL、cs.NE、stat.ML)所遞交論文的總數(shù)。隨時(shí)間變化,得出以下結(jié)果:

是的,2017 年 3 月,該領(lǐng)域有幾乎 2000 篇論文被提交。這一峰值可能是由于大會(huì)截止日期(例如 NIPS/ICML)。注意,這不是關(guān)于該領(lǐng)域自身體量的一個(gè)直接說明,因?yàn)椴皇敲總€(gè)人都會(huì)把論文提交到 arXiv 上,而且研究人員做研究的分類也會(huì)隨時(shí)間變化。但有一點(diǎn)可以說明,人工智能領(lǐng)域正有大量論文被發(fā)現(xiàn)、瀏覽、閱讀。

把論文的總量做為分母,我們現(xiàn)在看一下有多少比例的論文包含確切的關(guān)鍵詞。

深度學(xué)習(xí)框架

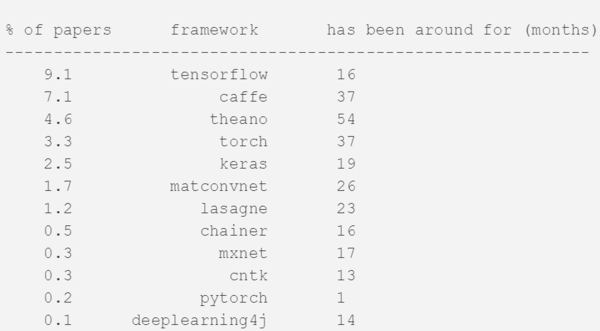

作為熱身,我們先看一下深度學(xué)習(xí)框架。為了計(jì)算這個(gè)關(guān)鍵詞,我們記錄了在全部文本中的某處提到框架名的論文以及其比例(任何地方,包括 bibiliography 等)。在 2017 年三月份提交的論文中,我們得出了下面的結(jié)果:

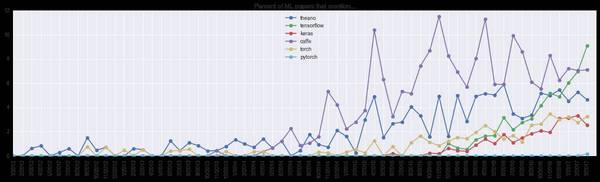

也就是說,2017 年 3 月提交的論文中 10% 提到了 TensorFlow。當(dāng)然,不是每篇論文都宣布使用了該框架,如果我們假設(shè)那些提到框架的論文都有一定概率使用該框架,那看起來社區(qū)中有 40% 的人在使用 TensorFlow(或者更多,如果你把帶有 TF 后端的 Keras 也算在內(nèi))。下面是更多框架隨時(shí)間變化的圖繪:

我們能看到 Theano 已經(jīng)出現(xiàn)很長時(shí)間了,但其增長趨于停滯。Caffe 在 2014 年有急劇的增長,但在過去幾個(gè)月被 TensorFlow 超越。Torch(以及最近的 PyTorch)也在攀爬階段,緩慢卻穩(wěn)定。接下來幾個(gè)月的發(fā)展值得注意,我個(gè)人的猜測(cè)是 Caffe/Theano 將繼續(xù)緩慢的衰退,TensorFlow 也會(huì)因?yàn)?PyTorch 出現(xiàn),增長速度變的更慢。

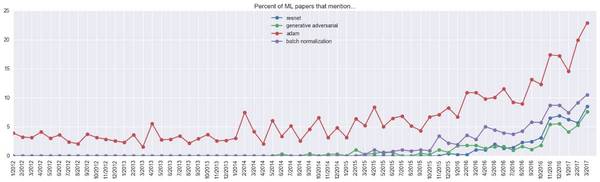

ConvNet 模型

接下來看一下常見的 ConvNet 模型。下圖中,我們能清楚的看到 ResNet 的漲幅,直到三月份所有論文的 9% 提到了它。

還有,在 InceptionNet 之前誰在討論「inception」?對(duì)此也很好奇。

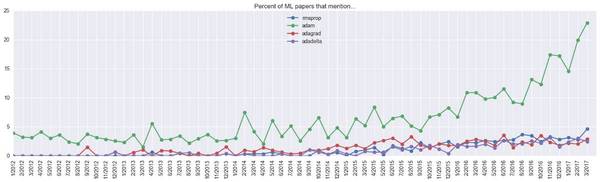

優(yōu)化算法

在優(yōu)化算法方面,看起來 Adam 正在流行,所有論文中 23% 提到了 Adam。實(shí)際使用的比例難以估計(jì),但可能要比 23% 高,因?yàn)橐恍┱撐臎]有公布用到的優(yōu)化算法,而且一批論文可能沒優(yōu)化任何神經(jīng)網(wǎng)絡(luò)。然后它可能還低了 5%,也就是 Adam「隱藏」在背后,可能與作者的名字沖突,因?yàn)?Adam 優(yōu)化算法到了 2014 年 12 月才發(fā)布。

研究人員

我們對(duì)深度學(xué)習(xí)中一些重要人物出現(xiàn)的比例也很好奇,所以進(jìn)行了繪圖。這有點(diǎn)類似于引用量,但它要比論文非零即一的統(tǒng)計(jì)更為穩(wěn)健,而且對(duì)所有的論文進(jìn)行了標(biāo)準(zhǔn)化。

可以注意的:所有提交的論文中 35% 提到了「bengio」,但研究人員中有兩個(gè) Bengio:Samy 和 Yoshua,在此圖中是合并統(tǒng)計(jì)的。特別提到的一點(diǎn),在所有新論文中有超過 30% 提到了 Geoff Hinton,看起來非常的多。

熱詞或非關(guān)鍵詞

最后,除了手動(dòng)查閱的關(guān)鍵詞類別,讓我們看一下一些熱詞或不熱的關(guān)鍵詞。

較高級(jí)熱詞

有很多方式可對(duì)此進(jìn)行定義,但該實(shí)驗(yàn)中我觀察了所有論文中的單字母組合或雙子母詞組,并記錄了相比于去年較大使用量的比例。超越此標(biāo)準(zhǔn)的論文就是一年前還是有潛力的,但在今年就有相當(dāng)高關(guān)聯(lián)頻率的論文。列表如下:

例如,ResNet 的比例是 8.17。因?yàn)橐荒昵八谒刑峤徽撐闹谐霈F(xiàn)的比率是 1.044%(2016 年 3 月),但今年 3 月它出現(xiàn)的比例是 8.53,所以 8.53 除以 1.044 約等于 8.17。所以得出的結(jié)果是,過去一年所有的核心創(chuàng)新領(lǐng)域是 1) ResNets, 2) GANs, 3) Adam, 4) BatchNorm,在研究中多使用下這些模型。在研究興趣方面,我們看到 1) 風(fēng)格遷移,2) 深度強(qiáng)化學(xué)習(xí),3) 神經(jīng)機(jī)器翻譯,以及 4) 圖像生成。在架構(gòu)上,熱于使用 1) 全卷機(jī)網(wǎng)絡(luò) (FCN),2) LSTMs/GRUs,3) Siamese 網(wǎng)絡(luò),以及 4) 編碼器-解碼器網(wǎng)絡(luò)。

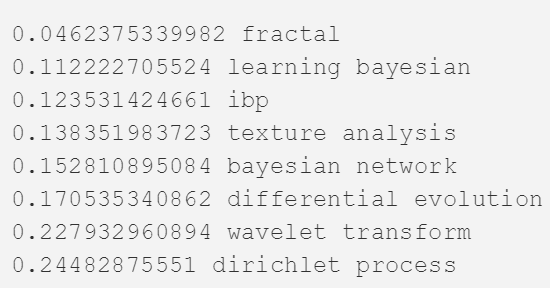

較高級(jí)但不熱

相反的一面呢?過去一年有哪些詞有較少的提交,但歷史上有更高的比例?下面列出了一些:

我不太確定「fractal」指代什么,但更普遍的可能是貝葉斯非參數(shù)在被攻擊。

結(jié)論

現(xiàn)在提交論文的主題應(yīng)該圍繞把全卷積編碼器解碼器 BatchNorm ResNet GAN(Fully Convolutional Encoder Decoder BatchNorm ResNet GAN)應(yīng)用于風(fēng)格遷移,用 Adam 進(jìn)行優(yōu)化。聽起來也不那么不靠譜。?

原文鏈接:https://medium.com/@karpathy/a-peek-at-trends-in-machine-learning-ab8a1085a106

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4505.html

摘要:在過去五年里,我碰巧使用了一個(gè)收藏了篇機(jī)器學(xué)習(xí)論文的數(shù)據(jù)庫,這些論文都來自于。因此,本文將這五年間機(jī)器學(xué)習(xí)的發(fā)展趨勢(shì)進(jìn)行了簡單的總結(jié)。我們得到了如下結(jié)果是的,年月份,接受了多篇與機(jī)器學(xué)習(xí)領(lǐng)域有關(guān)的論文。 機(jī)器學(xué)習(xí)的趨勢(shì)概述如果你用過谷歌趨勢(shì)(Google Trends),你一定會(huì)發(fā)現(xiàn)它很酷——你輸入一些關(guān)鍵詞,你就能夠看到這些關(guān)鍵詞的谷歌搜索量是如何隨著時(shí)間而變化的。在過去五年里,我碰巧使用...

摘要:簡稱,是基于聚焦行業(yè)應(yīng)用且提供商業(yè)支持的分布式深度學(xué)習(xí)框架,其宗旨是在合理的時(shí)間內(nèi)解決各類涉及大量數(shù)據(jù)的問題。是負(fù)責(zé)開發(fā)的用編寫,通過引擎加速的深度學(xué)習(xí)框架,是目前受關(guān)注最多的深度學(xué)習(xí)框架。 作者簡介魏秀參,曠視科技 Face++ 南京研究院負(fù)責(zé)人。南京大學(xué) LAMDA 研究所博士,主要研究領(lǐng)域?yàn)橛?jì)算機(jī)視覺和機(jī)器學(xué)習(xí)。在相關(guān)領(lǐng)域較高級(jí)國際期刊如 IEEE TIP、IEEE TNNLS、Mac...

摘要:下圖總結(jié)了絕大多數(shù)上的開源深度學(xué)習(xí)框架項(xiàng)目,根據(jù)項(xiàng)目在的數(shù)量來評(píng)級(jí),數(shù)據(jù)采集于年月初。然而,近期宣布將轉(zhuǎn)向作為其推薦深度學(xué)習(xí)框架因?yàn)樗С忠苿?dòng)設(shè)備開發(fā)。該框架可以出色完成圖像識(shí)別,欺詐檢測(cè)和自然語言處理任務(wù)。 很多神經(jīng)網(wǎng)絡(luò)框架已開源多年,支持機(jī)器學(xué)習(xí)和人工智能的專有解決方案也有很多。多年以來,開發(fā)人員在Github上發(fā)布了一系列的可以支持圖像、手寫字、視頻、語音識(shí)別、自然語言處理、物體檢測(cè)的...

摘要:作為當(dāng)下最熱門的話題,等巨頭都圍繞深度學(xué)習(xí)重點(diǎn)投資了一系列新興項(xiàng)目,他們也一直在支持一些開源深度學(xué)習(xí)框架。八來自一個(gè)日本的深度學(xué)習(xí)創(chuàng)業(yè)公司,今年月發(fā)布的一個(gè)框架。 深度學(xué)習(xí)(Deep Learning)是機(jī)器學(xué)習(xí)中一種基于對(duì)數(shù)據(jù)進(jìn)行表征學(xué)習(xí)的方法,深度學(xué)習(xí)的好處是用 非 監(jiān)督式或半監(jiān)督式 的特征學(xué)習(xí)、分層特征提取高效算法來替代手工獲取特征(feature)。作為當(dāng)下最熱門的話題,Google...

摘要:陳建平說訓(xùn)練是十分重要的,尤其是對(duì)關(guān)注算法本身的研究者。代碼生成其實(shí)在中也十分簡單,陳建平不僅利用車道線識(shí)別模型向我們演示了如何使用生成高效的代碼,同時(shí)還展示了在脫離環(huán)境下運(yùn)行代碼進(jìn)行推斷的效果。 近日,Mathworks 推出了包含 MATLAB 和 Simulink 產(chǎn)品系列的 Release 2017b(R2017b),該版本大大加強(qiáng)了 MATLAB 對(duì)深度學(xué)習(xí)的支持,并簡化了工程師、...

閱讀 1309·2021-11-15 11:37

閱讀 3501·2021-11-11 16:55

閱讀 1750·2021-08-25 09:39

閱讀 3216·2019-08-30 15:44

閱讀 1734·2019-08-29 12:52

閱讀 1405·2019-08-29 11:10

閱讀 3241·2019-08-26 11:32

閱讀 3223·2019-08-26 10:16