資訊專欄INFORMATION COLUMN

摘要:然而,可用數(shù)據(jù)集的規(guī)模卻沒有成比例地?cái)U(kuò)大。這還說明無監(jiān)督表征學(xué)習(xí),以及半監(jiān)督表征學(xué)習(xí)方法有良好的前景。例如,對(duì)于對(duì)象探測(cè)得分,單個(gè)模型目前可以實(shí)現(xiàn),高于此前的。此外,構(gòu)建包含圖片的數(shù)據(jù)集并不是最終目標(biāo)。

都說深度學(xué)習(xí)的興起和大數(shù)據(jù)息息相關(guān),那么是不是數(shù)據(jù)集越大,訓(xùn)練出的圖像識(shí)別算法準(zhǔn)確率就越高呢?

Google的研究人員用3億張圖的內(nèi)部數(shù)據(jù)集做了實(shí)驗(yàn),然后寫了篇論文。他們指出,在深度模型中,視覺任務(wù)性能隨訓(xùn)練數(shù)據(jù)量(取對(duì)數(shù))的增加,線性上升。

以下是Google Research機(jī)器感知組指導(dǎo)教師,卡耐基梅隆大學(xué)助理教授Abhinav Gupta對(duì)這項(xiàng)工作的介紹,發(fā)布在Google Research官方博客上,量子位編譯:

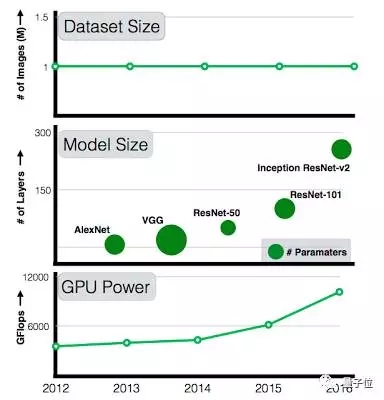

過去10年,計(jì)算機(jī)視覺技術(shù)取得了很大的成功,其中大部分可以歸功于深度學(xué)習(xí)模型的應(yīng)用。此外自2012年以來,這類系統(tǒng)的表現(xiàn)能力有了很大的進(jìn)步,原因包括:

1)復(fù)雜度更高的深度模型;

2)計(jì)算性能的提升;

3)大規(guī)模標(biāo)簽數(shù)據(jù)的出現(xiàn)。

每年,我們都能看到計(jì)算性能和模型復(fù)雜度的提升,從2012年7層的AlexNet,發(fā)展到2015年101層的ResNet。

然而,可用數(shù)據(jù)集的規(guī)模卻沒有成比例地?cái)U(kuò)大。101層的ResNet在訓(xùn)練時(shí)仍然用著和AlexNet一樣的數(shù)據(jù)集:ImageNet中的10萬張圖。

作為研究者,我們一直在關(guān)注這樣的問題:如果能將訓(xùn)練數(shù)據(jù)集擴(kuò)大10倍,較精確度是否會(huì)有成倍的提升?如果數(shù)據(jù)集擴(kuò)大100倍或300倍又會(huì)怎樣?較精確度會(huì)停滯不前,還是隨著數(shù)據(jù)量的增長(zhǎng)不斷提升?

過去5年間,GPU計(jì)算力和模型復(fù)雜度都在持續(xù)增長(zhǎng),但訓(xùn)練數(shù)據(jù)集的規(guī)模沒有任何變化

在論文Revisit the Unreasonable Effectiveness of Data中,我們邁出了第一步,探索“大量數(shù)據(jù)”與深度學(xué)習(xí)之間的關(guān)系。我們的目標(biāo)是研究:

1)使用當(dāng)前的算法,如果提供越來越多帶噪聲標(biāo)簽的圖片,視覺表現(xiàn)是否仍然可以得到優(yōu)化;

2)對(duì)于標(biāo)準(zhǔn)的視覺任務(wù),例如分類、對(duì)象探測(cè),以及圖像分割,數(shù)據(jù)和性能之間的關(guān)系是什么;

3)利用大規(guī)模學(xué)習(xí)技術(shù),開發(fā)能勝任計(jì)算機(jī)視覺領(lǐng)域各類任務(wù)的較先進(jìn)的模型。

當(dāng)然,問題的關(guān)鍵在于,我們要從何處找到比ImageNet大300倍的數(shù)據(jù)集。

Google一直努力構(gòu)建這樣的數(shù)據(jù)集,以優(yōu)化計(jì)算機(jī)視覺算法。在Geoff Hinton、Francois Chollet等人的努力下,Google內(nèi)部構(gòu)建了一個(gè)包含3億張圖片的數(shù)據(jù)集,將其中的圖片標(biāo)記為18291個(gè)類,并將其命名為JFT-300M。

圖片標(biāo)記所用的算法混合了復(fù)雜的原始網(wǎng)絡(luò)信號(hào),以及網(wǎng)頁和用戶反饋之間的關(guān)聯(lián)。

通過這種方法,這3億張圖片獲得了超過10億個(gè)標(biāo)簽(一張圖片可以有多個(gè)標(biāo)簽)。在這10億個(gè)標(biāo)簽中,約3.75億個(gè)通過算法被選出,使所選擇圖片的標(biāo)簽較精確度較大化。然而,這些標(biāo)簽中依然存在噪聲:被選出圖片的標(biāo)簽約有20%是噪聲。

我們的實(shí)驗(yàn)驗(yàn)證了一些假設(shè),但也帶來了意料之外的結(jié)果:

更好的表征學(xué)習(xí)(Representation Learning)能帶來幫助。

我們觀察到的較早的現(xiàn)象是,大規(guī)模數(shù)據(jù)有助于表征學(xué)習(xí),從而優(yōu)化我們所研究的所有視覺任務(wù)的性能。

我們的發(fā)現(xiàn)表明,建立用于預(yù)訓(xùn)練的大規(guī)模數(shù)據(jù)集很重要。這還說明無監(jiān)督表征學(xué)習(xí),以及半監(jiān)督表征學(xué)習(xí)方法有良好的前景。看起來,數(shù)據(jù)規(guī)模繼續(xù)壓制了標(biāo)簽中存在的噪聲。

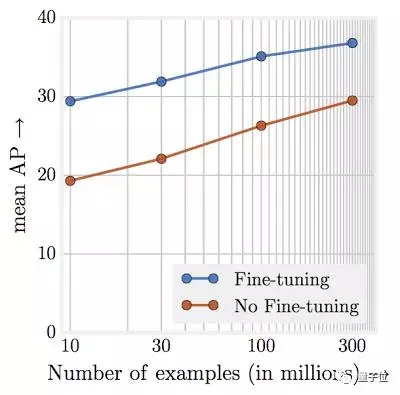

隨著訓(xùn)練數(shù)據(jù)數(shù)量級(jí)的增加,任務(wù)性能呈線性上升。

或許最令人驚訝的發(fā)現(xiàn)在于,視覺任務(wù)性能和表現(xiàn)學(xué)習(xí)訓(xùn)練數(shù)據(jù)量(取對(duì)數(shù))之間的關(guān)系。我們發(fā)現(xiàn),這樣的關(guān)系仍然是線性的。即使訓(xùn)練圖片規(guī)模達(dá)到3億張,我們也沒有觀察到性能上升出現(xiàn)停滯。如下圖所示:

模型容量非常關(guān)鍵。

我們觀察到,如果希望完整利用3億張圖的數(shù)據(jù)集,我們需要更大容量(更深)的模型。

例如,對(duì)于ResNet-50,COCO對(duì)象探測(cè)得分的上升很有限,只有1.87%,而使用ResNet-152,這一得分上升達(dá)到3%。

新的較高水準(zhǔn)結(jié)果。

我們的論文用JFT-300M去訓(xùn)練模型,多項(xiàng)得分都達(dá)到了業(yè)界較高水準(zhǔn)。例如,對(duì)于COCO對(duì)象探測(cè)得分,單個(gè)模型目前可以實(shí)現(xiàn)37.4 AP,高于此前的34.3 AP。

需要指出,我們使用的訓(xùn)練體系、學(xué)習(xí)進(jìn)度以及參數(shù)基于此前用ImageNet 1M圖片訓(xùn)練ConvNets獲得的經(jīng)驗(yàn)。

由于我們并未在這項(xiàng)工作中探索最優(yōu)的超參數(shù)(這將需要可觀的計(jì)算工作),因此很有可能,我們還沒有得到利用這一數(shù)據(jù)集進(jìn)行訓(xùn)練能取得的較佳結(jié)果。因此我們認(rèn)為,量化的性能報(bào)告可能低估了這一數(shù)據(jù)集的實(shí)際影響。

這項(xiàng)工作并未關(guān)注針對(duì)特定任務(wù)的數(shù)據(jù),例如研究更多邊界框是否會(huì)影響模型的性能。我們認(rèn)為,盡管存在挑戰(zhàn),但獲得針對(duì)特定任務(wù)的大規(guī)模數(shù)據(jù)集應(yīng)當(dāng)是未來研究的一個(gè)關(guān)注點(diǎn)。

此外,構(gòu)建包含300M圖片的數(shù)據(jù)集并不是最終目標(biāo)。我們應(yīng)當(dāng)探索,憑借更龐大的數(shù)據(jù)集(包含超過10億圖片),模型是否還能繼續(xù)優(yōu)化。

Google Research Blog原文:https://research.googleblog.com/2017/07/revisiting-unreasonable-effectiveness.html

相關(guān)論文:Revisiting the Unreasonable Effectiveness of Data

https://arxiv.org/abs/1707.02968

你可能還關(guān)心那個(gè)3億張圖的數(shù)據(jù)集。它目前還是Google內(nèi)部用品,這兩篇論文提到過它:

Distilling the Knowledge in a Neural Network

Geoffrey Hinton, Oriol Vinyals, Jeff Dean

https://arxiv.org/abs/1503.02531

Xception: Deep Learning with Depthwise Separable Convolutions

Franc?ois Chollet

https://arxiv.org/abs/1610.02357

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4576.html

摘要:的這項(xiàng)研究,總共生成了篇深度學(xué)習(xí)論文的和代碼,還創(chuàng)建了一個(gè)網(wǎng)站,供同行們眾包編輯這些代碼。來自印度研究院。目前是印度研究院的實(shí)習(xí)生。 深度學(xué)習(xí)的論文越來越多了~多到什么程度?Google scholar的數(shù)據(jù)顯示,2016年以來,人工智能領(lǐng)域新增的論文已經(jīng)超過3.5萬篇。arXiv上,AI相關(guān)的論文每天都不下百篇。剛剛結(jié)束不久的計(jì)算機(jī)視覺會(huì)議ICCV上,發(fā)表了621篇論文;2018年的ICL...

摘要:在年初之際,國(guó)內(nèi)專業(yè)的云資源選型服務(wù)平臺(tái)旗下監(jiān)測(cè)實(shí)驗(yàn)室,針對(duì)業(yè)界家主流的云服務(wù)提供商,包括阿里云騰訊云與華為云進(jìn)行了橫向評(píng)測(cè)。華為云和阿里云緊隨其后,位列第二第三位。阿里云和騰訊云相對(duì)優(yōu)勢(shì)不明顯。 在2020年初之際,國(guó)內(nèi)專業(yè)的云資源選型服務(wù)平臺(tái)CloudBest旗下監(jiān)測(cè)實(shí)驗(yàn)室,針對(duì)業(yè)界4家主流的云服務(wù)提供商,包括阿里云、騰訊云、UCloud與華為云進(jìn)行了橫向評(píng)測(cè)。本次測(cè)試在盡量保證測(cè)試環(huán)...

摘要:年實(shí)驗(yàn)室團(tuán)隊(duì)采用了深度學(xué)習(xí)獲勝,失敗率僅。許多其他參賽選手也紛紛采用這一技術(shù)年,所有選手都使用了深度學(xué)習(xí)。和他的同事運(yùn)用深度學(xué)習(xí)系統(tǒng)贏得了美元。深度學(xué)習(xí),似乎是解決 三年前,在山景城(加利福尼亞州)秘密的谷歌X實(shí)驗(yàn)室里,研究者從YouTube視頻中選取了大約一千萬張靜態(tài)圖片,并且導(dǎo)入到Google Brain —— 一個(gè)由1000臺(tái)電腦組成的像幼兒大腦一樣的神經(jīng)網(wǎng)絡(luò)。花費(fèi)了三天時(shí)間尋找模式之...

摘要:判別器勝利的條件則是很好地將真實(shí)圖像自編碼,以及很差地辨識(shí)生成的圖像。 先看一張圖:下圖左右兩端的兩欄是真實(shí)的圖像,其余的是計(jì)算機(jī)生成的。過渡自然,效果驚人。這是谷歌本周在 arXiv 發(fā)表的論文《BEGAN:邊界均衡生成對(duì)抗網(wǎng)絡(luò)》得到的結(jié)果。這項(xiàng)工作針對(duì) GAN 訓(xùn)練難、控制生成樣本多樣性難、平衡鑒別器和生成器收斂難等問題,提出了改善。尤其值得注意的,是作者使用了很簡(jiǎn)單的結(jié)構(gòu),經(jīng)過常規(guī)訓(xùn)練...

摘要:接下來,介紹了使用深度學(xué)習(xí)的計(jì)算機(jī)視覺系統(tǒng)在農(nóng)業(yè)零售業(yè)服裝量身定制廣告制造等產(chǎn)業(yè)中的應(yīng)用和趨勢(shì),以及在這些產(chǎn)業(yè)中值得關(guān)注的企業(yè)。 嵌入式視覺聯(lián)盟主編Brian Dipert今天發(fā)布博文,介紹了2016年嵌入式視覺峰會(huì)(Embedded Vision Summit)中有關(guān)深度學(xué)習(xí)的內(nèi)容:谷歌工程師Pete Warden介紹如何利用TensorFlow框架,開發(fā)為Google Translate...

閱讀 4168·2021-09-22 15:34

閱讀 2775·2021-09-22 15:29

閱讀 499·2019-08-29 13:52

閱讀 3359·2019-08-29 11:30

閱讀 2268·2019-08-26 10:40

閱讀 840·2019-08-26 10:19

閱讀 2263·2019-08-23 18:16

閱讀 2319·2019-08-23 17:50