資訊專(zhuān)欄INFORMATION COLUMN

摘要:在現(xiàn)有深度學(xué)習(xí)框架下,我們所編寫(xiě)的卷積層往往是一個(gè)單行語(yǔ)句,它可以抽象出許多結(jié)構(gòu)細(xì)節(jié)。本文試圖闡述卷積層的一個(gè)特定的解剖特征,而這是在大多數(shù)文章和相關(guān)討論中被忽略的問(wèn)題。來(lái)自卷積層的輸出經(jīng)常用作后續(xù)卷積層的輸入。

近來(lái),深度學(xué)習(xí)的火爆程度顯而易見(jiàn),而在深度學(xué)習(xí)領(lǐng)域,卷積網(wǎng)絡(luò)則是引起這許多令人驚嘆的結(jié)果的主要原因。自從2012年AlexNet公開(kāi)亮相之后,現(xiàn)如今,我們很難列舉一個(gè)根本不使用卷積架構(gòu),具有突破性的計(jì)算機(jī)視覺(jué)架構(gòu)。

在現(xiàn)有深度學(xué)習(xí)框架下,我們所編寫(xiě)的卷積層往往是一個(gè)單行語(yǔ)句,它可以抽象出許多結(jié)構(gòu)細(xì)節(jié)。不過(guò),有時(shí)候后退一步去揭開(kāi)一些抽象概念也是一個(gè)不錯(cuò)的選擇。本文試圖闡述卷積層的一個(gè)特定的解剖特征,而這是在大多數(shù)文章和相關(guān)討論中被忽略的問(wèn)題。

許多卷積架構(gòu)是從一個(gè)外部卷積單元開(kāi)始的,它將信道RGB的輸入圖像映射到一系列內(nèi)部過(guò)濾器中。在當(dāng)下最通用的深度學(xué)習(xí)框架中,這個(gè)代碼可能如下所示:

out_1=Conv2d(input=image, filter=32, kernel_size=(3,3), strides=(1,1))

relu_out=relu(out_1)

pool_out=MaxPool(relu_out, kernel_size=(2,2), strides=2)

對(duì)許多人來(lái)說(shuō),我們都很清楚,上面的結(jié)果是一系列的具有32層深度的過(guò)濾器。我們不知道的是,該如何將具有3個(gè)信道的圖像較精確地映射到這32層中!另外,我們也不清楚該如何應(yīng)用較大池(max-pool)操作符。例如,是否一次性將較大池化應(yīng)用到了所有的過(guò)濾層中以有效地生成一個(gè)單一的過(guò)濾映射?又或者,是否將較大池獨(dú)立應(yīng)用于每個(gè)過(guò)濾器中,以產(chǎn)生相同的32層的池化過(guò)濾器?

如何做

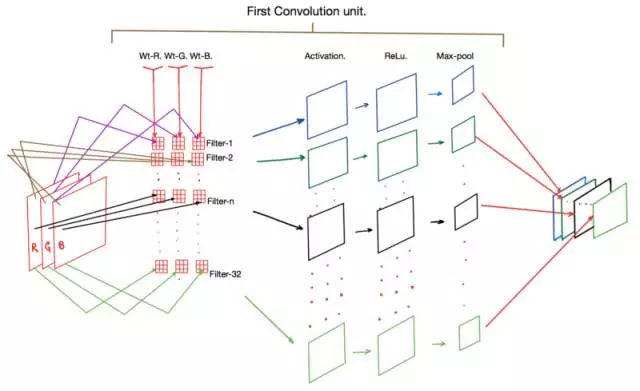

一張圖勝過(guò)千言萬(wàn)語(yǔ),下面有一個(gè)圖表,可以顯示上述代碼片段中所有的操作。

卷積層的應(yīng)用

觀察上圖,可以看到最顯著的一點(diǎn)是,步驟1中的每個(gè)過(guò)濾器(即過(guò)濾器-1、過(guò)濾器-2……)實(shí)際上包含一組3個(gè)卷積核(Wt-R、Wt-G和WT-B)。這些內(nèi)核中的每一個(gè)分別保存為輸入圖像中的紅(R)、綠(G)和藍(lán)(B)信道。

在正向傳播期間,圖像中的R、G和B像素值分別與Wt-R、Wt-G和Wt-B內(nèi)核相乘以產(chǎn)生一個(gè)間歇激活映射(intermittent activation map)(圖中未標(biāo)出)。然后將三個(gè)核的輸出相加以為每個(gè)過(guò)濾器產(chǎn)生一個(gè)激活映射。

隨后,這些激活中的每一個(gè)都要受到ReLu函數(shù)的支配,最后運(yùn)行到較大池化層,而后者主要負(fù)責(zé)減少輸出激活映射的維度。最后,我們得到的是一組激活映射,通常其維數(shù)是輸入圖像的一半,但現(xiàn)在其信號(hào)跨越了一組32個(gè)選擇(我們選擇作為過(guò)濾器的數(shù)量)作為二維張量。

來(lái)自卷積層的輸出經(jīng)常用作后續(xù)卷積層的輸入。因此,如果我們的第二個(gè)卷積單元如下:

conv_out_2 = Conv2d(input = relu_out,filters = 64)

那么框架就需要實(shí)例化64個(gè)過(guò)濾器,每個(gè)過(guò)濾器使用一組32個(gè)獨(dú)特的核。

為什么

另一個(gè)微妙的但重要的一點(diǎn),就是為什么我們?yōu)榈谝粋€(gè)卷積層使用了32個(gè)過(guò)濾器。在許多常用的體系結(jié)構(gòu)中,隨著我們深入網(wǎng)絡(luò),所使用的過(guò)濾器數(shù)量也越來(lái)越大(例如,第二個(gè)為64,第三個(gè)為128,依此類(lèi)推)。

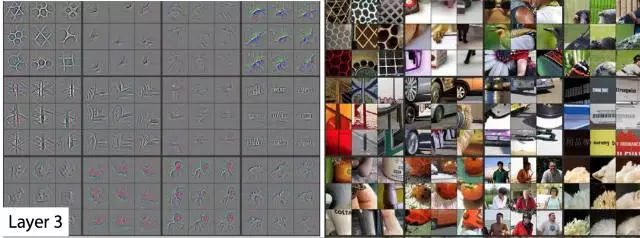

在本文中,Matt Zeiler使用了一個(gè)反卷積算子,以便可視化深度卷積結(jié)構(gòu)的不同層次和深度的核在訓(xùn)練過(guò)程中得到調(diào)諧。普遍的共識(shí)是,在經(jīng)過(guò)最優(yōu)訓(xùn)練的卷積網(wǎng)絡(luò)中,在邊緣(接近圖像)的濾波器對(duì)基本邊緣和圖案變得敏感。深層中的過(guò)濾器對(duì)逐漸升高的階數(shù)形狀和模式敏感。這些現(xiàn)象在Matt論文的圖表中得到了很好的總結(jié):

?在第一層和第二層(最外層)上過(guò)濾器激活的可視化

?

第三層過(guò)濾器激活的可視化

第4層和第5層的過(guò)濾器的可視化激活

另一個(gè)我想了很長(zhǎng)一段時(shí)間的問(wèn)題是,為什么不同的過(guò)濾器,即使在任何給定的層,都會(huì)被調(diào)整到一個(gè)特定的形狀或模式。畢竟,任何內(nèi)核的權(quán)重都沒(méi)有什么異常的,這可以保證觀察到的結(jié)果。正是到了這一點(diǎn):隨機(jī)梯度下降(SGD)的過(guò)程自動(dòng)糾正權(quán)重,使內(nèi)核獲得以上的特征。重要的是:

?核(或權(quán)重矩陣)被隨機(jī)初始化,以確保每個(gè)核都被優(yōu)化到一個(gè)獨(dú)特的解決方案空間。

?我們定義了足夠多的過(guò)濾器來(lái)較大限度地捕獲我們數(shù)據(jù)集中的各種特征,同時(shí)針對(duì)所發(fā)生的計(jì)算成本實(shí)現(xiàn)了平衡。

最后,許多論文還提出,過(guò)濾器激活的可視化為卷積結(jié)構(gòu)的性能提供了一個(gè)窗口。一個(gè)平衡的和高性能的網(wǎng)絡(luò)通常顯示如上所述的激活,具有明確的邊緣和形狀檢測(cè)器的表現(xiàn)。一個(gè)過(guò)度擬合、欠擬合和泛化的網(wǎng)絡(luò)往往無(wú)法顯示這些觀察結(jié)果。因此,使用(2)中使用的過(guò)程來(lái)測(cè)試網(wǎng)絡(luò)是一個(gè)好主意,以查看實(shí)驗(yàn)性的卷積網(wǎng)絡(luò)是否產(chǎn)生了良好的結(jié)果。

參考文獻(xiàn):

深度卷積神經(jīng)網(wǎng)絡(luò)的ImageNet分類(lèi),Alex Krizhevsky,Ilya Sutskever,Geoffrey E. Hinton,https://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks

卷積網(wǎng)絡(luò)的可視化與理解,Matthew D Zeiler,Rob Fergus https://arxiv.org/abs/1311.2901

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4665.html

摘要:第二部分高級(jí)概念我們現(xiàn)在對(duì)卷積有了一個(gè)良好的初步認(rèn)識(shí),也知道了卷積神經(jīng)網(wǎng)絡(luò)在干什么為什么它如此強(qiáng)大。 譯自Tim Dettmers的Understanding Convolution in Deep Learning。有太多的公開(kāi)課、教程在反復(fù)傳頌卷積神經(jīng)網(wǎng)絡(luò)的好,卻都沒(méi)有講什么是卷積,似乎默認(rèn)所有讀者都有相關(guān)基礎(chǔ)。這篇外文既友好又深入,所以翻譯了過(guò)來(lái)。文章高級(jí)部分通過(guò)流體力學(xué)量子力學(xué)等解釋...

摘要:文章第一部分旨在幫助讀者理解卷積的概念和深度學(xué)習(xí)中的卷積網(wǎng)絡(luò)。卷積定理要理解卷積,不得不提,它將時(shí)域和空域上的復(fù)雜卷積對(duì)應(yīng)到了頻域中的元素間簡(jiǎn)單的乘積。 譯者按:本文譯自 Tim Dettmers 的 Understanding Convolution in Deep Learning。有太多的公開(kāi)課、教程在反復(fù)傳頌卷積神經(jīng)網(wǎng)絡(luò)的好,卻都沒(méi)有講什么是「卷積」,似乎默認(rèn)所有讀者都有相關(guān)基礎(chǔ)。這...

摘要:年,發(fā)表,至今,深度學(xué)習(xí)已經(jīng)發(fā)展了十幾年了。年的結(jié)構(gòu)圖圖片來(lái)自于論文基于圖像識(shí)別的深度卷積神經(jīng)網(wǎng)絡(luò)這篇文章被稱(chēng)為深度學(xué)習(xí)的開(kāi)山之作。還首次提出了使用降層和數(shù)據(jù)增強(qiáng)來(lái)解決過(guò)度匹配的問(wèn)題,對(duì)于誤差率的降低至關(guān)重要。 1998年,Yann LeCun 發(fā)表Gradient-Based Learning Applied to Document Recognition,至今,深度學(xué)習(xí)已經(jīng)發(fā)展了十幾年了...

閱讀 2048·2021-11-08 13:22

閱讀 2509·2021-09-04 16:40

閱讀 1153·2021-09-03 10:29

閱讀 1718·2019-08-30 15:44

閱讀 2125·2019-08-30 11:13

閱讀 2793·2019-08-29 17:07

閱讀 1970·2019-08-29 14:22

閱讀 1252·2019-08-26 14:00