資訊專欄INFORMATION COLUMN

摘要:是第一個提出體積小,計算量少,適用于移動設備的卷積神經網絡。圖卷積運算匯總參考圖與神經網絡架構搜索卷積神經網絡已被廣泛用于圖像分類人臉識別目標檢測和其他領域。

1、基本卷積運算

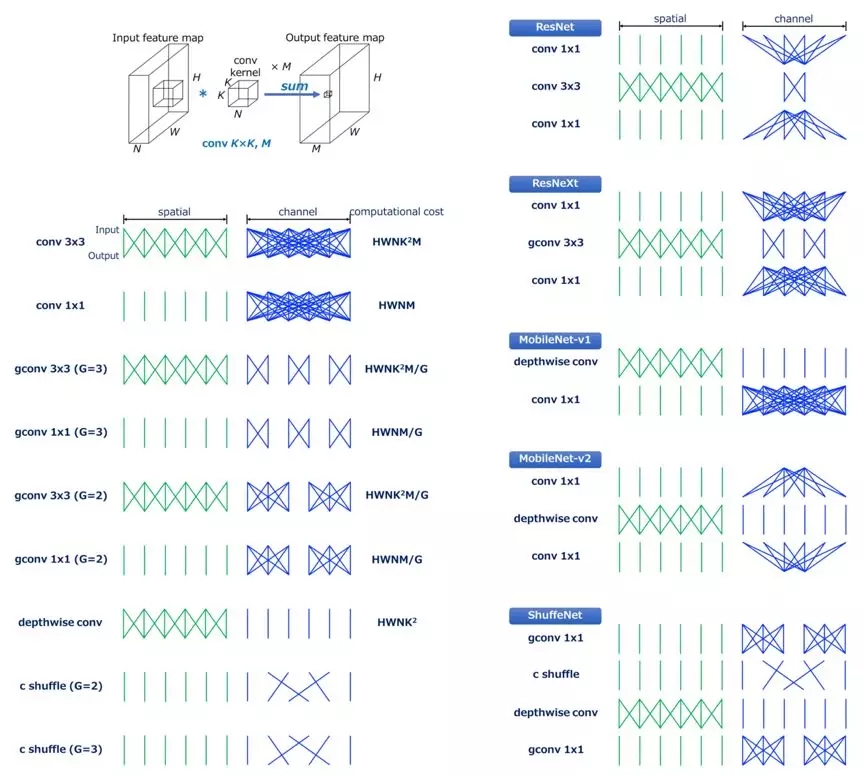

手工設計輕量化模型主要思想在于設計更高效的“網絡計算方式”(主要針對卷積方式),從而使網絡參數減少,并且不損失網絡性能。本節概述了CNN模型(如MobileNet及其變體)中使用的基本卷積運算單元,并基于空間維度和通道維度,解釋計算效率的復雜度。

1.1 標準卷積

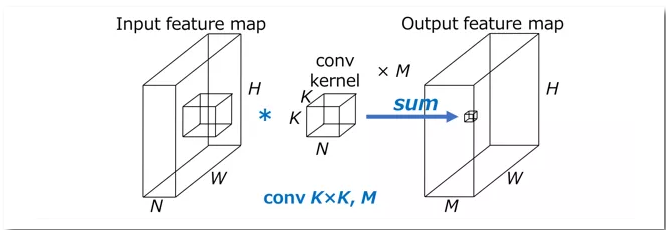

圖1標準卷積計算圖

HxW表示輸入特征圖空間尺寸(如圖1所示,H和W代表特征圖的寬度和高度,輸入和輸出特征圖尺寸不變),N是輸入特征通道數,KxK表示卷積核尺寸,M表示輸出卷積通道數,則標準卷積計算量是HWNK2M。

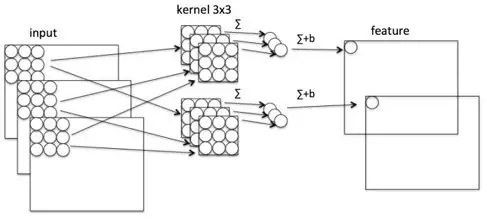

圖2標準卷積計算過程

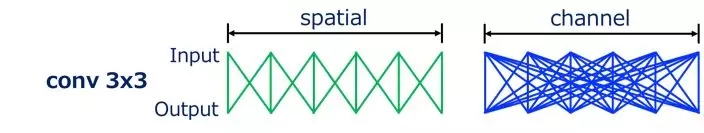

如圖3所示標準卷積在空間維度和通道維度直觀說明(以下示意圖省略“spatial“,”channel“,”Input“,”Output“),輸入特征圖和輸出特征圖之間連接線表示輸入和輸出之間的依賴關系。以conv3x3為例子,輸入和輸出空間“spatial”維度密集連接表示局部連接;而通道維度是全連接,卷積運算都是每個通道卷積操作之后的求和(圖2),和每個通道特征都有關,所以“channel”是互相連接的關系。

圖3標準卷積:空間維度和通道維度示意圖

1.2 Grouped Convolution

分組卷積是標準卷積的變體,其中輸入特征通道被為G組(圖4),并且對于每個分組的信道獨立地執行卷積,則分組卷積計算量是HWNK2M/G,為標準卷積計算量的1/G。

圖 4分組卷積:空間維度和通道維度示意圖

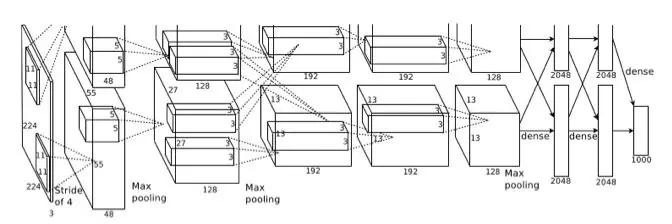

Grouped Convlution最早源于AlexNet。AlexNet在ImageNet LSVRC-2012挑戰賽上大顯神威,以優勢奪得冠軍,是卷積神經網絡的開山之作,引領了人工智能的新一輪發展。但是AlexNet訓練時所用GPU GTX 580顯存太小,無法對整個模型訓練,所以Alex采用Group convolution將整個網絡分成兩組后,分別放入一張GPU卡進行訓練(如圖5所示)。

圖5 AlexNet網絡架構

1.3 Depthwise convolution

Depthwise convolution[7]最早是由Google提出,是指將NxHxWxC輸入特征圖分為group=C組(既Depthwise 是Grouped Convlution的特殊簡化形式),然后每一組做k*k卷積,計算量為HWK2M(是普通卷積計算量的1/N,通過忽略通道維度的卷積顯著降低計算量)。Depthwise相當于多帶帶收集每個Channel的空間特征。

圖6 depthwise卷積

圖7 Depthwise卷積:空間維度和通道維度示意圖

1.4 pointwise convolution

Pointwise是指對NxHxWxC的輸入做 k個普通的 1x1卷積,如圖8,主要用于改變輸出通道特征維度。Pointwise計算量為HWNM。

Pointwise卷積相當于在通道之間“混合”信息。

圖8 Pointwise卷積

圖9 Pointwise卷積:空間維度和通道維度示意圖

1.5 Channel Shuffle

Grouped Convlution導致模型的信息流限制在各個group內,組與組之間沒有信息交換,這會影響模型的表示能力。因此,需要引入group之間信息交換的機制,即Channel Shuffle操作。

Channel shuffle是ShuffleNet提出的(如圖 5 AlexNet也有Channel shuffle機制),通過張量的reshape 和transpose,實現改變通道之間順序。

圖10 Channel shuffle:空間維度和通道維度示意圖

如圖10所示Channel shuffle G=2示意圖,Channel shuffle沒有卷積計算,僅簡單改變通道的順序。

?

2、人工設計神經網絡

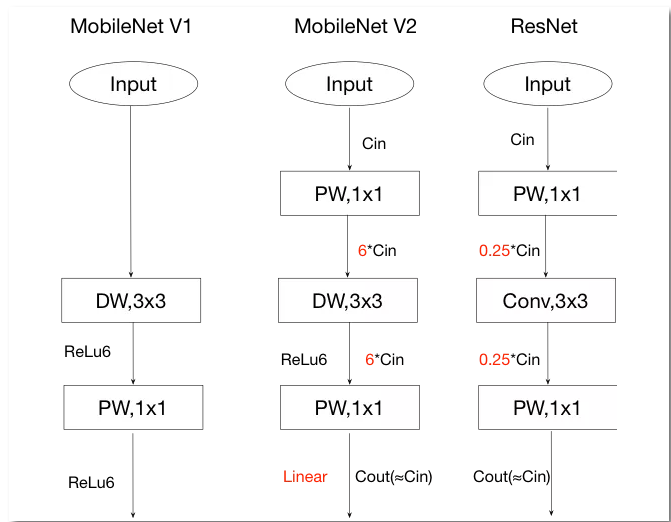

MobileNet V1&V2,ShuffleNet V1&V2有一個共同的特點,其神經網絡架構都是由基本Block單元堆疊,所以本章節首先分析基本Block架構的異同點,再分析整個神經網絡的優缺點。

2.1MobileNet V1

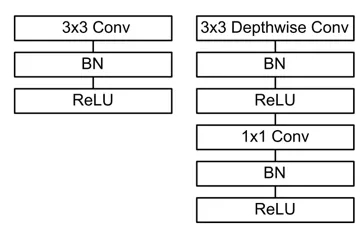

MobileNet V1是Google第一個提出體積小,計算量少,適用于移動設備的卷積神經網絡。MobileNet V1之所以如此輕量,背后的思想是用深度可分離卷積(Depthwise separable convolution)代替標準的卷積,并使用寬度因子(width multiply)減少參數量。

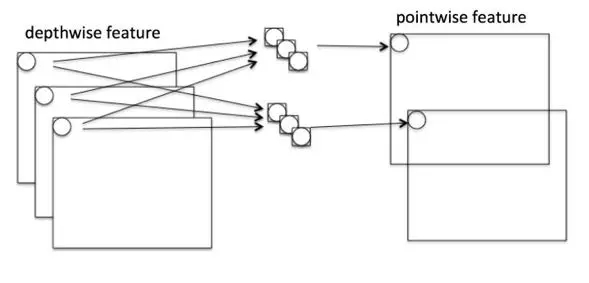

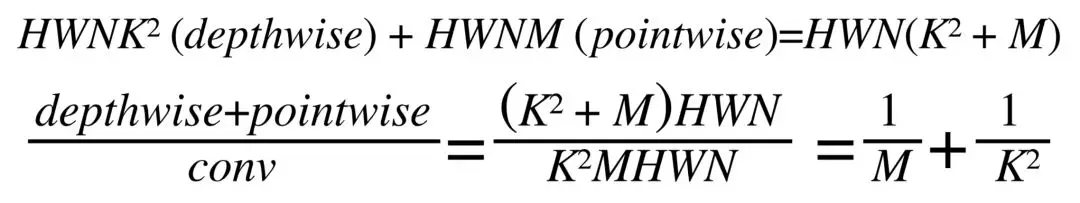

深度可分離卷積把標準的卷積因式分解成一個深度卷積(depthwise convolution)和一個逐點卷積(pointwise convolution)。如1.1標準卷積的計算量是HWNK2M,深度可分離卷積總計算量是:

一般網絡架構中M(輸出特征通道數)>>K2(卷積核尺寸) (e.g. K=3 and M ≥ 32),既深度可分離卷積計算量可顯著降低標準卷積計算量的1/8–1/9。

深度可分離卷積思想是channel相關性和spatial相關性解耦圖12。

圖11 Channel shuffle:標準卷積和深度和分離卷積架構對比

圖12深度可分離卷積:空間維度和通道維度示意圖

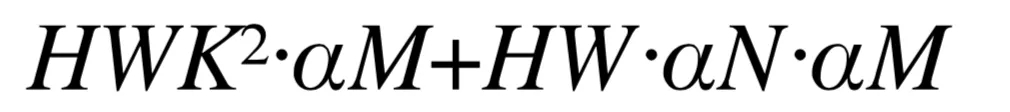

為了進一步降低Mobilenet v1計算量,對輸入輸出特征通道數M和N乘以寬度因子α(α∈(0,1),d典型值0.25,0.5和0.75),深度可分離卷積總計算量可以進一降低為:

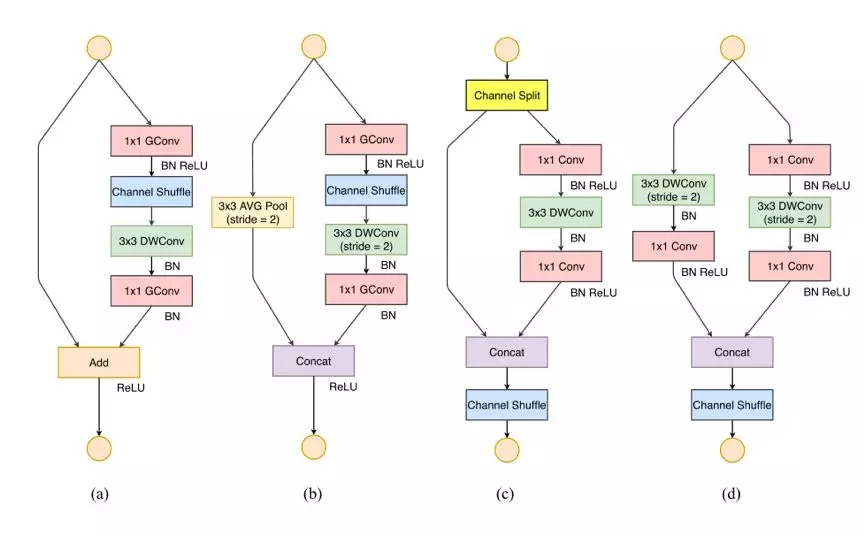

2.2 ShuffleNet V1

ShuffleNet是Face++提出的一種輕量化網絡結構,主要思路是使用Group convolution和Channel shuffle改進ResNet,可以看作是ResNet的壓縮版本。

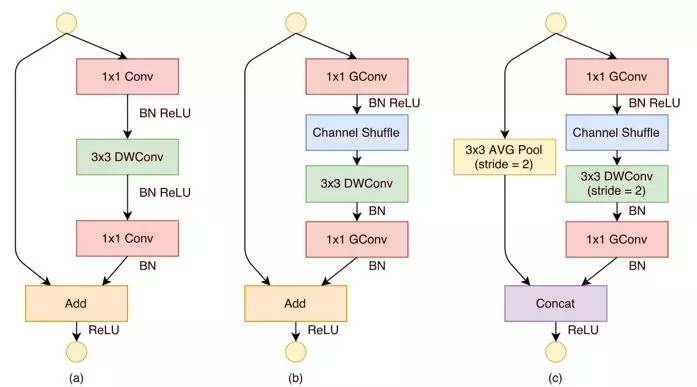

圖13展示了ShuffleNet的結構,其中(a)就是加入BatchNorm的ResNet bottleneck結構,而(b)和(c)是加入Group convolution和Channel Shuffle的ShuffleNet的結構。

圖13 shuffle V1 Block架構

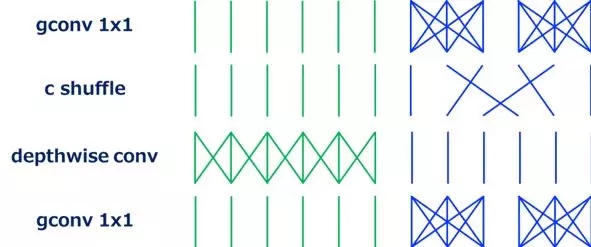

圖14 ShuffleNet V1 Block:空間維度和通道維度示意圖

如所示,ShuffleNet block最重要的操作是channel shuffle layer,在兩個分組卷積之間改變通道的順序,channel shuffle實現分組卷積的信息交換機制。

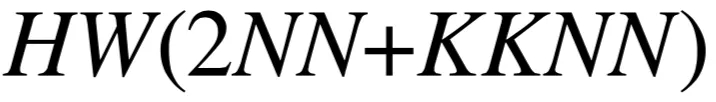

ResNet bottleneck計算量:

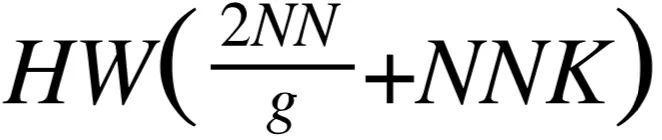

ShuffleNet stride=1計算量:

對比可知,ShuffleNet和ResNet結構可知,ShuffleNet計算量降低主要是通過分組卷積實現。ShuffleNet雖然降低了計算量,但是引入兩個新的問題:

1、channel shuffle在工程實現占用大量內存和指針跳轉,這部分很耗時。

2、channel shuffle的規則是人工設計,分組之間信息交流存在隨意性,沒有理論指導。

2.3 MobileNet V2

MobileNet V1設計時參考傳統的VGGNet等鏈式架構,既傳統的“提拉米蘇”式卷積神經網絡模型,都以層疊卷積層的方式提高網絡深度,從而提高識別精度。但層疊過多的卷積層會出現一個問題,就是梯度彌散(Vanishing)。殘差網絡使信息更容易在各層之間流動,包括在前向傳播時提供特征重用,在反向傳播時緩解梯度信號消失。于是改進版的MobileNet V2[3]增加skip connection,并且對ResNet和Mobilenet V1基本Block如下改進:

● 繼續使用Mobilenet V1的深度可分離卷積降低卷積計算量。

● 增加skip connection,使前向傳播時提供特征復用。

● 采用Inverted residual block結構。該結構使用Point wise convolution先對feature map進行升維,再在升維后的特征接ReLU,減少ReLU對特征的破壞。

圖15 Mobile V1, Mobile V2,ResNet架構對比

?

2.4 ShuffleNet V2

Mobile V1&V2,shuffle Net V1 在評價維度的共同特征是:使用FLOPS作為模型的評價標準,但是在移動終端設備時需要滿足各個條件:參數少、速度快和精度高,單一的參數少并不一定實現速度快和精度高。

Face++提出的ShuffeNet V2,實現使用直接指標(運算速度)代替間接評價指標(例如FLOPS),并在ARM等移動終端進行評估。并且基于減少計算量提出四個原則:

(1)使用輸入和輸出通道寬度不同增加卷積的計算量;

(2)組卷積增加MAC;

(3)多分支降低運算效率;

(4)元素級運算增加計算量。

如圖16所示

(a)Shu?eNet 基本單元;

(b)用于空間下采樣 (2×) 的 ShuffleNet 單元;

(c)Shu?eNet V2 的基本單元;

(d)用于空間下采樣 (2×) 的 ShuffleNet V2 單元。

ShuffleNet V2 引入通道分割(channel split)操作, 將輸入的feature maps分為兩部分:一個分支為shortcut流,另一個分支含三個卷積(且三個分支的通道數一樣)。分支合并采用拼接(concat),讓前后的channel數相同,最后進行Channel Shuffle(完成和ShuffleNet V1一樣的功能)。元素級的三個運算channel split、concat、Channel Shuffle合并一個Element-wise,顯著降低計算復雜度。

圖16 ShuffeNet V1 VS ShuffeNet V2架構

Shu?eNet V2雖然提出減少計算量的四個原則,基本卷積單元仍采用Depthwise和Pointwise降低計算量,但是沒有提出如何實現提高準確率,推斷延遲等評價指標。

對比MobileNet V1&V2,Shu?eNet V1&V2模型(圖17),手工設計輕量化模型主要得益于depth-wise convolution減少計算量,而解決信息不流暢的問題,MobileNet 系列采用了 point-wise convolution,ShuffleNet 采用的是 channel shuffle。

圖17 卷積運算匯總參考圖

3、NAS與神經網絡架構搜索

卷積神經網絡(CNN)已被廣泛用于圖像分類、人臉識別、目標檢測和其他領域。然而,為移動設備設計 CNN 是一項具有挑戰性的工作,因為移動端模型需要體積小、速度快,還要保持精準。盡管人們已經做了大量努力來設計和改進移動端模型,第二章所總結MobileNet系列、ShuffleNet系列。但手動設計高效模型仍然是一項挑戰,因為要考慮的因素太多。AutoML神經架構搜索的發展促進移動端 CNN 模型的自動化設計。

NAS的算法綜述可參看本人之前寫的一篇綜述文章《讓算法解放算法工程師----NAS綜述》[10]。在綜述文章中有關NAS的搜索空間,搜索策略,性能評估策略均已經做了總結,而且NAS的復現比較耗費GPU資源(NasNet做實驗時間使用500塊GPUx4天,一般項目組的資源難以望其項背),本章節主要是比較NAS設計的網絡與傳統手工設計神經網絡異同,以及NAS的發展方向。

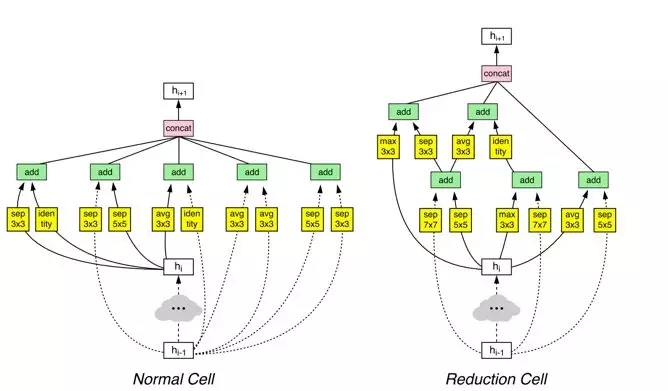

3.1 NasNet

NasNet是基于AutoML方法,首先在CIFAR-10這種小數據集上進行神經網絡架構搜索,以便 AutoML 找到較佳卷積層并靈活進行多次堆疊來創建最終網絡,并將學到的較好架構遷移到ImageNet圖像分類和 COCO 對象檢測中。NAS在搜索時使用的基本運算如下,包括常用的depthwise-separable,pool,3x3卷積等,使得block運行時對輸入尺寸沒有要求(例如卷積,pooling等操作)。這樣圖像由cifar的32 x32到imagenet的大尺寸圖片均可實現分類任務。

NasNet設計基于人類的經驗,設計設計兩類 Cells:Normal cell 和Reduction cell(圖 19) 。Normal cell不改變輸入feature map的大小的卷積, 而reduction cell將輸入feature map的長寬各減少為原來的一半的卷積,是通過增加stride的大小來降低size。通過NasNet構建堆疊模塊(cells)的深度實現架構的設計。

圖18 NasNet基本Cell

圖18 NasNet基本CellNasNet首先基于人類的一些先驗知識:卷積運算類型、Cell連接方式,Cell內的多分支拓撲結構,這些是積木。NasNet的搜索算法就是搭積木的過程,不斷嘗試各種可行的架構,通過代理評價指標確定模型的性能,實現全局最優搜索。

圖19 NasNet分類任務基本架構

NasNet雖然實現準確率state-of-art水平,但是推斷延時較大,在移動端對實時性苛刻場景難以大規模運用。

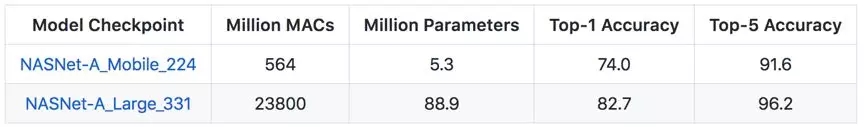

3.2 MnasNet

MnasNet是Google提出的探索了一種使用強化學習設計移動端模型的自動化神經架構搜索方法,并且實現準確率和運算速率突破。MnasNet 能夠找到運行速度比 MobileNet V2快 1.5 倍、比 NASNet 快 2.4 倍的模型,同時達到同樣的 ImageNet top-1 準確率。

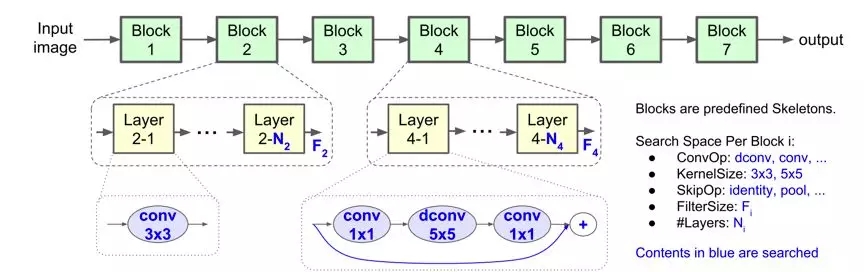

圖20 MnasNet搜索空間

MnasNet的搜索空間與NasNet類似,但是搜索目標函數同時考慮準確率和速率:

m 表示模型,ACC(m) 表示目標模型的準確率,LAT(m) 表示耗時,T 表示目標耗時。而論文提出一種策略,基于梯度的強化學習方法尋找帕雷托最優,同時對 ACC(m) 和 LAT(m) 帕雷托改善。

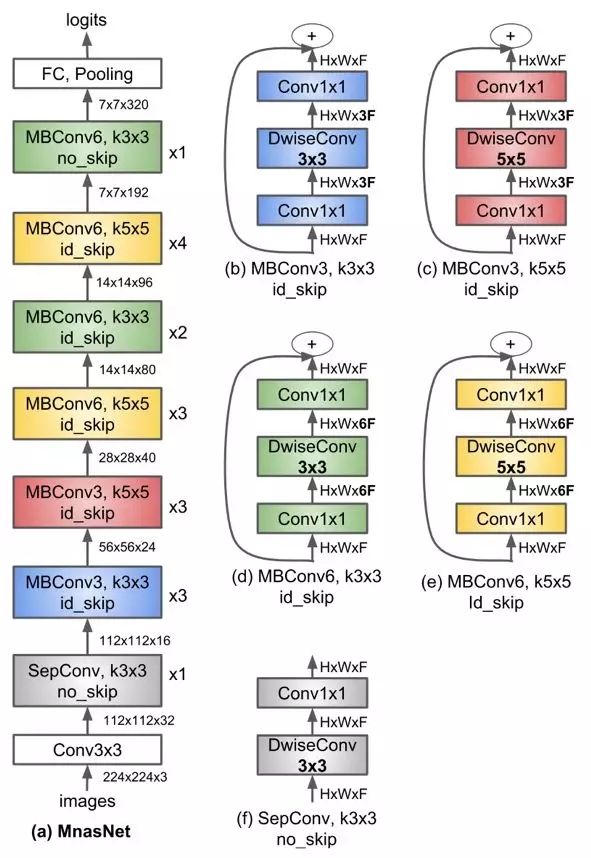

圖21 MnasNet基本架構

如圖21顯示了 MnasNet 算法的神經網絡架構,包含一系列線性連接 blocks,每個 block 雖然包含不同類別的卷積層,每一卷積層都包含 depthwise convolution 卷積操作,較大化模型的計算效率。但是和 MobileNet V1&V2 等算法有明顯不同:

1、模型使用更多 5x5 depthwise convolutions。

2、層分級的重要性。很多輕量化模型重復 block 架構,只改變濾波器尺寸和空間維度。論文提出的層級搜索空間允許模型的各個 block 包括不同的卷積層。

3、論文使用強化學習的思路,首先確定了 block 的連接方式,在每個 block 使用層級搜索空間,確定每個卷積層的卷積類型,卷積核、跳躍層連接方式,濾波器的尺寸等。其基本策略還是延續人工設計神經網絡思路。

3.3 NAS發展方向

1、NAS的搜索空間有很大的局限性。目前NAS算法仍然使用手工設計的結構和blocks,NAS僅僅是將這些blocks堆疊。人工痕跡太過明顯,NAS還不能自行設計網絡架構。NAS的一個發展方向是更廣泛的搜索空間,尋找真正有效率的架構,當然對搜索策略和性能評估策略提出更高的要求。

2、以google的NAS為基礎,很多模型專注于優化模型的準確率而忽視底層硬件和設備,僅考慮準確率高的模型難以在移動終端部署。研究針對多任務和多目標問題的 NAS,基于移動端的多目標神經網絡搜索算法,評價指標從準確率擴展到功耗、推斷延時、計算復雜度、內存占用、FLOPs等指標,解決移動端實際應用問題。

3、目前的NAS發展是以分類任務為主,在分類任務設計的模型遷移到目標檢測語義分割模型中。

Google在Cloud AutoML不斷發力,相比較而言之前的工作只是在圖像分類領域精耕細作,如今在圖像語義分割開疆擴土,在arxiv提交第一篇基于NAS(Neural network architecture)的語義分割模型[12](DPC,dense prediction cell),已經被NIPS2018接收,并且在Cityscapes,PASCAL-Person-Part,PASCAL VOC 2012取得state-of-art的性能(mIOU超過DeepLabv3+),和更高的計算效率(模型參數少,計算量減少)。

如果讓強化學習自己選擇模型的架構,比如 Encoder-Decoder,U-Net,FPN等,相信在目標檢測、實體分割等領域會有更好的表現。

4、AutoML自動模型壓縮

CNN模型替代了傳統人工設計(hand-crafted)特征和分類器,不僅提供了一種端到端的處理方法,不斷逼近計算機視覺任務的精度極限的同時,其深度和尺寸也在成倍增長。工業界不僅在設計輕量化模型(MobileNet V1&V2,ShuffleNet V1&V2系列),也在不斷實踐如何進一步壓縮模型,在便攜式終端設備實現準確率、計算速率、設備功耗、內存占用的小型化。

CNN模型壓縮是在計算資源有限、能耗預算緊張的移動設備上有效部署神經網絡模型的關鍵技術。本文簡介概述CNN模型壓縮主流算法,重點介紹如何實現基于AutoML的模型壓縮算法。

4.1 CNN模型壓縮概述

CNN模型壓縮是從壓縮模型參數的角度降低模型的計算量。

在第2節介紹的人工設計輕量型神經網絡結構,多是依賴Grouped Convlution、Depthwise、Pointwise、Channel Shuffle這些基本單元組成的Block,但是這些設計方法存在偶然性,不是搜索空間的最優解。

韓松提出的Deep compression[5]獲得 ICLR2016年的best paper,也是CNN模型壓縮領域經典之作。論文提出三種方法:剪枝、權值共享和權值量化、哈夫曼編碼。剪枝就是去掉一些不必要的網絡權值,只保留對網絡重要的權值參數;權值共享就是多個神經元見的連接采用同一個權值,權值量化就是用更少的比特數來表示一個權值。對權值進行哈夫曼編碼能進一步的減少冗余。 作者在經典的機器學習算法,AlexNet和VGG-16上運用上面這些模型壓縮的方法,在沒有精度損失的情況下,把AlexNet模型參數壓縮了35倍,把VGG模型參數壓縮了49倍,并且在網絡速度和網絡能耗方面也取得了很好的提升。

CNN模型壓縮沿著Deep compression的思路,壓縮算法可分為四類:參數修剪和共享、低秩分解、遷移/壓縮卷積濾波器和知識蒸餾等。基于參數修剪(parameter pruning)和共享的方法關注于探索模型參數中冗余的部分,并嘗試去除冗余和不重要的參數。基于低秩分解(Low-rank factorization)技術的方法使用矩陣/張量分解以估計深層 CNN 中最具信息量的參數。基于遷移/壓縮卷積濾波器(transferred/compact convolutional filters)的方法設計了特殊結構的卷積濾波器以減少存儲和計算的復雜度。而知識精煉(knowledge distillation)則學習了一個精煉模型,即訓練一個更加緊湊的神經網絡以再現大型網絡的輸出結果。

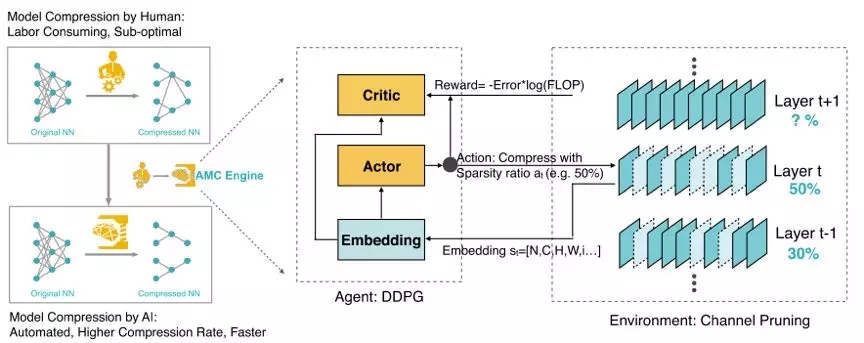

4.2 AMC

傳統的模型壓縮技術依賴手工設計的啟發式和基于規則的策略,需要算法設計者探索較大的設計空間,在模型大小、速度和準確率之間作出權衡,而這通常是次優且耗時的。西安交通大學與Google提出了適用于模型壓縮的AMC[8](AutoML for Model Compres- sion,AMC),利用強化學習提供模型壓縮策略。

這種基于學習的壓縮策略性能優于傳統的基于規則的壓縮策略,具有更高的壓縮比,在更好地保持準確性的同時節省了人力成本。

1、Problem Definition

模型壓縮在維度上可分為Fine-grained pruning和Coarse-grained/structured pruning。Fine-grained pruning主要實現剪枝權重的非重要張量,實現非常高的壓縮率同時保持準確率。Coarse-grained pruning旨在剪枝權重張量的整個規則區域(例如,通道,行,列,塊等),例如在MobileNet V1&V2均存在寬度因子α對通道特征進行瘦身,但是寬度因子α對每一層的通道特征都固定比率壓縮。

假設權重張量是n x c x k x k,c,n分別是輸入輸出通道數,k是卷積核尺寸。對于fine-grained pruning,稀疏度定義為零元素的數量除以總元素的數量既zeros/(n x c x k x h),而channel pruning,權重張量縮小為n x c’ x k x k,既稀疏度為c’/c。

但是壓縮模型的精度對每層的稀疏性非常敏感,需要細粒度的動作空間。因此,論文在一個離散的空間上搜索,而是通過 DDPG agent 提出連續壓縮比控制策略(圖 20),通過反復試驗來學習:在精度損失時懲罰,在模型縮小和加速時鼓勵。actor-critic 的結構也有助于減少差異,促進更穩定的訓練。

圖 20 AMC引擎示意圖

2、搜索空間

AMC對每一層t定義了11個特征表示st的狀態:

t是層序號,卷積核尺寸是n x c x k x k,輸入特征尺寸是c x h x w,FLOPs[t]是Lt層的FLOPs,Reduced是上一層減少的FLOPs,Rest表示下一層的FLOPs,這些特征全部歸一化到[0, 1]。

3、搜索評估策略

通過限制動作空間既每一卷積層層的稀疏率(sparsity ratio),論文提出分別針對latency-critical和quality-critical應用提出兩種損失函數:

對于latency-critical的AI應用(例如,手機APP,自動駕駛汽車和廣告排名),AMC采用資源受限的壓縮(resource-constrained compression),在較大硬件資源(例如,FLOP,延遲和模型大小)下實現較佳精度;

對于quality-critical的AI應用(例如Google Photos),AMC提出精度保證的壓縮(accuracy-guaranteed compression),在實現最小尺寸模型的同時不損失精度。

3、結論

本文提出AutoML模型壓縮(AMC),利用增強學習自動搜索設計空間,大大提高了模型壓縮質量。我們還設計了兩種新的獎勵方案來執行資源受限壓縮和精度保證壓縮。在Cifar和ImageNet上采用AMC方法對MobileNet、MobileNet-v2、ResNet和VGG等模型進行壓縮,取得了令人信服的結果。在谷歌Pixel1手機上,我們將MobileNet的推理速度從8.1fps提升到16.0 fps。AMC促進了移動設備上的高效深度神經網絡設計。

論文提出的壓縮方法,僅僅從通道特征的稀疏度考慮,壓縮算法粗放,沒有全局考慮模型的其他能力,另外論文目前沒有公布源碼,論文的復現還需要一些細節需要商榷。

4.3 PocketFlow

騰訊AI Lab機器學習中心近日宣布成功研發出世界上首款自動化深度學習模型壓縮框架——PocketFlow,但是截止筆記成稿時仍未公布源碼。

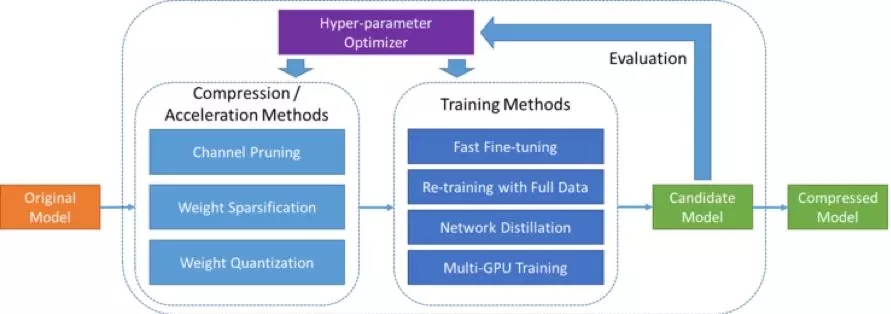

PocketFlow框架主要由兩部分組件構成,分別是模型壓縮/加速算法組件和超參數優化組件,具體結構如所示。

圖21 PocketFlow框架示意圖

開發者將未壓縮的原始模型作為PocketFlow框架的輸入,同時指定期望的性能指標,例如模型的壓縮和/或加速倍數;在每一輪迭代過程中,超參數優化組件選取一組超參數取值組合,之后模型壓縮/加速算法組件基于該超參數取值組合,對原始模型進行壓縮,得到一個壓縮后的候選模型;基于對候選模型進行性能評估的結果,超參數優化組件調整自身的模型參數,并選取一組新的超參數取值組合,以開始下一輪迭代過程;當迭代終止時,PocketFlow選取最優的超參數取值組合以及對應的候選模型,作為最終輸出,返回給開發者用作移動端的模型部署。

4.4 TensorFlow Lite

TensorFlow Lite近日發布了一個新的優化工具包,引入post-training模型量化技術[9], 將模型大小縮小了4倍,執行速度提升了3倍!通過量化模型,開發人員還將獲得降低功耗的額外好處。這對于將模型部署到手機之外的終端設備是非常有用的(注:目前無參考文獻論述TensorFlow Lite 的post-training模型量化原理,但是從源代碼可見壓縮方式是采用Int8)。

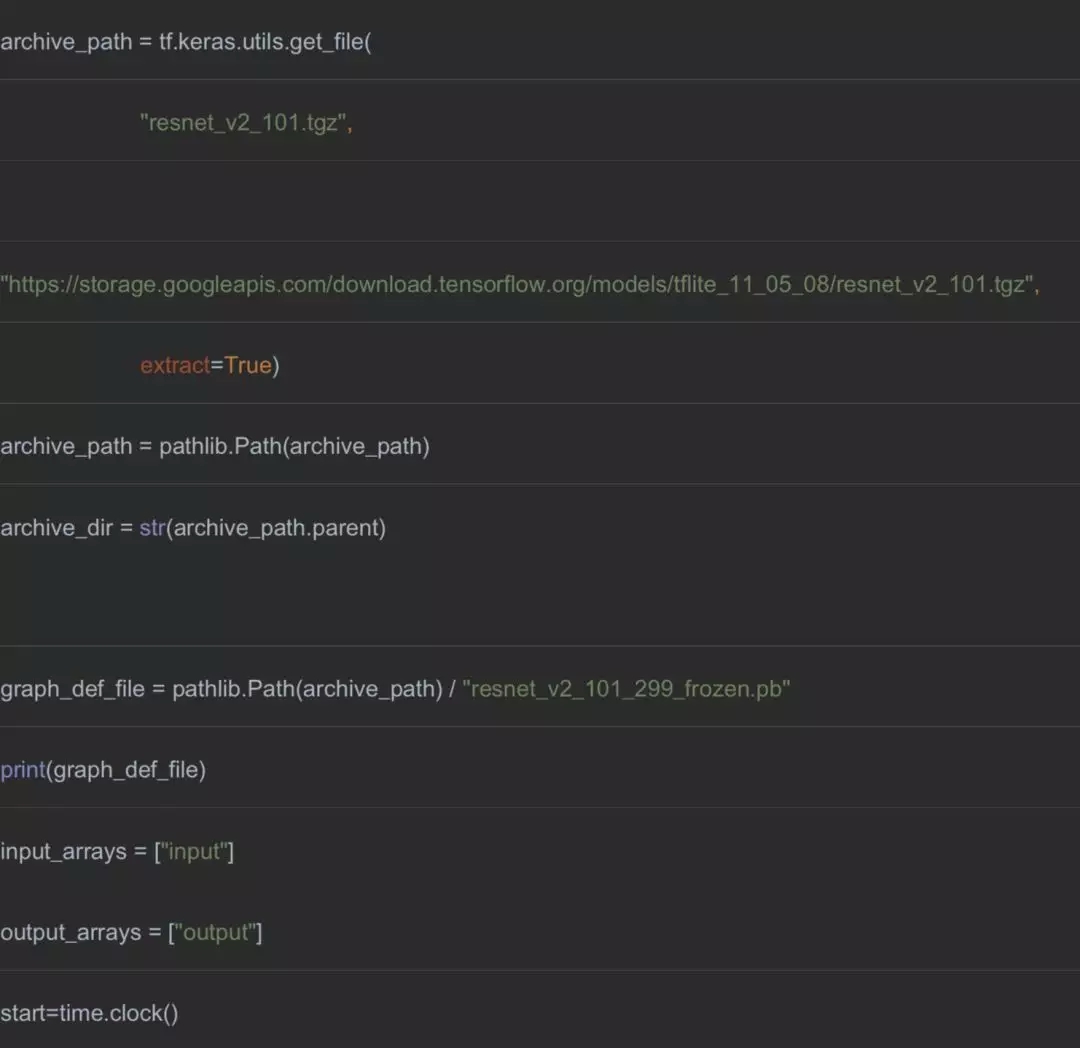

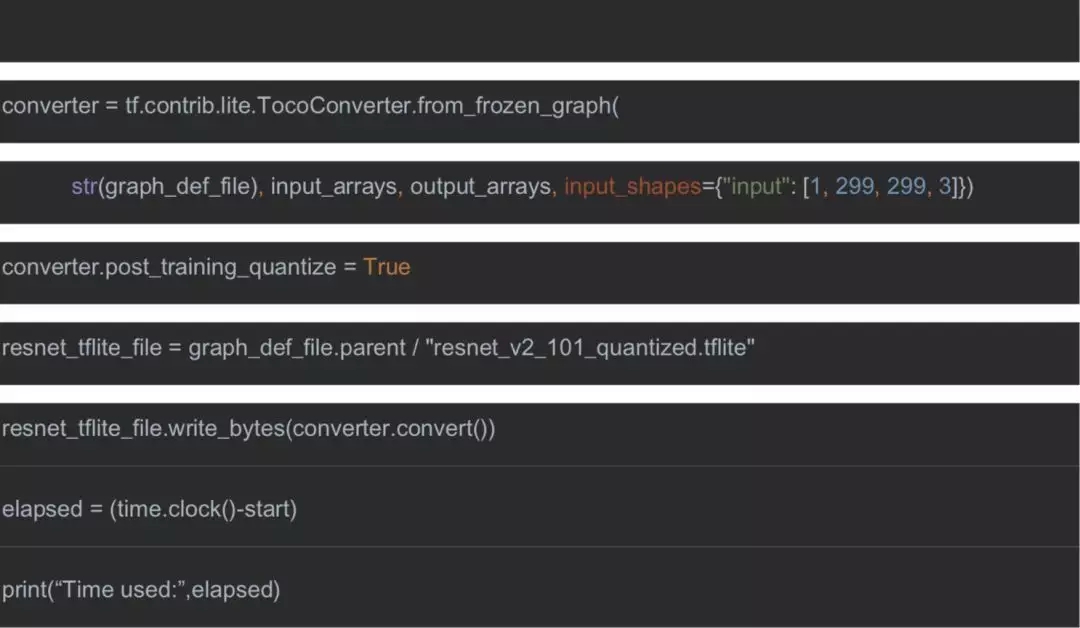

實驗環境需要卸載tensorflow并安裝tf-nightly。

pip uninstall -y tensorflow

pip install -U tf-nightly

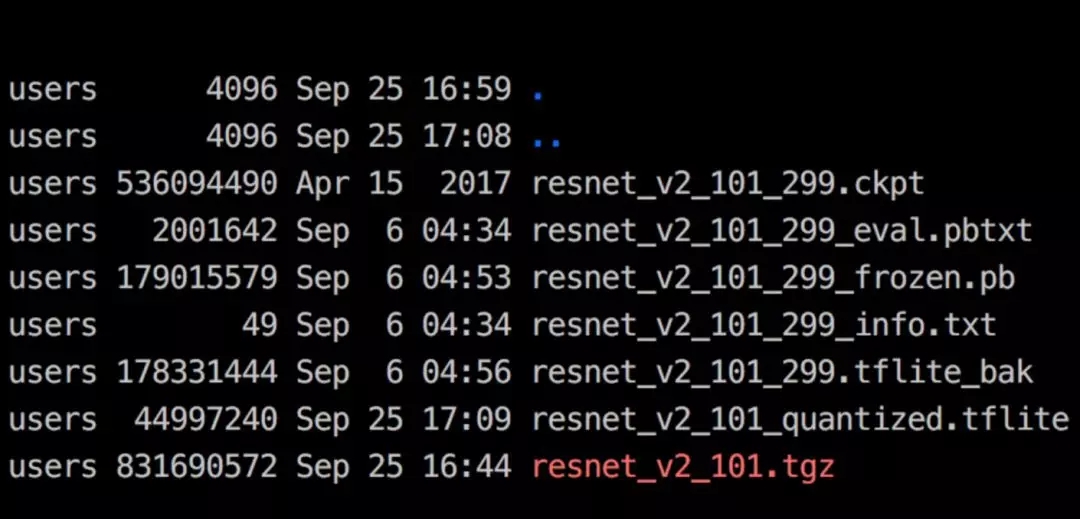

量化壓縮模型實現很簡單,一下程序完成下載resnet_v2_101.tgz模型并解壓,設置converter.post_training_quantize = True,即可自動化實現,如所示, 作者在GPU M40實驗,量化輸出resnet_v2_101_quantized.tflite,僅用時3.76秒實現模型resnet_v2_101的量化壓縮,模型尺寸從179MB壓縮到45MB(圖22),優化后的模型在ImageNet ?top-1 準確率是76.8,與壓縮前模型準確率相同。

圖22 post-training模型量化實驗目錄

以上僅為個人閱讀論文后的理解,總結和一些思考,觀點難免偏差,望讀者以懷疑的態度閱讀,歡迎交流指正。

[1] ? ? ?Chollet, F.: Xception: Deep learning with depthwise separable convolutions. arXiv preprint (2016)

[2] ? ? ?Howard, A.G., Zhu, M., Chen, B., Kalenichenko, D., Wang, W., Weyand, T., An- dreetto, M., Adam, H.: Mobilenets: Efficient convolutional neural networks for mobile vision applications. arXiv preprint arXiv:1704.04861 (2017)

[3] ? ? ?Sandler, M., Howard, A., Zhu, M., Zhmoginov, A., Chen, L.C.: Inverted residuals and linear bottlenecks: Mobile networks for classification, detection and segmenta- tion. arXiv preprint arXiv:1801.04381 (2018)

[4] ? ? ?Zhang, X., Zhou, X., Lin, M., Sun, J.: Shufflenet: An extremely efficient convolu- tional neural network for mobile devices. arXiv preprint arXiv:1707.01083 (2017)

[5] ? ? ?Han, S., Mao, H., Dally, W.J., 2015a. Deep compression:Compressing deep neural networks with pruning,trained quantization and huffman coding. arXiv preprint arXiv:1510.00149(2015)

[6] ? ? ?Z. Qin, Z. Zhang, X. Chen, and Y. Peng, “FD-MobileNet: Improved MobileNet with a Fast Downsampling Strategy,” in arXiv:1802.03750, 2018.

[7] ? ? ?F. Chollet, “Xception: Deep Learning with Depthwise Separable Convolutions,” in Proc. of CVPR, 2017.

[8] ? ? ?Yihui He, Ji Lin, Zhijian Liu, Hanrui Wang, Li-Jia Li, and Song Han. AMC: AutoML for Model Compression and Acceleration on Mobile Devices. arXiv preprint arXiv: 1802.03494 (2018)

[9] ?https://github.com/tensorflow/tensorflow/blob/master/tensorflow/contrib/lite/tutorials/

[10] ? 讓算法解放算法工程師----NAS綜述,https://zhuanlan.zhihu.com/p/44576620

[11] ? Mingxing Tan, Bo Chen, Ruoming Pang, Vijay Vasudevan, and Quoc V Le. Mnasnet: Platform-aware neural architecture search for mobile. arXiv preprint arXiv:1807.11626, 2018.

[12] ? Liang-Chieh Chen,Maxwell D. Collins,Yukun Zhu,George Papandreou: Searching for Efficient Multi-Scale Architectures for Dense Image Prediction .arXiv preprint arXiv:1809.04184 (2018)

聲明:文章收集于網絡,如有侵權,請聯系小編及時處理,謝謝!

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/4822.html

摘要:目錄一引言二輕量化模型三網絡對比一引言自年以來,卷積神經網絡簡稱在圖像分類圖像分割目標檢測等領域獲得廣泛應用。創新點利用和這兩個操作來設計卷積神經網絡模型以減少模型使用的參數數量。 本文就近年提出的四個輕量化模型進行學習和對比,四個模型分別是:SqueezeNet、MobileNet、ShuffleNet、Xception。目錄一、引言?二、輕量化模型?? ? 2.1 SqueezeNet?...

對比內容UCloudStackZStackVMwareQingCloud騰訊TStack華為云Stack優勢總結?基于公有云自主可控?公有云架構私有化部署?輕量化/輕運維/易用性好?政府行業可復制案例輕量化 IaaS 虛擬化平臺?輕量化、產品成熟度高?業內好評度高?功能豐富、交付部署快?中小企業案例多全套虛擬產品及云平臺產品?完整生態鏈、技術成熟?比較全面且健全的渠道?產品成熟度被市場認可,市場占...

摘要:百度智能云百度智能云為中小企業與開發者提供云服務器專屬福利,雙十一上云鉅惠盛典活動返場,優惠持續。產品更加輕量化,預裝多場景所需的應用軟件,精準服務于小中型企業。 百度智能云為中小企業與開發者提供云服務器專屬福利,雙十一上云鉅惠盛典活動返場,優惠持續。新用戶專享折扣產品,中小型企業與開發者上云的不二選擇,1核2G4M輕量云服務器,60Gb SSD磁盤,流量不限!點擊進入:百度...

摘要:隨著商用的推進和物聯網發展,數據的爆發式增長以及對算力的更高,要求使得邊緣計算勢不可擋,正式站上市場風口。緊跟技術融合云計算物聯網等應用融合場景融合的趨勢,邊緣容器有望成為基礎設施領域的下一個技術趨勢,容器服務的推出,正當時。隨著5G商用的推進和物聯網發展,數據的爆發式增長、以及對算力的更高,要求使得邊緣計算勢不可擋,正式站上市場風口。將低延遲、高性能的邊緣計算,與具備天然輕量化和可移植性的...

閱讀 2963·2021-11-22 15:25

閱讀 2246·2021-11-18 10:07

閱讀 1053·2019-08-29 15:29

閱讀 480·2019-08-29 13:25

閱讀 1512·2019-08-29 12:58

閱讀 3207·2019-08-29 12:55

閱讀 2919·2019-08-29 12:28

閱讀 510·2019-08-29 12:16