資訊專欄INFORMATION COLUMN

摘要:為了探索多種訓(xùn)練方案,何愷明等人嘗試了在不同的迭代周期降低學(xué)習(xí)率。實(shí)驗(yàn)中,何愷明等人還用預(yù)訓(xùn)練了同樣的模型,再進(jìn)行微調(diào),成績沒有任何提升。何愷明在論文中用來形容這個(gè)結(jié)果。

何愷明,RBG,Piotr Dollár。

三位從Mask R-CNN就開始合作的大神搭檔,剛剛再次聯(lián)手,一文“終結(jié)”了ImageNet預(yù)訓(xùn)練時(shí)代。

他們所針對的是當(dāng)前計(jì)算機(jī)視覺研究中的一種常規(guī)操作:管它什么任務(wù),拿來ImageNet預(yù)訓(xùn)練模型,遷移學(xué)習(xí)一下。

但是,預(yù)訓(xùn)練真的是必須的嗎?

這篇重新思考ImageNet預(yù)訓(xùn)練(Rethinking ImageNet Pre-training)就給出了他們的答案。

FAIR(Facebook AI Research)的三位研究員從隨機(jī)初始狀態(tài)開始訓(xùn)練神經(jīng)網(wǎng)絡(luò),然后用COCO數(shù)據(jù)集目標(biāo)檢測和實(shí)例分割任務(wù)進(jìn)行了測試。結(jié)果,絲毫不遜于經(jīng)過ImageNet預(yù)訓(xùn)練的對手。

甚至能在沒有預(yù)訓(xùn)練、不借助外部數(shù)據(jù)的情況下,和COCO 2017冠軍平起平坐。

結(jié)果

訓(xùn)練效果有圖有真相。

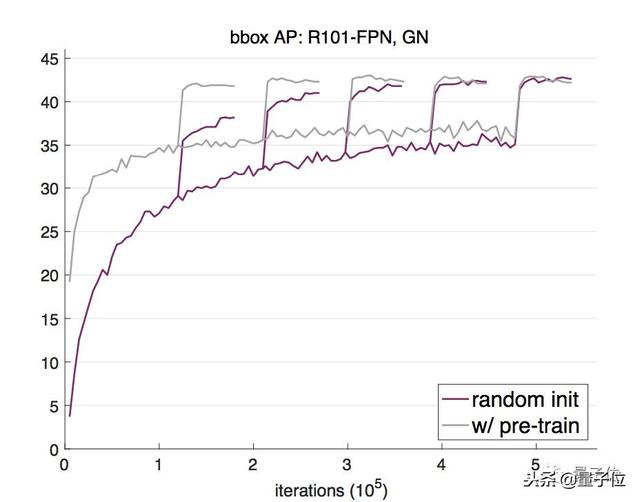

他們用2017版的COCO訓(xùn)練集訓(xùn)練了一個(gè)Mask R-CNN模型,基干網(wǎng)絡(luò)是用了群組歸一化(GroupNorm)的ResNet-50 FPN。

隨后,用相應(yīng)的驗(yàn)證集評估隨機(jī)權(quán)重初始化(紫色線)和用ImageNet預(yù)訓(xùn)練后再微調(diào)(灰色線)兩種方法的邊界框平均檢測率(AP)。

可以看出,隨機(jī)權(quán)重初始化法開始不及預(yù)訓(xùn)練方法效果好,但隨著迭代次數(shù)的增加,逐漸達(dá)到了和預(yù)訓(xùn)練法相當(dāng)?shù)慕Y(jié)果。

為了探索多種訓(xùn)練方案,何愷明等人嘗試了在不同的迭代周期降低學(xué)習(xí)率。

結(jié)果顯示,隨機(jī)初始化方法訓(xùn)練出來的模型需要更多迭代才能收斂,但最終收斂效果不比預(yù)訓(xùn)練再微調(diào)的模型差。

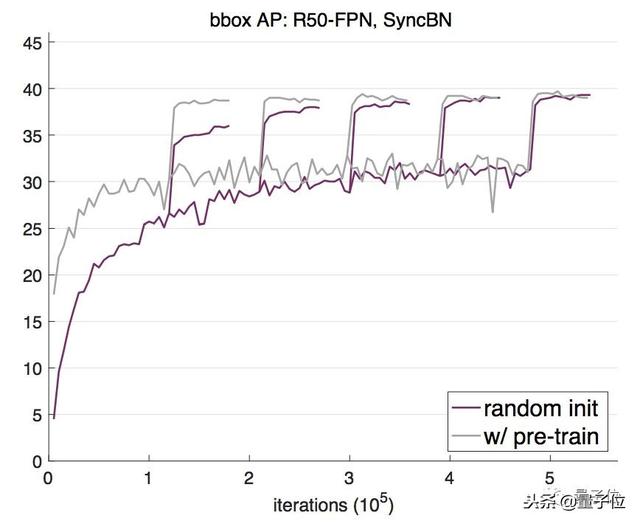

主干網(wǎng)絡(luò)換成ResNet-101 FPN,這種從零開始訓(xùn)練的方法依然呈現(xiàn)出一樣的趨勢:從零開始先是AP不及預(yù)訓(xùn)練法,多次迭代后兩者終趨于不分上下。

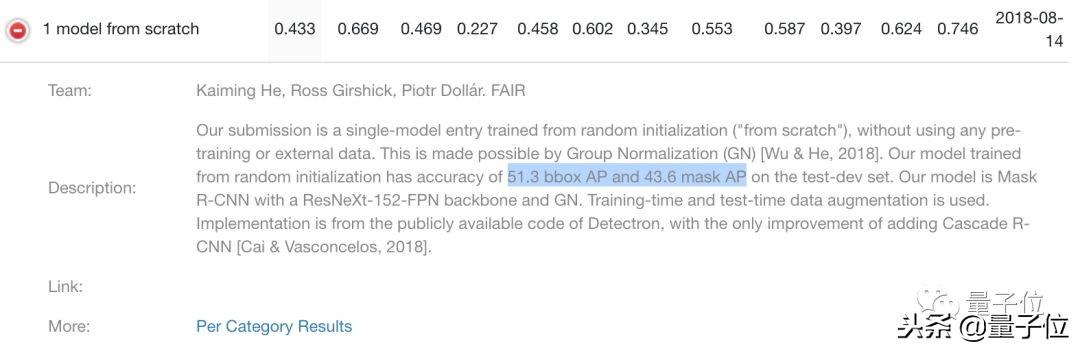

效果究竟能有多好?答案前面也說過了,和COCO 2017冠軍選手平起平坐。

從零開始模型的效果,由COCO目標(biāo)檢測任務(wù)來證明。在2017版驗(yàn)證集上,模型的bbox(邊界框)和mask(實(shí)例分割)AP分別為50.9和43.2;

他們還在2018年競賽中提交了這個(gè)模型,bbox和mask AP分別為51.3和43.6。

這個(gè)成績,在沒有經(jīng)過ImageNet預(yù)訓(xùn)練的單模型中是較好的。

這是一個(gè)非常龐大的模型,使用了ResNeXt-152 8×32d基干,GN歸一化方法。從這個(gè)成績我們也能看出,這個(gè)大模型沒有明顯過擬合,非常健壯(robust)。

實(shí)驗(yàn)中,何愷明等人還用ImageNet預(yù)訓(xùn)練了同樣的模型,再進(jìn)行微調(diào),成績沒有任何提升。

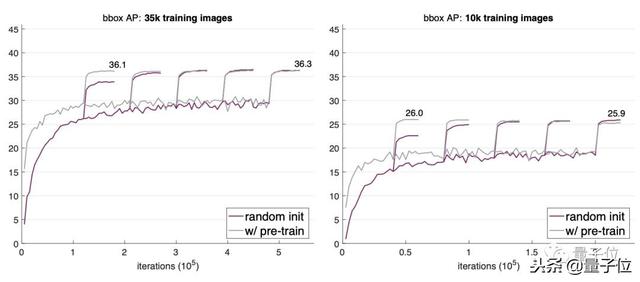

這種健壯性還有其他體現(xiàn)。

比如說,用更少的數(shù)據(jù)進(jìn)行訓(xùn)練,效果還是能和預(yù)訓(xùn)練再微調(diào)方法持平。何愷明在論文中用“Even more surprising”來形容這個(gè)結(jié)果。

當(dāng)他們把訓(xùn)練圖像數(shù)量縮減到整個(gè)COCO數(shù)據(jù)集的1/3(35000張圖)、甚至1/10(10000張圖)時(shí),經(jīng)過多次迭代,隨機(jī)初始化看起來還略優(yōu)于預(yù)訓(xùn)練法的效果。

不過,10000張圖已經(jīng)是極限,繼續(xù)降低數(shù)據(jù)量就不行了。當(dāng)他們把訓(xùn)練數(shù)據(jù)縮減到1000張圖片,出現(xiàn)了明顯的過擬合。

怎樣訓(xùn)練?

想拋棄ImageNet預(yù)訓(xùn)練,用不著大動(dòng)干戈提出個(gè)新架構(gòu)。不過,兩點(diǎn)小改動(dòng)在所難免。

第一點(diǎn)是模型的歸一化方法,第二點(diǎn)是訓(xùn)練長度。

我們先說模型歸一化(Normalization)。

因?yàn)槟繕?biāo)檢測任務(wù)的輸入數(shù)據(jù)通常分辨率比較高,導(dǎo)致批次大小不能設(shè)置得太大,所以,批歸一化(Batch Normalization,BN)不太適合從零開始訓(xùn)練目標(biāo)檢測模型。

于是,何愷明等人從最近的研究中找了兩種可行的方法:群組歸一化(Group Normalization,GN)和同步批歸一化(Synchronized Batch Normalization,SyncBN)。

GN是吳育昕和何愷明合作提出的,發(fā)表在ECCV 2018上,還獲得了較佳論文榮譽(yù)提名。這種歸一化方法把通道分成組,然后計(jì)算每一組之內(nèi)的均值和方差。它的計(jì)算獨(dú)立于批次維度,準(zhǔn)確率也不受批次大小影響。

SyncBN則來自曠視的MegDet,和香港中文大學(xué)Shu Liu等人的CVPR 2018論文Path Aggregation Network for Instance Segmentation。這是一種跨GPU計(jì)算批次統(tǒng)計(jì)數(shù)據(jù)來實(shí)現(xiàn)BN的方法,在使用多個(gè)GPU時(shí)增大了有效批次大小。

歸一化方法選定了,還要注意收斂問題,簡單說是要多訓(xùn)練幾個(gè)周期。

道理很簡單:你總不能指望一個(gè)模型從隨機(jī)初始化狀態(tài)開始訓(xùn)練,還收斂得跟預(yù)訓(xùn)練模型一樣快吧。

所以,要有耐心,多訓(xùn)練一會(huì)兒。

上圖就是這兩種方法的對比。假設(shè)微調(diào)的模型已經(jīng)預(yù)訓(xùn)練了100個(gè)周期,那么,從零開始訓(xùn)練的模型要迭代的周期數(shù)是微調(diào)模型的3倍,見到的像素?cái)?shù)量才能差不多,實(shí)例級、圖片級的樣本數(shù)量依然差距很大。

也就是說,要想從隨機(jī)初始化狀態(tài)開始訓(xùn)練,要有大量樣本。

到底要不要用ImageNet預(yù)訓(xùn)練?

這篇論文還貼心地放出了從實(shí)驗(yàn)中總結(jié)的幾條結(jié)論:

不改變架構(gòu),針對特定任務(wù)從零開始訓(xùn)練是可行的。

從零開始訓(xùn)練需要更多迭代周期,才能充分收斂。

在很多情況下,甚至包括只用10000張COCO圖片,從零開始訓(xùn)練的效果不遜于用ImageNet預(yù)訓(xùn)練模型微調(diào)。

用ImageNet預(yù)訓(xùn)練能加速在目標(biāo)任務(wù)上的收斂。

ImageNet預(yù)訓(xùn)練未必能減輕過擬合,除非數(shù)據(jù)量極小。

如果目標(biāo)任務(wù)對定位比識(shí)別更敏感,ImageNet預(yù)訓(xùn)練的作用較小。

所以,關(guān)于ImageNet預(yù)訓(xùn)練的幾個(gè)關(guān)鍵問題也就有了答案:

它是必需的嗎?并不是,只要目標(biāo)數(shù)據(jù)集和計(jì)算力足夠,直接訓(xùn)練就行。這也說明,要提升模型在目標(biāo)任務(wù)上的表現(xiàn),收集目標(biāo)數(shù)據(jù)和標(biāo)注更有用,不要增加預(yù)訓(xùn)練數(shù)據(jù)了。

它有幫助嗎?當(dāng)然有,它能在目標(biāo)任務(wù)上數(shù)據(jù)不足的時(shí)候帶來大幅提升,還能規(guī)避一些目標(biāo)數(shù)據(jù)的優(yōu)化問題,還縮短了研究周期。

我們還需要大數(shù)據(jù)嗎?需要,但一般性大規(guī)模分類級的預(yù)訓(xùn)練數(shù)據(jù)集就不用了,在目標(biāo)領(lǐng)域收集數(shù)據(jù)更有效。

我們還要追求通用表示嗎?依然需要,這還是個(gè)值得贊賞的目標(biāo)。

想更深入地理解這個(gè)問題,請讀論文:

論文:

Rethinking ImageNet Pre-training

Kaiming He,Ross Girshick,PiotrDollár

https://arxiv.org/abs/1811.08883

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請聯(lián)系小編及時(shí)處理,謝謝!

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/4841.html

摘要:何愷明和兩位大神最近提出非局部操作為解決視頻處理中時(shí)空域的長距離依賴打開了新的方向。何愷明等人提出新的非局部通用網(wǎng)絡(luò)結(jié)構(gòu),超越。殘差連接是何愷明在他的年較佳論文中提出的。 Facebook何愷明和RGB兩位大神最近提出非局部操作non-local operations為解決視頻處理中時(shí)空域的長距離依賴打開了新的方向。文章采用圖像去噪中常用的非局部平均的思想處理局部特征與全圖特征點(diǎn)的關(guān)系。這種...

摘要:大神何愷明受到了質(zhì)疑。今天,上一位用戶對何愷明的提出質(zhì)疑,他認(rèn)為何愷明年的原始?xì)埐罹W(wǎng)絡(luò)的結(jié)果沒有被復(fù)現(xiàn),甚至何愷明本人也沒有。我認(rèn)為,的可復(fù)現(xiàn)性經(jīng)受住了時(shí)間的考驗(yàn)。 大神何愷明受到了質(zhì)疑。今天,Reddit 上一位用戶對何愷明的ResNet提出質(zhì)疑,他認(rèn)為:何愷明 2015 年的原始?xì)埐罹W(wǎng)絡(luò)的結(jié)果沒有被復(fù)現(xiàn),甚至何愷明本人也沒有。網(wǎng)友稱,他沒有發(fā)現(xiàn)任何一篇論文復(fù)現(xiàn)了原始 ResNet 網(wǎng)絡(luò)的...

摘要:從標(biāo)題上可以看出,這是一篇在實(shí)例分割問題中研究擴(kuò)展分割物體類別數(shù)量的論文。試驗(yàn)結(jié)果表明,這個(gè)擴(kuò)展可以改進(jìn)基準(zhǔn)和權(quán)重傳遞方法。 今年10月,何愷明的論文Mask R-CNN摘下ICCV 2017的較佳論文獎(jiǎng)(Best Paper Award),如今,何愷明團(tuán)隊(duì)在Mask R-CNN的基礎(chǔ)上更近一步,推出了(以下稱Mask^X R-CNN)。這篇論文的第一作者是伯克利大學(xué)的在讀博士生胡戎航(清華...

摘要:但是其仍然存在一些問題,而新提出的解決了式歸一化對依賴的影響。上面三節(jié)分別介紹了的問題,以及的工作方式,本節(jié)將介紹的原因。作者基于此,提出了組歸一化的方式,且效果表明,顯著優(yōu)于等。 前言Face book AI research(FAIR)吳育昕-何愷明聯(lián)合推出重磅新作Group Normalization(GN),提出使用Group Normalization 替代深度學(xué)習(xí)里程碑式的工作B...

摘要:現(xiàn)在,官方版開源代碼終于來了。同時(shí)發(fā)布的,是這項(xiàng)研究背后的一個(gè)基礎(chǔ)平臺(tái)。是的物體檢測平臺(tái),今天宣布開源,它基于,用寫成,這次開放的代碼中就包含了的實(shí)現(xiàn)。說,將平臺(tái)開源出來,是想要加速世界各地實(shí)驗(yàn)室的研究,推動(dòng)物體檢測的進(jìn)展。 等代碼吧。從Mask R-CNN論文亮相至今的10個(gè)月里,關(guān)于它的討論幾乎都會(huì)以這句話收尾。現(xiàn)在,官方版開源代碼終于來了。同時(shí)發(fā)布的,是這項(xiàng)研究背后的一個(gè)基礎(chǔ)平臺(tái):De...

閱讀 1057·2021-11-18 10:02

閱讀 1314·2021-09-23 11:22

閱讀 2617·2021-08-21 14:08

閱讀 1643·2019-08-30 15:55

閱讀 1728·2019-08-30 13:45

閱讀 3169·2019-08-29 16:52

閱讀 3099·2019-08-29 12:18

閱讀 1643·2019-08-26 13:36