資訊專欄INFORMATION COLUMN

摘要:較大池化一個卷積神經網絡的典型架構卷積神經網絡的典型架構我們已經討論過卷積層用表示和池化層用表示只是一個被應用的非線性特征,類似于神經網絡。

這是作者在 Medium 上介紹神經網絡系列文章中的一篇,他在這里詳細介紹了卷積神經網絡。卷積神經網絡在圖像識別、視頻識別、推薦系統以及自然語言處理中都有很廣的應用。如果想瀏覽該系列文章,可點擊閱讀原文查看原文網址。

跟神經網絡一樣,卷積神經網絡由神經元構成,這些神經元帶有可學習的權重和偏差(bias)。每個神經元接收若干輸入,并對輸入進行加權求和,然后通過一個激活功能將它們傳遞出去,再用一個輸出作為反應。整個神經網絡有一個損失函數,我們為神經網絡開發的所有貼士和技巧,仍然適用于卷積神經網絡。

那么,卷積神經網絡是怎么不同于神經網絡的呢?

卷積神經網絡運行過量

這是什么意思?

1.一個 RGB 圖像的例子(稱它為『輸入圖像』)

在神經網絡中,輸入是一個向量,但是在卷積神經網絡中,輸入是一個多通道圖像(這個例子中的圖像有 3 個通道)。

卷積

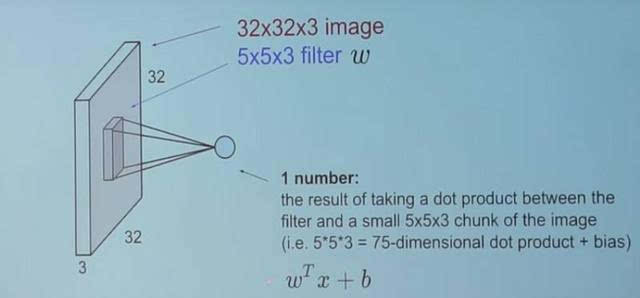

2.用濾波器來卷積圖像

我們用了一個 5×3×5 的濾波器在整個圖像上滑動,在滑動過程中,采集在濾波器與輸入圖像的塊之間的點積。

3.看上去就是這樣子

對于采集到的每個點積來說,其結果都是一個標量。

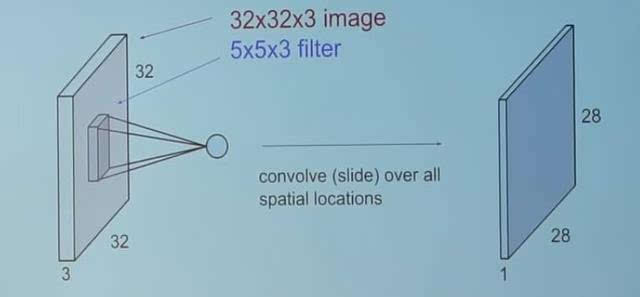

所以當我們用這個濾波器卷積一個完整的圖像時會發生什么呢?

4.就是這個!

你可以自己想想這個『 28 』是怎么來的。(提示:有 28×28 個獨特的位置,在這些位置上,濾波器可以被放在這個圖像上)

現在,回到卷積神經網絡

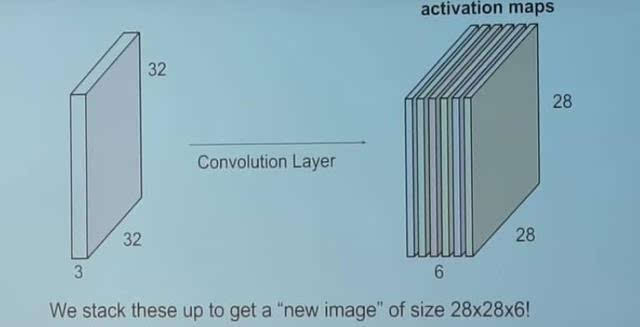

這個卷積層是卷積神經網絡的主構建塊。

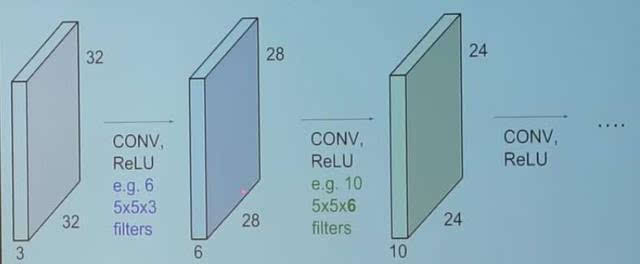

5.卷積層

卷積層包括一組獨立的濾波器(該例子中有 6 個)。每個濾波器都獨立地與圖像卷積,我們以 6 個形狀為 28×1×28 的特征圖結束。

假設我們有一個序列卷積層。那么會發生什么呢?

6.序列卷基層

所有這些濾波器都被隨機初始化,并成為我們的參數,隨后將被這個網絡學習。

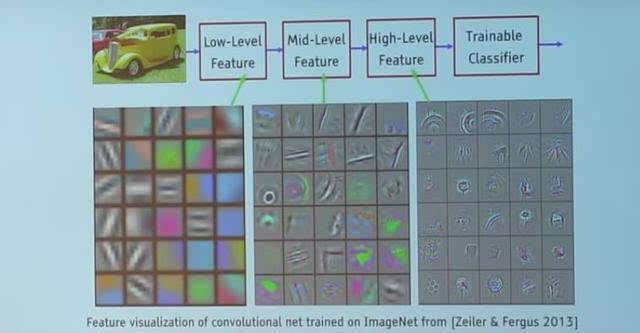

下面是一個訓練過的網絡的例子:

7.一個訓練過的網絡中的濾波器

看下最表層的濾波器(這些都是我們的5×3×5 的濾波器。)通過反向傳播,他們將自己調整為彩色片和邊緣的斑點。在我們深入到其他卷積層時,這些濾波器在做之前的卷積層的輸入的點積。所以,它們正在采集這些較小的彩色片或邊緣,并通過這些小的彩色片和邊緣做出較大的彩色片。

看看圖 4 ,并將這個 28×1×28 的網格想象成 28×28 個神經元。對于一個特定的特征圖來說(在卷積帶有一個濾波器的圖像上接受的輸出被稱為一個特征圖),每個神經元只連接這個輸入圖像的一小塊,而且所有的神經元都具有相同的連接權重。因此,再次回到卷積神經網絡和神經網絡之間的差異。

卷積神經網絡的一對概念:參數共享和局部連通性

參數共享,通過一張特定的特征圖中所有神經元來共享權重。

局部連通性的概念是每個神經只連接一個輸入圖像的子集(不像神經網絡中的所有神經元都完全連接在一起)。

這幫助減少了整個系統中的參數數量,讓計算變得更有效。

為了簡單一些,這里不討論零填充(zero padding)的概念。有興趣的可以自己去閱讀相關資料。

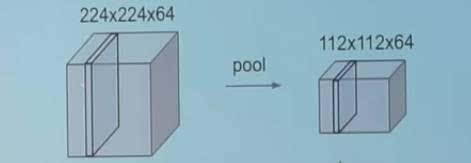

池化層

一個池化層是卷積神經網絡的另一個構建塊

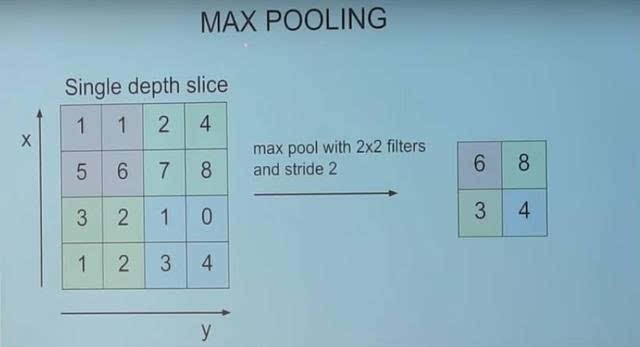

池化

它的功能是通過逐步減小表征的空間尺寸來減小參數量和網絡中的計算。池化層在每一個特征圖上獨立操作。

較大池化

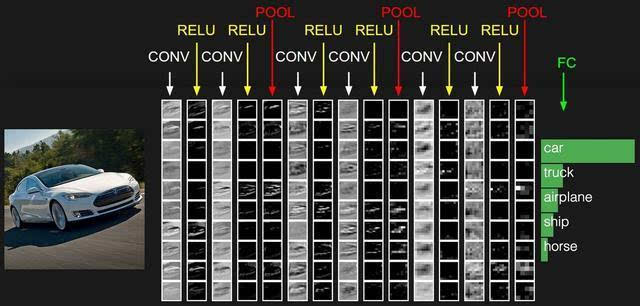

一個卷積神經網絡的典型架構

卷積神經網絡的典型架構

我們已經討論過卷積層(用 CONY 表示)和池化層(用 POOL 表示)

RELU 只是一個被應用的非線性特征,類似于神經網絡。

這個 FC 與神經元層完全相連在卷積神經網絡的末端。完全連接層中的神經元連接著之前層中的所有激活,這在常規的神經網絡中能看到,并以相似的方式運行。

希望你現在能理解一個卷積神經網絡的這種架構了。這種架構還要很多變體,但是之前提到過,基本的概念都是相同。

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/4366.html

摘要:這一切始于年的一篇論文,其使用了稱為的算法用來提取感興趣候選區域,并用一個標準的卷積神經網絡去分類和調整這些區域。 本文詳細解釋了 Faster R-CNN 的網絡架構和工作流,一步步帶領讀者理解目標檢測的工作原理,作者本人也提供了 Luminoth 實現,供大家參考。Luminoth 實現:https://github.com/tryolabs/luminoth/tree/master/l...

摘要:本論文將嘗試概述卷積網絡的架構,并解釋包含激活函數損失函數前向傳播和反向傳播的數學推導。本文試圖只考慮帶有梯度下降優化的典型卷積神經網絡架構的制定。 近日南洋理工大學研究者發布了一篇描述卷積網絡數學原理的論文,該論文從數學的角度闡述整個卷積網絡的運算與傳播過程。該論文對理解卷積網絡的數學本質非常有幫助,有助于讀者「徒手」(不使用卷積API)實現卷積網絡。論文地址:https://arxiv....

摘要:顯示了殘差連接可以加速深層網絡的收斂速度,考察了殘差網絡中激活函數的位置順序,顯示了恒等映射在殘差網絡中的重要性,并且利用新的架構可以訓練極深層的網絡。包含恒等映射的殘差有助于訓練極深層網絡,但同時也是殘差網絡的一個缺點。 WRN Wide Residual NetworksSergey Zagoruyko, Nikos Komodakis Caffe實現:https://github...

摘要:考慮到這一點,我們將這種方法稱為深度學習。這使我們回到原來的問題上我們不是因為深度模型而將其稱為深度學習。這意味著具有個完全連接的層并且只有完全連接的層的神經網絡將不再是深度學習模型,而某些具有少量卷積層的網絡卻可以稱為深度學習。 不管你是業內人士還是業外人士,在人工智能以燎原之勢發展的今天,相信對于AI、機器學習、深度學習這些詞匯,你或多或都有一定的了解,而其中作為人工智能前沿的深度學習,...

閱讀 1221·2021-09-26 09:55

閱讀 3183·2019-08-30 15:55

閱讀 960·2019-08-30 15:53

閱讀 2291·2019-08-30 13:59

閱讀 2377·2019-08-29 13:08

閱讀 1104·2019-08-29 12:19

閱讀 3299·2019-08-26 13:41

閱讀 416·2019-08-26 13:24