資訊專欄INFORMATION COLUMN

摘要:神經(jīng)網(wǎng)絡(luò)在自然語(yǔ)言處理方面,未來(lái)有巨大的應(yīng)用潛力。講座學(xué)者之一與深度學(xué)習(xí)大神蒙特利爾大學(xué)學(xué)者在大會(huì)上發(fā)表了論文,進(jìn)一步展現(xiàn)神經(jīng)機(jī)器翻譯的研究結(jié)果。那些指令的語(yǔ)義就是習(xí)得的進(jìn)入嵌入中,來(lái)較大化翻譯質(zhì)量,或者模型的對(duì)數(shù)似然函數(shù)。

在 8月7日在德國(guó)柏林召開(kāi)的2016 計(jì)算語(yǔ)言學(xué)(ACL)大會(huì)上,學(xué)者Thang Luong、Kyunghyun Cho 和 Christopher D. Manning進(jìn)行了關(guān)于神經(jīng)機(jī)器翻譯(NMT)的講座。神經(jīng)機(jī)器翻譯是一種簡(jiǎn)單的新架構(gòu),可以讓機(jī)器學(xué)會(huì)翻譯。該方法雖然相對(duì)較新,已經(jīng)顯示出了非常好的效果,在各種語(yǔ)言對(duì)上都實(shí)現(xiàn)了最頂尖的表現(xiàn)。神經(jīng)網(wǎng)絡(luò)在自然語(yǔ)言處理方面,未來(lái)有巨大的應(yīng)用潛力。

講座學(xué)者之一 Kyunghyn Cho 與深度學(xué)習(xí)“大神” Yoshua Bengio、蒙特利爾大學(xué)學(xué)者 Junyoung Chung 在 ACL 大會(huì)上發(fā)表了論文,進(jìn)一步展現(xiàn)神經(jīng)機(jī)器翻譯的研究結(jié)果。在此,雷鋒網(wǎng)(搜索“雷鋒網(wǎng)”公眾號(hào)關(guān)注)為大家分享名為《針對(duì)神經(jīng)機(jī)器翻譯,無(wú)需顯性分割的字符等級(jí)解碼器》論文全文。

概況

現(xiàn)有的機(jī)器翻譯系統(tǒng),無(wú)論是基于詞組的還是神經(jīng)的,幾乎全部都依靠使用顯性分割的、詞語(yǔ)等級(jí)的建模。在這篇論文中,我們提出一個(gè)基本問(wèn)題:神經(jīng)機(jī)器翻譯能否在生成字符序列時(shí),不使用任何顯性分割?要回答這一問(wèn)題,我們分析一個(gè)基于注意的編碼器解碼器,在四個(gè)語(yǔ)言對(duì)——En-Cs、En-De、En-Ru 和 En-Fi——中,帶有子字等級(jí)的編碼器,以及一個(gè)字符等級(jí)的解碼器,使用 WMT’ 15 的平行語(yǔ)料庫(kù)。我們的實(shí)驗(yàn)證明,帶有字符等級(jí)解碼器的模型在所有四個(gè)語(yǔ)言對(duì)上,表現(xiàn)都優(yōu)于帶有子字等級(jí)解碼器的模型。并且,帶有字符等級(jí)解碼器的神經(jīng)模型組合在 En-Cs、En-De 和 En-Fi 上優(yōu)于較先進(jìn)的非神經(jīng)機(jī)器翻譯系統(tǒng),在 En-Ru 上表現(xiàn)相當(dāng)。

1、簡(jiǎn)介

現(xiàn)有的機(jī)器翻譯系統(tǒng)幾乎全部都依靠使用顯性分割的、詞語(yǔ)等級(jí)的建模。這主要是因?yàn)閿?shù)據(jù)稀疏性的問(wèn)題,這當(dāng)句子表征為一系列字符而非詞語(yǔ)時(shí)這個(gè)問(wèn)題更為嚴(yán)重,尤其是針對(duì) n-gram,由于序列的長(zhǎng)度大大增加了。除了數(shù)據(jù)稀疏性之外,我們經(jīng)常先入為主地相信詞語(yǔ)——或其分割出的詞位——是語(yǔ)義最基本的單位,使我們很自然地認(rèn)為翻譯就是將一系列的源語(yǔ)言詞語(yǔ)匹配為一系列的目標(biāo)語(yǔ)言詞語(yǔ)。

在最近提出的神經(jīng)機(jī)器翻譯范示中,這種觀點(diǎn)也延續(xù)了下來(lái),雖然神經(jīng)網(wǎng)絡(luò)不受到字符等級(jí)建模的拖累,但是會(huì)被詞語(yǔ)等級(jí)建模所特有的問(wèn)題影響,例如目標(biāo)語(yǔ)言的詞匯量非常大,會(huì)造成增加的計(jì)算復(fù)雜性。因此,這篇論文中,我們研究神經(jīng)機(jī)器翻譯是否能夠直接在一系列字符上進(jìn)行,無(wú)需顯性的詞語(yǔ)分割。

為了回答這一問(wèn)題,我們專注在將目標(biāo)方表征為一個(gè)字符序列。我們用字符等級(jí)的解碼器在 WMT’ 15 的四個(gè)語(yǔ)言對(duì)上評(píng)估神經(jīng)機(jī)器翻譯模型,讓我們的評(píng)估具有很強(qiáng)的說(shuō)服力。我們將源語(yǔ)言一方表征為一個(gè)子字序列,使用從 Sennrich 等人(2015) 中編碼的字節(jié)對(duì)將其抽取而出,并將目標(biāo)方改變?yōu)橐粋€(gè)子字或者字符序列。在目標(biāo)方,我們進(jìn)一步設(shè)計(jì)了一個(gè)新的循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN),稱為雙度量循環(huán)神經(jīng)網(wǎng)絡(luò),能更好地處理序列中的多個(gè)時(shí)標(biāo),并額外在一個(gè)新的、堆積的循環(huán)神經(jīng)網(wǎng)絡(luò)中測(cè)試。

在所有四個(gè)語(yǔ)言對(duì)中——En-Cs、En-De、En- Ru 和 En-Fi——帶有字符等級(jí)解碼器的模型比帶有子字等級(jí)解碼器的模型更好。我們?cè)诿恳粋€(gè)這些配置的組合中都觀察到了類似的趨勢(shì),在 En-Cs、En-De 和 En-Fi 中超過(guò)了之前較好的神經(jīng)和非神經(jīng)翻譯系統(tǒng),而在 En-Ru 上實(shí)現(xiàn)了相同的結(jié)果。我們發(fā)現(xiàn)這些結(jié)果強(qiáng)有力地證明了,神經(jīng)機(jī)器翻譯真的可以學(xué)會(huì)在字符等級(jí)翻譯,并且其實(shí)可以從中獲益。

2、神經(jīng)機(jī)器翻譯

神經(jīng)機(jī)器翻譯指的是一個(gè)最近提出的機(jī)器翻譯方法(Forcada 和 Neco, 1997;Kalchbrenner 和 Blunsom, 2013;Cho 等人, 2014;Sutskever 等人, 2014)。這種方法的目標(biāo)是打造一個(gè)端到端的神經(jīng)網(wǎng)絡(luò),將輸入作為源句子 X = (x1, … , xTx),并輸出其翻譯 Y = (y1, … , yTy),其中 xt 和 yt’ 分別是源標(biāo)志和目標(biāo)標(biāo)志。這個(gè)神經(jīng)網(wǎng)絡(luò)的打造方式是作為一個(gè)編碼網(wǎng)絡(luò)和解碼網(wǎng)絡(luò)。

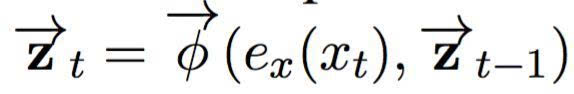

編碼網(wǎng)絡(luò)將輸入句子 X 編碼為其連續(xù)的表征。在這篇論文中,我們緊密遵循 Bahdanau 等人(2015) 提出的神經(jīng)翻譯模型,使用一個(gè)雙向循環(huán)神經(jīng)網(wǎng)絡(luò),其中包含兩個(gè)循環(huán)神經(jīng)網(wǎng)絡(luò)。前饋網(wǎng)絡(luò)將輸入句子在前饋方向讀作:

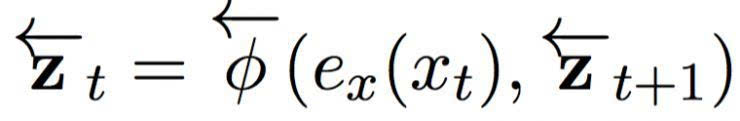

其中 ex (xt) 是對(duì)第 t 個(gè)輸入象征的連續(xù)嵌入,是一個(gè)循環(huán)激活函數(shù)。相同地,反向網(wǎng)絡(luò)將句子以反方向(從右到左)讀入:

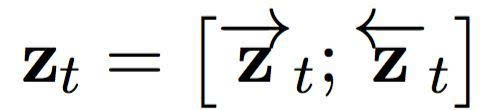

在輸入句子的每一個(gè)位置,我們將前饋和反向 RNN 中的隱藏狀態(tài)連接起來(lái),形成一個(gè)情景組 C = { z1, …, zTx},其中

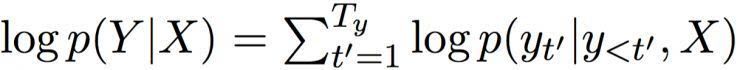

然后,解碼器基于這個(gè)情景組,計(jì)算出所有可能翻譯的條件分布。首先,重寫(xiě)一個(gè)翻譯的條件分布:

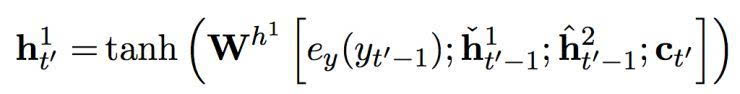

在總和的每一個(gè)條件中,解碼器 RNN 通過(guò)以下方程(1)更新其隱藏狀態(tài):

h’t = φ (ey (yt’ - 1), ht’-1, ct’), (1)

其中 ey 是一個(gè)目標(biāo)象征的連續(xù)嵌入。ct’ 是一個(gè)情景矢量,由以下的軟堆砌機(jī)制計(jì)算而出:

ct’ = falign ( ey (yt’-1), ht’-1, C) )。 (2)

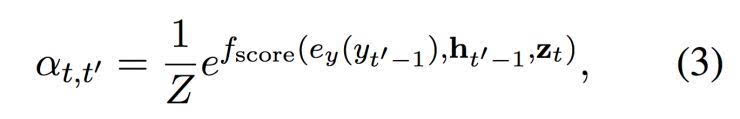

這個(gè)軟對(duì)齊機(jī)制 falign 在情景 C 中基于已經(jīng)翻譯的內(nèi)容,根據(jù)相關(guān)性權(quán)衡每一個(gè)矢量。每一個(gè)矢量 zt 的權(quán)重是由以下的方程(3)計(jì)算而出:

其中 fscore 是一個(gè)參數(shù)函數(shù),對(duì)于 ht’-1 和 yt’-1 返回一個(gè)非標(biāo)準(zhǔn)化的得分。

這篇論文中,我們使用一個(gè)帶有單一隱藏層的前饋網(wǎng)絡(luò)。 Z 是一個(gè)標(biāo)準(zhǔn)化的常數(shù):

這個(gè)過(guò)程可以被理解為是在第 t’ 個(gè)目標(biāo)符號(hào)和第 t 個(gè)源符號(hào)之間計(jì)算對(duì)齊概率。

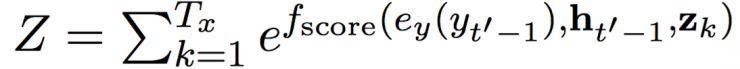

在隱藏狀態(tài) ht’ 與之前的目標(biāo)符號(hào) yt’-1 和情景矢量 ct’ 一起,輸入一個(gè)前饋神經(jīng)網(wǎng)絡(luò),帶來(lái)以下的條件分布:

整個(gè)模型,由編碼器、加碼起和軟對(duì)齊機(jī)制構(gòu)成,然后經(jīng)過(guò)端到端的調(diào)試,使用隨機(jī)梯度下降將負(fù)面對(duì)數(shù)似然函數(shù)最小化。

3、向著字符等級(jí)翻譯

3.1 動(dòng)機(jī)

讓我們回顧源句子和目標(biāo)句子( X 和 Y ) 在神經(jīng)機(jī)器翻譯中是如何表征的。對(duì)于任何訓(xùn)練體中的源一方,我們可以掃描整體,來(lái)打造一個(gè)詞匯 Vx , 包含分配了整數(shù)標(biāo)記的令牌。然后,源句子 X 作為一系列屬于該句子的類似令牌的標(biāo)記,即 X = (x1, …, xTx) ,其中 xt ∈ { 1, 2, …, | Vx |}。與此類似地,目標(biāo)句子轉(zhuǎn)化為一個(gè)整數(shù)標(biāo)記的目標(biāo)序列。

然后,每一個(gè)令牌或其指數(shù)轉(zhuǎn)化為 |Vx|所謂的 one-hot 矢量。除了一個(gè)以外,矢量中所有的元素都設(shè)置為 0。一個(gè)指數(shù)對(duì)應(yīng)令牌指數(shù)的元素設(shè)置為 1。這個(gè) one-hot 矢量就是任何神經(jīng)機(jī)器翻譯模型所看見(jiàn)的。嵌入函數(shù) ex 或 ey,就是在這個(gè) one-hot 矢量上應(yīng)用一個(gè)線性轉(zhuǎn)化(嵌入矩陣)的結(jié)果。

這種基于 one-hot 矢量的方法的重要特點(diǎn)是,神經(jīng)網(wǎng)絡(luò)忽視指令的底層語(yǔ)義。對(duì)于神經(jīng)網(wǎng)絡(luò)來(lái)說(shuō),詞匯中的每一個(gè)指令,等同于與其他每個(gè)指令間的距離。那些指令的語(yǔ)義就是習(xí)得的(進(jìn)入嵌入中),來(lái)較大化翻譯質(zhì)量,或者模型的對(duì)數(shù)似然函數(shù)。

這項(xiàng)特性讓我們?cè)谶x擇指令的單位時(shí)獲得了很大的自由度。神經(jīng)網(wǎng)絡(luò)已經(jīng)被證實(shí)與詞語(yǔ)指令配合良好 (Bengio 等人, 2001; Schwenk, 2007; Mikolov 等人, 2010),還與更細(xì)微的單元也配合良好,例如子字(Sennrich 等人, 2015; Botha 和 Blunson, 2014; Luong 等人, 2013) 和壓縮或編碼造成的符號(hào)(Chitnis 和 DeNero, 2015)。雖然已經(jīng)有一系列先前的研究報(bào)告稱使用了帶有字符的神經(jīng)網(wǎng)絡(luò)(例如 Mikolov 等人 (2012) 和 Santos 和 Zadrozny (2014)的研究),主流的方法一直是將文字預(yù)先處理為一系列符號(hào),每個(gè)與一個(gè)字符系列相關(guān)聯(lián),之后神經(jīng)網(wǎng)絡(luò)就用那些符號(hào)、而非字符來(lái)表征。

最近在神經(jīng)機(jī)器翻譯中,兩組研究團(tuán)隊(duì)已經(jīng)提出過(guò)直接使用字符。Kim 等人(2015)提出不像以前一樣以單一整數(shù)指令來(lái)代表每一個(gè)詞,而是作為一個(gè)字符序列,并使用一個(gè)卷積網(wǎng)絡(luò),隨后用一個(gè)高速神經(jīng)網(wǎng)絡(luò)(Srivastava 等人, 2015)來(lái)抽取詞語(yǔ)的連續(xù)表征。這種方法有效替換了嵌入函數(shù) ex,被 Costa-Jussa 和 Fonollosa(2016)在神經(jīng)機(jī)器翻譯中采用。類似地,Ling 等人 (2015b) 使用了一個(gè)雙向循環(huán)神經(jīng)網(wǎng)絡(luò)來(lái)代替嵌入函數(shù) ex 和 ey,來(lái)分別從相應(yīng)的連續(xù)詞語(yǔ)表征中編碼一個(gè)字符序列,并且編碼進(jìn)這個(gè)連續(xù)表征中去。Lee 等人(2015) 提出了一個(gè)類似、但是略有不同的方法,他們用字符在詞語(yǔ)中的相對(duì)位置來(lái)顯性地標(biāo)記每一個(gè)字符,例如,英文單詞中的 “B”eginning 和 “I”ntermediate。

雖然這些最近的方法是研究字符層面,但還是不如人意,因?yàn)樗鼈兌家蕾囉诹私馊绾螌⒆址指顬樵~語(yǔ)。雖然總體上這在英語(yǔ)等語(yǔ)言中還是相對(duì)簡(jiǎn)單的,這并不總是可行的。這種詞語(yǔ)分割過(guò)程可以非常簡(jiǎn)單,就像帶有標(biāo)點(diǎn)符號(hào)常規(guī)化的指令化,不過(guò),也可能非常復(fù)雜,就像詞素分割,需要預(yù)先訓(xùn)練一個(gè)多帶帶的模型(Creutz 和 Lagus, 2005; Huang 和 Zhao,2007;)。而且,這些分割步驟經(jīng)常是經(jīng)過(guò)微調(diào)的,或者與最終的翻譯質(zhì)量目標(biāo)分開(kāi)設(shè)計(jì),潛在來(lái)說(shuō)可能造成非最優(yōu)的質(zhì)量。

基于這項(xiàng)觀察和分析,這篇論文中,我們向自己和讀者提出一個(gè)早該提出的問(wèn)題:有沒(méi)有可能,不使用任何顯性的分割,就進(jìn)行字符等級(jí)的翻譯?

3.2 為什么要使用詞語(yǔ)等級(jí)的翻譯?

(1)詞語(yǔ)作為語(yǔ)義的基本單位

詞語(yǔ)可以被理解為兩種意思。抽象意義來(lái)說(shuō),一個(gè)詞語(yǔ)是語(yǔ)義(詞素)的基本單位,在另一種意義來(lái)說(shuō),可以理解為“在句子中使用的具體詞語(yǔ)” (Booij,2012)。在第一種意義中,一個(gè)詞語(yǔ)通過(guò)詞語(yǔ)形態(tài)學(xué)的過(guò)程——包括變音、組合和衍生——轉(zhuǎn)化進(jìn)入第二種意義。這三種過(guò)程的確改變?cè)~素的含義,但是經(jīng)常與原意保持相近。因?yàn)檫@種語(yǔ)言學(xué)中的觀點(diǎn)認(rèn)為詞語(yǔ)是語(yǔ)義的基本單位(作為詞素或者衍生形式),自然語(yǔ)言處理中的很多先前研究都將詞語(yǔ)作為基本單位,將句子編碼為詞語(yǔ)的序列。另外,匹配詞語(yǔ)的字符序列和語(yǔ)義的潛在困難,也可能推動(dòng)了這種詞語(yǔ)等級(jí)建模的潮流。

(2)數(shù)據(jù)稀疏性

還有另一個(gè)技術(shù)原因,使得很多之前對(duì)于翻譯匹配的研究都將詞語(yǔ)作為基本單位。這主要是因?yàn)楝F(xiàn)有翻譯系統(tǒng)中的主要組成部分——例如語(yǔ)言模型和詞組表——都是基于字?jǐn)?shù)的概率模擬。換句話說(shuō),標(biāo)志子序列的概率(或者)一對(duì)標(biāo)志,估計(jì)的方法是數(shù)出它在訓(xùn)練體出現(xiàn)了幾次。這種方法嚴(yán)重地受到數(shù)據(jù)稀疏性問(wèn)題的影響,這是因?yàn)橐粋€(gè)很大的狀態(tài)空間,子序列會(huì)出現(xiàn)指數(shù)級(jí)別的增長(zhǎng),而在訓(xùn)練體的體積方面只會(huì)線性增長(zhǎng)。這對(duì)字符等級(jí)的建模帶來(lái)了很大挑戰(zhàn),由于當(dāng)使用字符(而非詞語(yǔ))時(shí),任何子序列都會(huì)變長(zhǎng)平均 4-5 倍。的確,Vilar 等人(2007)的報(bào)告提出,當(dāng)基于詞組的機(jī)器翻譯系統(tǒng)直接使用字符序列時(shí),表現(xiàn)變得更差。更加近期的,Neubig 等人(2013) 提出了一種方法,用基于詞組的翻譯系統(tǒng)來(lái)提升字符等級(jí)的翻譯,不過(guò)成效有限。

(3)消失的梯度

具體到神經(jīng)機(jī)器翻譯,之所以詞語(yǔ)等級(jí)的建模得到廣泛采用,有一個(gè)主要原因是對(duì)循環(huán)神經(jīng)網(wǎng)絡(luò)的長(zhǎng)期依存性的建模難度(Bengio 等人, 1994; Hochreiter, 1998)。當(dāng)句子作為字符表征時(shí),由于雙方句子長(zhǎng)度增長(zhǎng),我們很容易相信未來(lái)會(huì)有更多的長(zhǎng)期依存性,循環(huán)神經(jīng)網(wǎng)絡(luò)一定會(huì)在成功翻譯中使用。

3.3 為什么要使用字符等級(jí)的翻譯?

為什么不使用詞語(yǔ)等級(jí)的翻譯?

詞語(yǔ)等級(jí)的處理中最緊迫的問(wèn)題是,我們沒(méi)有一個(gè)針對(duì)任何語(yǔ)言的、完美的詞語(yǔ)分割算法。一個(gè)完美的詞語(yǔ)分割算法需要能將任何已知的句子分割為一系列的詞素和詞位。然而,這個(gè)問(wèn)題本身是一個(gè)嚴(yán)重的問(wèn)題,經(jīng)常需要幾十年的研究(關(guān)于芬蘭語(yǔ)和其他詞素豐富的語(yǔ)言,參見(jiàn)例如 Creutz 和 Lagus (2005)的研究,關(guān)于中文,參見(jiàn) Huang 和 Zhao (2007)的研究)。因此,許多人選擇使用基于規(guī)則的指令化方法,或者非最優(yōu)的、不過(guò)仍可行的、基于學(xué)習(xí)的分割算法。

這種非最優(yōu)分割的結(jié)果是,詞匯中經(jīng)常充滿許多詞義相近的詞語(yǔ),分享同一個(gè)詞位但是形態(tài)不同。例如,如果我們將一個(gè)簡(jiǎn)單的指令話腳本應(yīng)用于英文,“run”、“runs”、 “ran” 和 “running”(英文“跑步”的一般式、第三人稱單數(shù)形式、過(guò)去式和現(xiàn)在進(jìn)行式)都是詞匯中多帶帶的條目,盡管它們顯然是共享一個(gè)相同的詞位 “run”。這使得任何機(jī)器翻譯——尤其是神經(jīng)機(jī)器翻譯——都沒(méi)法正確高效地為這些詞形變化的詞語(yǔ)建模。

具體到神經(jīng)機(jī)器翻譯的情況下來(lái)說(shuō),每一個(gè)詞形變體——“run”、“runs”、“ran” 和 “running”——將會(huì)分配一個(gè) d 維詞語(yǔ)矢量,產(chǎn)生四個(gè)獨(dú)立矢量,雖然如果我們能將那些變體分割為一個(gè)詞位和其他詞素,顯然我們就能更加高效地將其建模。舉個(gè)例子,針對(duì)詞位 “run” 我們可以有一個(gè) d 維矢量,針對(duì) “s” 和 “ing” 可以有一些更小的矢量。這些變體的每一個(gè)之后都會(huì)變成詞位矢量(由這些變體共享)和語(yǔ)素矢量(由帶有相同后綴或其它結(jié)構(gòu)的詞語(yǔ)共享)(Botha 和 Blunsom,2014)。這利用了分布表征,在總體上帶來(lái)更好的抽象化,但好像需要一種最優(yōu)分割,可惜這總是無(wú)法獲得。

除了建模中的低效,使用(未分割的)詞語(yǔ)還有兩個(gè)額外的負(fù)面結(jié)果。首先,翻譯系統(tǒng)不能很好地在新詞上進(jìn)行抽象化,經(jīng)常匹配到一個(gè)預(yù)留給未知詞語(yǔ)的指令上。這實(shí)際在翻譯中忽略了任何詞語(yǔ)的需要融合進(jìn)來(lái)的語(yǔ)義或者結(jié)構(gòu)。第二,即便是一個(gè)詞位很普遍,經(jīng)常在訓(xùn)練體里觀察到,其詞形變體可能不一定。這意味著模型更少地見(jiàn)到這種特定的、罕見(jiàn)的詞形變體,而且將不能好好翻譯。然而,如果這種罕見(jiàn)的變體與其它更常見(jiàn)的詞語(yǔ)共享很大的一部分拼寫(xiě),我們就希望機(jī)器翻譯系統(tǒng)在翻譯罕見(jiàn)變體時(shí)能利用那些常見(jiàn)詞語(yǔ)。

為什么使用字符等級(jí)的翻譯

從某種程度上,所有這些問(wèn)題都可以通過(guò)直接建模字符來(lái)解決。雖然數(shù)據(jù)稀疏性的問(wèn)題在字符等級(jí)的翻譯中出現(xiàn),通過(guò)使用一個(gè)基于循環(huán)神經(jīng)網(wǎng)絡(luò)的參數(shù)方法(而非一個(gè)基于字?jǐn)?shù)的非參數(shù)方法)就可以優(yōu)雅地解決。而且,最近幾年,我們已經(jīng)了解如何打造和訓(xùn)練循環(huán)神經(jīng)網(wǎng)絡(luò),來(lái)通過(guò)使用更復(fù)雜的激活函數(shù),例如長(zhǎng)短期記憶(LSTM)單元(Hochreiter 和 Schmidhuber,1997)和門(mén)限循環(huán)單元(Cho 等人, 2014),來(lái)良好抓取長(zhǎng)期依存性。

Kim 等人(2015)和 Ling 等人(2015a)最近證明了,通過(guò)一個(gè)神經(jīng)網(wǎng)絡(luò)來(lái)將字符序列轉(zhuǎn)化為詞語(yǔ)矢量,我們可以避免很多詞形變量作為詞匯中的多帶帶實(shí)體出現(xiàn)。這之所以成為可能,是通過(guò)在所有獨(dú)特指令之間分享“字符到詞語(yǔ)”神經(jīng)網(wǎng)絡(luò)。一個(gè)類似的方法由 Ling 等人(2015b)應(yīng)用在機(jī)器翻譯中。

然而,這些最近的方法仍依賴獲得一個(gè)好的(如果不是最優(yōu)的)分割算法。Ling 等人(2015b) 的確說(shuō):“很多關(guān)于詞形學(xué)、同源詞和罕見(jiàn)詞翻譯等等等先前信息應(yīng)該被融合進(jìn)來(lái)。”

然而,如果我們直接在未分割的字符序列上使用一個(gè)神經(jīng)網(wǎng)絡(luò)——無(wú)論是循環(huán)的、卷積的或者它們的組合——就沒(méi)有必要考慮這些先前信息了。使用未分割字符序列的可能性已經(jīng)在深度學(xué)習(xí)領(lǐng)域中研究了很多年。例如,Mikolov 等人(2012)和 Sutskever 等人2011)在字符序列上訓(xùn)練了一個(gè)循環(huán)神經(jīng)網(wǎng)絡(luò)語(yǔ)言模型(RNN-LM)。后者證明了,只通過(guò)從這個(gè)模型中一次取樣一個(gè)字符就可以生成合理的文本序列。最近,Zhang 等人(2015) 及 Xiao 和 Cho (2016)成功地對(duì)字符等級(jí)文檔分別應(yīng)用了一個(gè)卷積網(wǎng)絡(luò)和一個(gè)卷積-循環(huán)網(wǎng)絡(luò),并且未使用任何顯性分割。Gillick 等人 (2015) 進(jìn)一步證明了可以在 unicode 字節(jié)(而非在字符或詞語(yǔ)上)訓(xùn)練一個(gè)循環(huán)神經(jīng)網(wǎng)絡(luò),來(lái)進(jìn)行部分語(yǔ)音自動(dòng)標(biāo)注以及命名實(shí)體識(shí)別。

這些早先研究讓我們看到了在機(jī)器翻譯任務(wù)中應(yīng)用神經(jīng)網(wǎng)絡(luò)的可能性,這經(jīng)常被認(rèn)為比文件分類和語(yǔ)言建模更加困難。

3.4 挑戰(zhàn)與問(wèn)題

針對(duì)源語(yǔ)言方和目標(biāo)語(yǔ)言方,有兩組相互重疊的挑戰(zhàn)。在源語(yǔ)言方,我們還未知如何打造一個(gè)神經(jīng)網(wǎng)絡(luò)來(lái)學(xué)習(xí)拼寫(xiě)和句子語(yǔ)義之間的高度非線性匹配。

在目標(biāo)語(yǔ)言方有兩項(xiàng)挑戰(zhàn)。第一項(xiàng)挑戰(zhàn)是和源語(yǔ)言方相同,因?yàn)榻獯a器神經(jīng)網(wǎng)絡(luò)需要總結(jié)翻譯的內(nèi)容。此外,目標(biāo)語(yǔ)言方的字符等級(jí)建模更加具有挑戰(zhàn)性,因?yàn)榻獯a器網(wǎng)絡(luò)必須得能生成長(zhǎng)的、連貫的字符序列。這是一個(gè)大挑戰(zhàn),因?yàn)闋顟B(tài)空間的大小會(huì)由于符號(hào)的數(shù)量而指數(shù)增長(zhǎng),而在字符的情況下,經(jīng)常有300-1000個(gè)符號(hào)那么長(zhǎng)。

所有這些挑戰(zhàn)首先都應(yīng)該描述為問(wèn)題;目前的循環(huán)神經(jīng)網(wǎng)絡(luò)——在神經(jīng)機(jī)器翻譯中已經(jīng)廣泛使用——能否解決這些問(wèn)題。這篇論文中,我們的目標(biāo)是實(shí)證性地回答這些問(wèn)題,并集中考慮目標(biāo)方的挑戰(zhàn)(由于目標(biāo)方兩項(xiàng)挑戰(zhàn)都會(huì)顯示)。

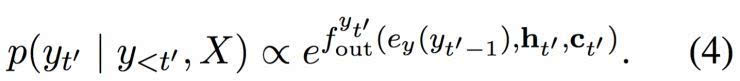

圖1: 雙度量循環(huán)神經(jīng)網(wǎng)絡(luò)。

4、字符等級(jí)翻譯

這篇論文中,我們?cè)噲D通過(guò)在目標(biāo)方(解碼器)測(cè)試兩種不同類型的循環(huán)神經(jīng)網(wǎng)絡(luò),回答早前提出的問(wèn)題。

首先,我們用門(mén)限循環(huán)單元(GRU)測(cè)試一個(gè)現(xiàn)有的循環(huán)神經(jīng)網(wǎng)絡(luò)。我們將這個(gè)解碼器稱為基準(zhǔn)解碼器。

第二步,我們?cè)?Chung 等人(2015)的門(mén)限反饋網(wǎng)絡(luò)的啟發(fā)之下,打造一個(gè)新的雙層循環(huán)神經(jīng)網(wǎng)絡(luò),稱為“雙度量”循環(huán)神經(jīng)網(wǎng)絡(luò)。我們?cè)O(shè)計(jì)這個(gè)網(wǎng)絡(luò)來(lái)輔助抓取兩種時(shí)間量程,初衷是由于字符和詞語(yǔ)可能在兩個(gè)分開(kāi)的時(shí)間量程上運(yùn)行。

我們選擇測(cè)試這兩種選項(xiàng)是為了以下這兩種目的。使用基準(zhǔn)解碼器的實(shí)驗(yàn)會(huì)明確地回答這一問(wèn)題:現(xiàn)有神經(jīng)網(wǎng)絡(luò)是否能夠處理字符等級(jí)的解碼。這一問(wèn)題在機(jī)器翻譯的領(lǐng)域內(nèi)還沒(méi)有良好解答過(guò)。另一個(gè)選項(xiàng)——雙度量解碼器——也經(jīng)過(guò)測(cè)試,為了了解如果第一個(gè)問(wèn)題的答案是肯定的,那么有沒(méi)有可能設(shè)計(jì)一個(gè)更好的解碼器。

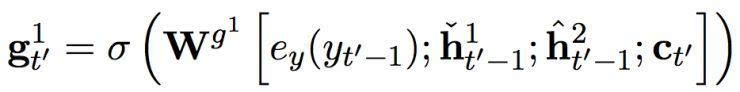

4.1 雙度量循環(huán)神經(jīng)網(wǎng)絡(luò)

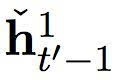

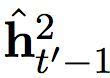

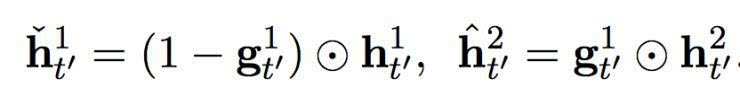

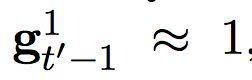

在這個(gè)提出的雙度量循環(huán)神經(jīng)網(wǎng)絡(luò)中有兩組隱藏單元,h1 和 h2。它們包含同樣數(shù)量的單元,即: dim (h1) = dim (h2)。第一組 h1 使用一個(gè)快速變化的時(shí)間度量(因而是一個(gè)更快的層),h2 使用更慢的時(shí)間度量(因而是一個(gè)更慢的層)。針對(duì)每一個(gè)隱藏單元,都有一個(gè)相關(guān)的門(mén)限單元,我們分別稱為 g1 和 g2。接下來(lái)的描述中,我們?yōu)橹暗哪繕?biāo)符號(hào)和情景矢量分別使用 yt’-1 和 ct’ (見(jiàn)方程(2))。

讓我們先從更快的層開(kāi)始。更快的層輸出兩組激活,一個(gè)標(biāo)準(zhǔn)輸出

及其門(mén)限版本

其中

和

分別是快速層和慢速層的門(mén)限激活。這些門(mén)限激活由以下方程計(jì)算而出:

換句話說(shuō),快速層的激活是基于之前時(shí)間步中,快速層和慢速層的適應(yīng)性結(jié)合。當(dāng)快速層任務(wù)需要重啟,即

下一個(gè)激活將更多地由慢速層的激活而決定。

快速層的門(mén)限單元由以下方程計(jì)算而出:

其中 σ 是一個(gè) sigmoid 函數(shù)。

慢速層還輸出兩組激活,一個(gè)常規(guī)輸出

及其門(mén)限版本

這些激活是由以下方程計(jì)算而出:

其中

是一個(gè)候選激活。慢速層的門(mén)限單元是由以下方程計(jì)算而出:

這項(xiàng)適應(yīng)性融合是基于從快速層而來(lái)的門(mén)限單元,其結(jié)果是,慢速層只有當(dāng)快速層重啟時(shí)才更新其激活。這設(shè)置了一種軟限制,通過(guò)防止慢速層在快速層處理一個(gè)當(dāng)前部分時(shí)進(jìn)行更新,使得快速層運(yùn)行速率更快。

然后,候選激活由以下方程計(jì)算而出:

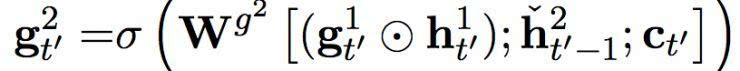

圖2:(左)關(guān)于源句子長(zhǎng)度在 En-Cs 上的 BLEU 分。(右)子字等級(jí)解碼器和字符等級(jí)基準(zhǔn)或雙度量解碼器之間的詞語(yǔ)負(fù)面對(duì)數(shù)概率差異。

意味著之前時(shí)間步的重啟,與在快速層中發(fā)生的相似,

是情景中而來(lái)的輸入。

根據(jù)方程(5)中的

,

,

只有當(dāng)快速層已經(jīng)完成處理目前部分、將要開(kāi)始重啟的時(shí)候,快速層才會(huì)影響到慢速層。換句話說(shuō),慢速層不會(huì)從快速層收到任何輸入,直到快速層已經(jīng)完成處理目前部分,因而比快速層的運(yùn)行速率更慢。

在每一個(gè)時(shí)間步,所提出的雙度量循環(huán)神經(jīng)網(wǎng)絡(luò)的最終輸出,是快速層和慢速層輸出矢量的結(jié)合,即:[h1; h2]。這個(gè)結(jié)合矢量用來(lái)計(jì)算所有符號(hào)在詞匯中的分布概率,正如方程(4)。詳見(jiàn)圖1。

5、實(shí)驗(yàn)設(shè)定

為了評(píng)估,我們將一個(gè)源句子表征為一系列子字符號(hào)序列,用字節(jié)對(duì)編碼(BPE,Sennrich 等(2015))抽取而來(lái),并將目標(biāo)句子編碼為一系列基于 BPE 的符號(hào)序列或者一個(gè)字符序列。

主體和預(yù)處理

我們使用 WMT’ 15 的四個(gè)語(yǔ)言對(duì)——En-Cs、En-De、En-Ru 和 En-Fi——中所有可用的平行主體。它們分別由 12.1 M、4.5 M、2.3 M 和 2 M 句子對(duì)構(gòu)成。我們我們將每一個(gè)主體指令化,使用一個(gè)包含在 Moses 中的指令化腳本。當(dāng)源語(yǔ)言方長(zhǎng)達(dá) 50 個(gè)子字,并且目標(biāo)方長(zhǎng)達(dá) 100 個(gè)子字標(biāo)識(shí)或者 500 個(gè)字符時(shí),我們只使用句子對(duì)。我們不使用任何單一語(yǔ)言主體。

表格1: 單一模型及組合的子字等級(jí)、字符等級(jí)技術(shù)和字符等級(jí)雙量級(jí)解碼器的 BLEU 分。每一個(gè)語(yǔ)言對(duì)的單一模型的較佳分?jǐn)?shù)以黑體標(biāo)記,而組合中的較佳分?jǐn)?shù)以下劃線標(biāo)記。當(dāng)可獲得時(shí),我們返回平均值、較高值和較低值,分別作為下標(biāo)文字和上標(biāo)文字。

針對(duì)除 En-Fi 之外的所有對(duì),我們使用 newstest-2013 作為發(fā)展測(cè)試,并使用 newstests-2014 (Test 1) 和 newstests-2015 (Test 2) 作為測(cè)試組。針對(duì) En-Fi, 我們使用 newsdev-2015 和 newstest-2015 分別作為發(fā)展組和測(cè)試組。

模型和訓(xùn)練

我們測(cè)試三個(gè)模型設(shè)定:(1)BPE → BPE,(2)BPE → Char (基準(zhǔn))和(3)BPE → Char (雙度量)。后兩項(xiàng)的不同點(diǎn)是我們使用的循環(huán)神經(jīng)網(wǎng)絡(luò)類型不同。我們?cè)谒性O(shè)定中都使用了 GRU 作為編碼器。我們?cè)谇皟蓚€(gè)設(shè)定(1)和(2)中使用 GRU 作為解碼器,而在最后一個(gè)設(shè)定(3)中使用了提出的雙度量循環(huán)網(wǎng)絡(luò)。針對(duì)每一個(gè)方向(前饋和反向),編碼器具有 512 個(gè)隱藏單元,解碼器有 1024 個(gè)隱藏單元。

我們使用帶有 Adam 的隨機(jī)梯度下降來(lái)訓(xùn)練每一個(gè)模型(Kingma 和 Ba,2014)。每一個(gè)更新都是使用由 128 個(gè)句子對(duì)組成的迷你批次來(lái)計(jì)算。梯度的常規(guī)是使用閾值 1 來(lái)剪切(Pascanu 等,2013)。

解碼和評(píng)估

我們使用集束搜索來(lái)近似尋找特定源句子的最可能的翻譯。集束寬對(duì)子字等級(jí)和字符等級(jí)解碼器分別是 5 和 15。選擇它們是基于發(fā)展組的翻譯質(zhì)量。翻譯使用 BLEU 進(jìn)行評(píng)估。

多層解碼器和軟對(duì)齊機(jī)制

當(dāng)解碼器是一個(gè)多層循環(huán)神經(jīng)網(wǎng)絡(luò)(包括一個(gè)堆積網(wǎng)絡(luò),以及提出的雙度量網(wǎng)絡(luò)),針對(duì) L 層,解碼器一次輸出多個(gè)隱藏矢量 {h1, …,hL}。這使得軟對(duì)齊機(jī)制(方程(3)中的 fscore)中可以有一個(gè)額外的自由度。我們使用其它選項(xiàng)來(lái)進(jìn)行評(píng)估,包括(1)只使用 hL (慢速層)和(2)使用所有(結(jié)合)。

組合

我們還評(píng)估了神經(jīng)機(jī)器翻譯模型的組合,在所有四組語(yǔ)言對(duì)上,將其與較先進(jìn)的基于詞組翻譯系統(tǒng)進(jìn)行比較。我們?nèi)∶恳徊捷敵龈怕蚀笃骄担瑥亩鴱哪骋粋€(gè)組合中解碼。

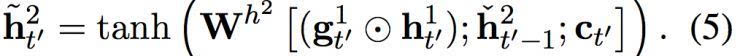

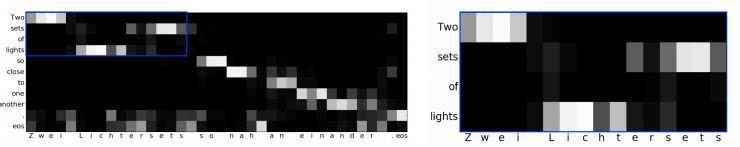

圖3:使用 BPE → Char (雙度量)模型,En-De 中測(cè)試?yán)拥膶?duì)齊矩陣。

6、定量分析

用于對(duì)齊的慢速層

在 En-De 上,我們測(cè)試應(yīng)該使用哪一層解碼器來(lái)計(jì)算軟對(duì)齊。在子字等級(jí)解碼器的情況下,我們沒(méi)有觀察到選擇解碼器的兩層與使用所有層的結(jié)合(表格1(a-b))有什么不同。另一方面,有了字符等級(jí)的解碼器,我們注意到,當(dāng)針對(duì)軟對(duì)齊機(jī)制(表格1(c-g))只使用慢速層(h2)的時(shí)候,表現(xiàn)會(huì)有提升。這意味著,在目標(biāo)中將更大的部分與源一方的子字單元對(duì)齊,會(huì)給軟對(duì)齊機(jī)制帶來(lái)益處,我們對(duì)所有其它語(yǔ)言對(duì)都只使用慢速層。

單一模型

在表格1中,我們呈現(xiàn)了一個(gè)關(guān)于所有語(yǔ)言對(duì)的翻譯質(zhì)量的綜合報(bào)告,包括了(1)子字等級(jí)解碼器、(2)字符等級(jí)基準(zhǔn)解碼器和(3)字符等級(jí)雙度量解碼器。我們可以看見(jiàn),針對(duì) En-Cs 和 En-Fi,兩種字符等級(jí)解碼器都比較明顯地優(yōu)于子字等級(jí)解碼器。在 En-De 上,字符等級(jí)基準(zhǔn)解碼器比子字等級(jí)解碼器和字符等級(jí)雙度量解碼器都更好,證實(shí)了字符等級(jí)建模的有效性。在 En-Ru 上,在單一模型中,字符等級(jí)解碼器優(yōu)于子字等級(jí)解碼器,但是,我們觀察到所有三種選項(xiàng)之間就總體來(lái)說(shuō)都比較均等。

這些結(jié)果顯然驗(yàn)證了這一點(diǎn):不使用顯性的分割而進(jìn)行字符等級(jí)的翻譯,的確是有可能的。實(shí)際上,我們觀察到字符等級(jí)的翻譯質(zhì)量經(jīng)常超過(guò)詞語(yǔ)等級(jí)的翻譯。當(dāng)然,我們又一次提到我們的實(shí)驗(yàn)有限制,解碼器只使用未分割字符序列,未來(lái)還需要研究用一個(gè)未分割的字符序列來(lái)代替源句子。

組合

每一個(gè)組合都是使用8個(gè)獨(dú)立模型打造的。我們得出的第一個(gè)觀察結(jié)論是,在所有的語(yǔ)言對(duì)中,神經(jīng)機(jī)器翻譯與較先進(jìn)的非神經(jīng)翻譯系統(tǒng)表現(xiàn)相當(dāng),或者經(jīng)常更好。而且,字符等級(jí)的解碼器在所有情況中都優(yōu)于子字等級(jí)的解碼器。

7 定性分析

(1)字符等級(jí)的解碼器能否生成長(zhǎng)的、連貫的句子?

字符翻譯比詞語(yǔ)翻譯要長(zhǎng)得多,可能使得循環(huán)神經(jīng)網(wǎng)絡(luò)以字符生成連貫句子變得更難。這種想法證明是錯(cuò)誤的。就像在圖2(左)中,子字等級(jí)和字符等級(jí)的解碼器之間沒(méi)有什么明顯不同,雖然生成翻譯的長(zhǎng)度總體來(lái)說(shuō)在字符里會(huì)長(zhǎng)5-10倍。

(2)字符等級(jí)的解碼器對(duì)罕見(jiàn)詞語(yǔ)有幫助嗎?

基于字符建模的其中的一個(gè)好處是,可以將任何字符序列建模,因此能更好地對(duì)罕見(jiàn)的詞形變體進(jìn)行建模。我們實(shí)證性地證實(shí)了這一點(diǎn),通過(guò)觀察子字等級(jí)和字符等級(jí)解碼器的平均負(fù)對(duì)數(shù)概率,隨著詞語(yǔ)頻率下降,兩者之間的差距也越來(lái)越大。這展示在圖2(右),解釋了我們實(shí)驗(yàn)中字符等級(jí)解碼成功背后的一個(gè)原因(我們定義 diff (x, y) = x - y)。

(3)字符等級(jí)解碼器能否在原詞語(yǔ)和目標(biāo)字符之間軟對(duì)齊?

在圖3(左)中,我們展示了一個(gè)源句子軟對(duì)齊的例子,“Two sets of light so close to one another” (兩組互相非常接近的燈光)。很明顯,字符等級(jí)的翻譯模型良好抓取了源子字和目標(biāo)字符之間的對(duì)齊。我們觀察到,字符等級(jí)解碼器在生成一個(gè)德語(yǔ)復(fù)合詞 “Lichtersets”(燈的組合)時(shí),正確對(duì)齊到了“l(fā)ights”(燈)和“sets of”(組合)(放大版本詳見(jiàn)圖3(右))。這種行為在英語(yǔ)單詞“one another”和德語(yǔ)單詞“einaner” (編者注:都是“互相”的意思)也類似地出現(xiàn)了,這不意味著在原詞語(yǔ)和目標(biāo)字符之間存在對(duì)齊。相反,這意味著字符等級(jí)解碼器的內(nèi)在狀態(tài)——基準(zhǔn)或者雙度量 ——良好抓取了字符有意義的部分,讓模型可以將其匹配到源句子中更大的部分(子字)中去。

(4)字符等級(jí)解碼器的解碼速度有多快?

我們?cè)?newstest - 2013 主體(En-De) 上,用一個(gè)單一的 Titan X GPU 評(píng)估了子字等級(jí)基準(zhǔn)的解碼速度、字符等級(jí)基準(zhǔn)和字符等級(jí)雙度量解碼器。子字等級(jí)基準(zhǔn)解碼器每秒生產(chǎn) 31.9 個(gè)詞,字符等級(jí)基準(zhǔn)解碼器和字符等級(jí)雙度量解碼器每秒分別生成 27.5 個(gè)單詞和 25.6 個(gè)單詞。注意,這是在一個(gè)在線設(shè)定中評(píng)估的,其中我們進(jìn)行連續(xù)翻譯,同一時(shí)間只翻譯一句話。在批量設(shè)定中進(jìn)行翻譯,可能與這些結(jié)果不同。

8. 結(jié)論

在這篇論文中,我們研究一個(gè)基本問(wèn)題,也就是一個(gè)最近提出的神經(jīng)機(jī)器翻譯系統(tǒng)是否能直接在字符等級(jí)處理翻譯,不需要任何詞語(yǔ)分割。我們集中在目標(biāo)方,其中一個(gè)解碼器需要一次生成一個(gè)字符,同時(shí)在目標(biāo)字符和源子字之間進(jìn)行軟對(duì)齊。我們大量的實(shí)驗(yàn)利用了四個(gè)語(yǔ)言對(duì)——En-Cs、En-De、En-Ru 和 En-Fi——強(qiáng)有力證明了字符等級(jí)的神經(jīng)機(jī)器翻譯是可能的,并且實(shí)際上會(huì)從中獲益。

我們的結(jié)果有一個(gè)局限:我們?cè)谠捶绞褂米幼址?hào)。然而,這讓我們可以獲得更加細(xì)微的分析,但是在未來(lái)必須調(diào)查另一種設(shè)定,其中源一方也表征為字符序列。

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4384.html

摘要:然而反向傳播自誕生起,也受到了無(wú)數(shù)質(zhì)疑。主要是因?yàn)椋聪騻鞑C(jī)制實(shí)在是不像大腦。他集結(jié)了來(lái)自和多倫多大學(xué)的強(qiáng)大力量,對(duì)這些替代品進(jìn)行了一次評(píng)估。號(hào)選手,目標(biāo)差傳播,。其中來(lái)自多倫多大學(xué)和,一作和來(lái)自,來(lái)自多倫多大學(xué)。 32年前,人工智能、機(jī)器學(xué)習(xí)界的泰斗Hinton提出反向傳播理念,如今反向傳播已經(jīng)成為推動(dòng)深度學(xué)習(xí)爆發(fā)的核心技術(shù)。然而反向傳播自誕生起,也受到了無(wú)數(shù)質(zhì)疑。這些質(zhì)疑來(lái)自各路科學(xué)家...

摘要:在與李世石比賽期間,谷歌天才工程師在漢城校區(qū)做了一次關(guān)于智能計(jì)算機(jī)系統(tǒng)的大規(guī)模深度學(xué)習(xí)的演講。而這些任務(wù)完成后,谷歌已經(jīng)開(kāi)始進(jìn)行下一項(xiàng)挑戰(zhàn)了。谷歌深度神經(jīng)網(wǎng)絡(luò)小歷史谷歌大腦計(jì)劃于年啟動(dòng),聚焦于真正推動(dòng)神經(jīng)網(wǎng)絡(luò)科學(xué)能達(dá)到的較先進(jìn)的技術(shù)。 在AlphaGo與李世石比賽期間,谷歌天才工程師Jeff Dean在Google Campus漢城校區(qū)做了一次關(guān)于智能計(jì)算機(jī)系統(tǒng)的大規(guī)模深度學(xué)習(xí)(Large-...

摘要:八月初,我有幸有機(jī)會(huì)參加了蒙特利爾深度學(xué)習(xí)暑期學(xué)校的課程,由最知名的神經(jīng)網(wǎng)絡(luò)研究人員組成的為期天的講座。另外,當(dāng)損失函數(shù)接近全局最小時(shí),概率會(huì)增加。降低訓(xùn)練過(guò)程中的學(xué)習(xí)率。對(duì)抗樣本的訓(xùn)練據(jù)最近信息顯示,神經(jīng)網(wǎng)絡(luò)很容易被對(duì)抗樣本戲弄。 8月初的蒙特利爾深度學(xué)習(xí)暑期班,由Yoshua Bengio、 Leon Bottou等大神組成的講師團(tuán)奉獻(xiàn)了10天精彩的講座,劍橋大學(xué)自然語(yǔ)言處理與信息檢索研...

摘要:另外,當(dāng)損失函數(shù)接近全局最小時(shí),概率會(huì)增加。降低訓(xùn)練過(guò)程中的學(xué)習(xí)率。對(duì)抗樣本的訓(xùn)練據(jù)最近信息顯示,神經(jīng)網(wǎng)絡(luò)很容易被對(duì)抗樣本戲弄。使用高度正則化會(huì)有所幫助,但會(huì)影響判斷不含噪聲圖像的準(zhǔn)確性。 由 Yoshua Bengio、 Leon Bottou 等大神組成的講師團(tuán)奉獻(xiàn)了 10 天精彩的講座,劍橋大學(xué)自然語(yǔ)言處理與信息檢索研究組副研究員 Marek Rei 參加了本次課程,在本文中,他精煉地...

摘要:本文是雜志為紀(jì)念人工智能周年而專門(mén)推出的深度學(xué)習(xí)綜述,也是和三位大神首次合寫(xiě)同一篇文章。逐漸地,這些應(yīng)用使用一種叫深度學(xué)習(xí)的技術(shù)。監(jiān)督學(xué)習(xí)機(jī)器學(xué)習(xí)中,不論是否是深層,最常見(jiàn)的形式是監(jiān)督學(xué)習(xí)。 本文是《Nature》雜志為紀(jì)念人工智能60周年而專門(mén)推出的深度學(xué)習(xí)綜述,也是Hinton、LeCun和Bengio三位大神首次合寫(xiě)同一篇文章。該綜述在深度學(xué)習(xí)領(lǐng)域的重要性不言而喻,可以說(shuō)是所有人入門(mén)深...

閱讀 1391·2021-10-14 09:43

閱讀 4244·2021-09-27 13:57

閱讀 4575·2021-09-22 15:54

閱讀 2572·2021-09-22 10:54

閱讀 2387·2021-09-22 10:02

閱讀 2124·2021-08-27 13:11

閱讀 879·2019-08-29 18:44

閱讀 1654·2019-08-29 15:20