資訊專欄INFORMATION COLUMN

摘要:現(xiàn)為谷歌軟件工程師。盡管存在這兩個(gè)問題,目前仍是最常用的,在搭建人工神經(jīng)網(wǎng)絡(luò)的時(shí)候推薦優(yōu)先嘗試函數(shù)人們?yōu)榱私鉀Q,提出了將的前半段設(shè)為而非。

夏飛,清華大學(xué)計(jì)算機(jī)軟件學(xué)士,卡內(nèi)基梅隆大學(xué)人工智能碩士。現(xiàn)為谷歌軟件工程師。

TLDR (or the take-away)

優(yōu)先使用ReLU (Rectified Linear Unit) 函數(shù)作為神經(jīng)元的activation function:

背景

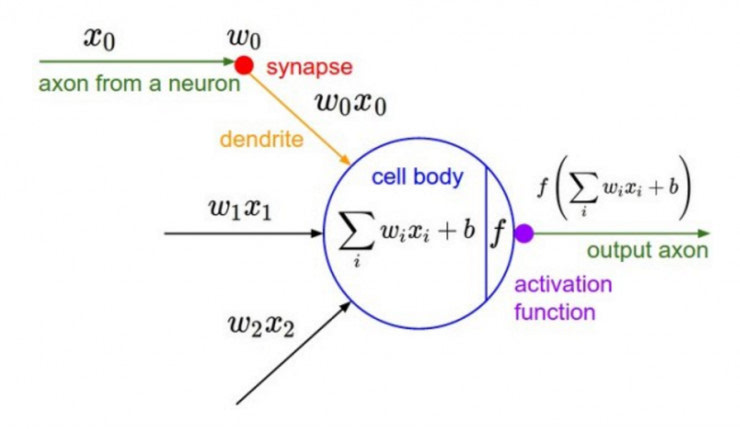

深度學(xué)習(xí)的基本原理是基于人工神經(jīng)網(wǎng)絡(luò),信號(hào)從一個(gè)神經(jīng)元進(jìn)入,經(jīng)過非線性的activation function,傳入到下一層神經(jīng)元;再經(jīng)過該層神經(jīng)元的activate,繼續(xù)往下傳遞,如此循環(huán)往復(fù),直到輸出層。正是由于這些非線性函數(shù)的反復(fù)疊加,才使得神經(jīng)網(wǎng)絡(luò)有足夠的capacity來抓取復(fù)雜的pattern,在各個(gè)領(lǐng)域取得state-of-the-art的結(jié)果。顯而易見,activation function在深度學(xué)習(xí)中舉足輕重,也是很活躍的研究領(lǐng)域之一。目前來講,選擇怎樣的activation function不在于它能否模擬真正的神經(jīng)元,而在于能否便于優(yōu)化整個(gè)深度神經(jīng)網(wǎng)絡(luò)。

下面我們簡(jiǎn)單聊一下各類函數(shù)的特點(diǎn)以及為什么現(xiàn)在優(yōu)先推薦ReLU函數(shù)。

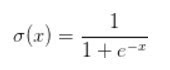

Sigmoid函數(shù)

Sigmoid函數(shù)是深度學(xué)習(xí)領(lǐng)域開始時(shí)使用頻率較高的activation function。它是便于求導(dǎo)的平滑函數(shù),其導(dǎo)數(shù)為,這是優(yōu)點(diǎn)。然而,Sigmoid有三大缺點(diǎn):

容易出現(xiàn)gradient vanishing

函數(shù)輸出并不是zero-centered

冪運(yùn)算相對(duì)來講比較耗時(shí)

Gradient Vanishing

優(yōu)化神經(jīng)網(wǎng)絡(luò)的方法是Back Propagation,即導(dǎo)數(shù)的后向傳遞:先計(jì)算輸出層對(duì)應(yīng)的loss,然后將loss以導(dǎo)數(shù)的形式不斷向上一層網(wǎng)絡(luò)傳遞,修正相應(yīng)的參數(shù),達(dá)到降低loss的目的。 Sigmoid函數(shù)在深度網(wǎng)絡(luò)中常常會(huì)導(dǎo)致導(dǎo)數(shù)逐漸變?yōu)?,使得參數(shù)無法被更新,神經(jīng)網(wǎng)絡(luò)無法被優(yōu)化。

原因在于兩點(diǎn):

在上圖中容易看出,當(dāng)中較大或較小時(shí),導(dǎo)數(shù)接近0,而后向傳遞的數(shù)學(xué)依據(jù)是微積分求導(dǎo)的鏈?zhǔn)椒▌t,當(dāng)前層的導(dǎo)數(shù)需要之前各層導(dǎo)數(shù)的乘積,幾個(gè)小數(shù)的相乘,結(jié)果會(huì)很接近0

Sigmoid導(dǎo)數(shù)的較大值是0.25,這意味著導(dǎo)數(shù)在每一層至少會(huì)被壓縮為原來的1/4,通過兩層后被變?yōu)?/16,…,通過10層后為1/1048576。請(qǐng)注意這里是“至少”,導(dǎo)數(shù)達(dá)到較大值這種情況還是很少見的。

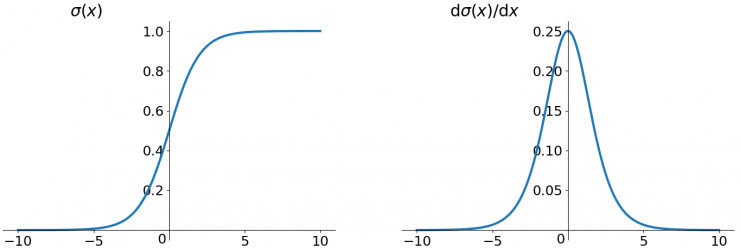

輸出不是zero-centered

Sigmoid函數(shù)的輸出值恒大于0,這會(huì)導(dǎo)致模型訓(xùn)練的收斂速度變慢。

舉例來講,對(duì),如果所有均為正數(shù)或負(fù)數(shù),那么其對(duì)的導(dǎo)數(shù)總是正數(shù)或負(fù)數(shù),這會(huì)導(dǎo)致如下圖紅色箭頭所示的階梯式更新,這顯然并非一個(gè)好的優(yōu)化路徑。深度學(xué)習(xí)往往需要大量時(shí)間來處理大量數(shù)據(jù),模型的收斂速度是尤為重要的。所以,總體上來講,訓(xùn)練深度學(xué)習(xí)網(wǎng)絡(luò)盡量使用zero-centered數(shù)據(jù) (可以經(jīng)過數(shù)據(jù)預(yù)處理實(shí)現(xiàn)) 和zero-centered輸出。

冪運(yùn)算相對(duì)耗時(shí)

相對(duì)于前兩項(xiàng),這其實(shí)并不是一個(gè)大問題,我們目前是具備相應(yīng)計(jì)算能力的,但面對(duì)深度學(xué)習(xí)中龐大的計(jì)算量,較好是能省則省 :-)。之后我們會(huì)看到,在ReLU函數(shù)中,需要做的僅僅是一個(gè)thresholding,相對(duì)于冪運(yùn)算來講會(huì)快很多。

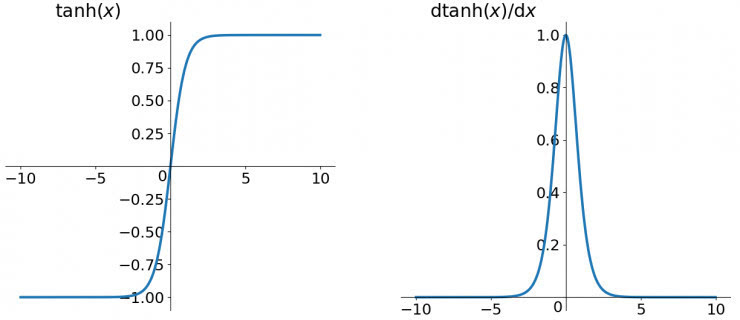

tanh函數(shù)

tanh讀作Hyperbolic Tangent,如上圖所示,它解決了zero-centered的輸出問題,然而,gradient vanishing的問題和冪運(yùn)算的問題仍然存在。

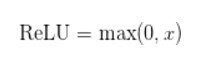

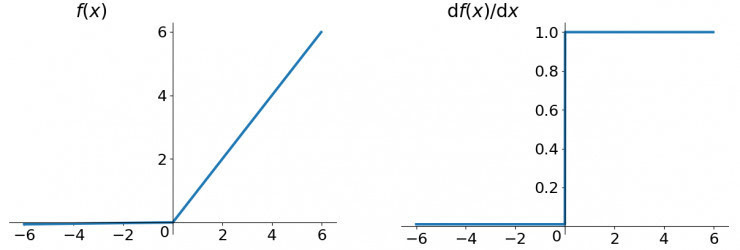

ReLU函數(shù)

ReLU函數(shù)其實(shí)就是一個(gè)取較大值函數(shù),注意這并不是全區(qū)間可導(dǎo)的,但是我們可以取sub-gradient,如上圖所示。ReLU雖然簡(jiǎn)單,但卻是近幾年的重要成果,有以下幾大優(yōu)點(diǎn):

解決了gradient vanishing問題 (在正區(qū)間)

計(jì)算速度非常快,只需要判斷輸入是否大于0

收斂速度遠(yuǎn)快于sigmoid和tanh

ReLU也有幾個(gè)需要特別注意的問題:

ReLU的輸出不是zero-centered

Dead ReLU Problem,指的是某些神經(jīng)元可能永遠(yuǎn)不會(huì)被激活,導(dǎo)致相應(yīng)的參數(shù)永遠(yuǎn)不能被更新。有兩個(gè)主要原因可能導(dǎo)致這種情況產(chǎn)生: (1) 非常不幸的參數(shù)初始化,這種情況比較少見 (2) learning rate太高導(dǎo)致在訓(xùn)練過程中參數(shù)更新太大,不幸使網(wǎng)絡(luò)進(jìn)入這種狀態(tài)。解決方法是可以采用Xavier初始化方法,以及避免將learning rate設(shè)置太大或使用adagrad等自動(dòng)調(diào)節(jié)learning rate的算法。

盡管存在這兩個(gè)問題,ReLU目前仍是最常用的activation function,在搭建人工神經(jīng)網(wǎng)絡(luò)的時(shí)候推薦優(yōu)先嘗試!

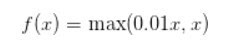

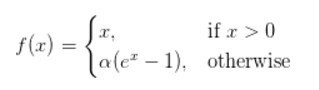

Leaky ReLU函數(shù)

人們?yōu)榱私鉀QDead ReLU Problem,提出了將ReLU的前半段設(shè)為而非0。另外一種直觀的想法是基于參數(shù)的方法,即Parametric ReLU:,其中可由back propagation學(xué)出來。理論上來講,Leaky ReLU有ReLU的所有優(yōu)點(diǎn),外加不會(huì)有Dead ReLU問題,但是在實(shí)際操作當(dāng)中,并沒有完全證明Leaky ReLU總是好于ReLU。

ELU (Exponential Linear Units) 函數(shù)

ELU也是為解決ReLU存在的問題而提出,顯然,ELU有ReLU的基本所有優(yōu)點(diǎn),以及:

不會(huì)有Dead ReLU問題

輸出的均值接近0,zero-centered

它的一個(gè)小問題在于計(jì)算量稍大。類似于Leaky ReLU,理論上雖然好于ReLU,但在實(shí)際使用中目前并沒有好的證據(jù)ELU總是優(yōu)于ReLU。

小結(jié)

建議使用ReLU函數(shù),但是要注意初始化和learning rate的設(shè)置;可以嘗試使用Leaky ReLU或ELU函數(shù);不建議使用tanh,尤其是sigmoid函數(shù)。

參考資料

Udacity Deep Learning Courses

Stanford CS231n Course

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4496.html

摘要:當(dāng)云平臺(tái)出現(xiàn)網(wǎng)絡(luò)故障系統(tǒng)故障等問題,這對(duì)云租戶用戶有時(shí)甚至是致命的,所以不少是由高級(jí)別開發(fā)人員轉(zhuǎn)型而來。目前國(guó)內(nèi)各大云廠商也基本都提供了應(yīng)用運(yùn)維平臺(tái),包括騰訊藍(lán)鯨阿里華為等。 DevOps 全鏈路 下圖是我們熟知的軟件研發(fā)環(huán)節(jié),在迭代頻率高的研發(fā)組織里,一天可能要經(jīng)歷多次如下循環(huán)。對(duì)于用戶群體龐大或者正在經(jīng)歷大幅業(yè)務(wù)擴(kuò)張的企業(yè)研發(fā)組織,除了重點(diǎn)關(guān)注應(yīng)用的快速上線之外,如何保障應(yīng)用的高可...

摘要:被稱為亞馬遜的新服務(wù)提供了強(qiáng)大的功能,如圖像分析,文本到語音轉(zhuǎn)換和自然語言處理。換句話說,其任務(wù)是將谷歌的機(jī)器學(xué)習(xí)功能產(chǎn)品化。亞馬遜平臺(tái)推出的這些新服務(wù)中的第一個(gè)是名為的圖像識(shí)別服務(wù)。 亞馬遜一直在其零售業(yè)務(wù)中使用深度學(xué)習(xí)和人工智能來提高客戶體驗(yàn)。該公司聲稱,它有數(shù)千名工程師專門從事人工智能相關(guān)開發(fā),以改善搜索、物流、產(chǎn)品推薦和庫(kù)存管理。亞馬遜現(xiàn)在正在將相同的專業(yè)知識(shí)帶給云,展示了開發(fā)人員可...

摘要:在低端領(lǐng)域,在上訓(xùn)練模型的價(jià)格比便宜兩倍。硬件定價(jià)價(jià)格變化頻繁,但目前提供的實(shí)例起價(jià)為美元小時(shí),以秒為增量計(jì)費(fèi),而更強(qiáng)大且性能更高的實(shí)例起價(jià)為美元小時(shí)。 隨著越來越多的現(xiàn)代機(jī)器學(xué)習(xí)任務(wù)都需要使用GPU,了解不同GPU供應(yīng)商的成本和性能trade-off變得至關(guān)重要。初創(chuàng)公司Rare Technologies最近發(fā)布了一個(gè)超大規(guī)模機(jī)器學(xué)習(xí)基準(zhǔn),聚焦GPU,比較了幾家受歡迎的硬件提供商,在機(jī)器學(xué)...

摘要:本文內(nèi)容節(jié)選自由主辦的第七屆,北京一流科技有限公司首席科學(xué)家袁進(jìn)輝老師木分享的讓簡(jiǎn)單且強(qiáng)大深度學(xué)習(xí)引擎背后的技術(shù)實(shí)踐實(shí)錄。年創(chuàng)立北京一流科技有限公司,致力于打造分布式深度學(xué)習(xí)平臺(tái)的事實(shí)工業(yè)標(biāo)準(zhǔn)。 本文內(nèi)容節(jié)選自由msup主辦的第七屆TOP100summit,北京一流科技有限公司首席科學(xué)家袁進(jìn)輝(老師木)分享的《讓AI簡(jiǎn)單且強(qiáng)大:深度學(xué)習(xí)引擎OneFlow背后的技術(shù)實(shí)踐》實(shí)錄。 北京一流...

閱讀 2317·2021-11-15 11:38

閱讀 2447·2021-11-15 11:37

閱讀 2552·2021-08-24 10:00

閱讀 2912·2019-08-30 15:56

閱讀 1267·2019-08-30 15:53

閱讀 3707·2019-08-29 18:43

閱讀 2935·2019-08-29 17:01

閱讀 3259·2019-08-29 16:25