資訊專欄INFORMATION COLUMN

摘要:也是相關(guān)的,因?yàn)樗鼈円呀?jīng)成為實(shí)現(xiàn)和使用的主要基準(zhǔn)之一。在本文發(fā)表之后不久,和中有容易獲得的不同實(shí)現(xiàn)用于測(cè)試你所能想到的任何數(shù)據(jù)集。在這篇文章中,作者提出了對(duì)訓(xùn)練的不同增強(qiáng)方案。在這種情況下,鑒別器僅用于指出哪些是值得匹配的統(tǒng)計(jì)信息。

本文不涉及的內(nèi)容

首先,你不會(huì)在本文中發(fā)現(xiàn):

復(fù)雜的技術(shù)說明

代碼(盡管有為那些感興趣的人留的代碼鏈接)

詳盡的研究清單(點(diǎn)擊這里進(jìn)行查看 鏈接:http://suo.im/2opXlF)

本文涉及的內(nèi)容

關(guān)于 GAN 的相關(guān)主題的總結(jié)

許多其他網(wǎng)站、帖子和文章的鏈接,幫助你確定專注點(diǎn)

目錄

1. 理解 GAN

2. GAN: 一場(chǎng)革命

?1. DCGAN

?2. 改進(jìn)的 DCGAN

?3. 條件性 GAN

?4. InfoGAN

?5. Wasserstein GAN

3. 結(jié)語

理解 GAN

如果你熟悉 GAN,可以跳過本節(jié)。

如果你正在閱讀本文,很有可能已聽說 GAN 大有前途。這種夸張說法合理嗎?以下是 Facebook 人工智能研究室主任楊立昆(Yann LeCun)對(duì) GAN 的看法:

生成對(duì)抗網(wǎng)絡(luò)(GAN)是過去十年機(jī)器學(xué)習(xí)中最有趣的想法。

我個(gè)人認(rèn)為,GAN 有巨大的潛力,但我們還有很多事情要搞明白。

那么,什么是 GAN?接下來我將要對(duì)其做一個(gè)簡(jiǎn)要描述。如果你不熟悉并想了解更多,有很多很棒的網(wǎng)站有很好的解釋。我個(gè)人推薦 Eric Jang(鏈接:http://suo.im/4y0bxU)和 Brandon Amos(鏈接:http://suo.im/3Ur3DW)的博客。

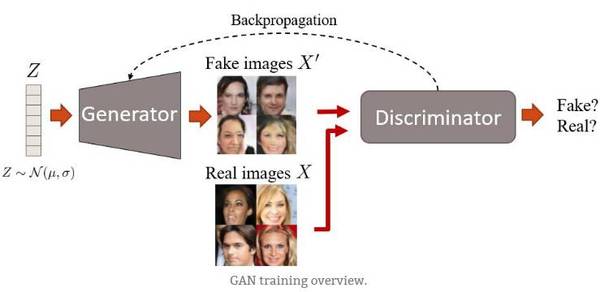

GAN 最初由 Ian Goodfellow 提出,它有兩個(gè)網(wǎng)絡(luò):生成器和鑒別器。兩個(gè)網(wǎng)絡(luò)在同一時(shí)間進(jìn)行訓(xùn)練,并在極小極大(minimax)游戲中相互博弈。生成器通過創(chuàng)建逼真的圖像來愚弄鑒別器,而鑒別器被訓(xùn)練從而不被生成器所愚弄。

訓(xùn)練概述

首先,生成器生成圖像。它通過從簡(jiǎn)單分布中(例如正態(tài)分布)采樣向量噪聲 Z,然后將該矢量上采樣到圖像來生成圖像。在第一次迭代中,這些圖像看起來很嘈雜。然后,鑒別器被給予真、假圖像,并學(xué)習(xí)區(qū)分它們。生成器稍后通過反向傳播步驟接收鑒別器的「反饋」,在產(chǎn)生圖像時(shí)變得更好。最后,我們希望假圖像的分布盡可能接近真實(shí)圖像的分布。或者,簡(jiǎn)單來說,我們希望假圖像看起來盡可能貌似真實(shí)。

值得一提的是,由于 GAN 中使用的極小極大(minimax)優(yōu)化,訓(xùn)練有可能相當(dāng)不穩(wěn)定。但是,有一些技巧可以用來使得訓(xùn)練更魯棒。

這就是使得生成的臉部圖像逐漸變得更加真實(shí)的一個(gè)例子:

前兩個(gè)階段 GAN 的輸出結(jié)果。使用的數(shù)據(jù)集是 CelebA。

代碼

如果您對(duì) GAN 的基本實(shí)現(xiàn)感興趣,這里是一些簡(jiǎn)短代碼的鏈接:

Tensorflow(鏈接:http://suo.im/pLYbO)

Torch 和 Python(PyTorch):[代碼](鏈接:http://suo.im/1LcbX5)[博客文章](鏈接:http://suo.im/2V9ICE)

Torch 和 Lua

這些不是較先進(jìn)的,但它們很好地抓住了核心思想。如果你正在尋找較佳實(shí)現(xiàn)來做自己的東西,請(qǐng)看下一節(jié)。

GAN: 一場(chǎng)革命

在這里,我將按照時(shí)間順序大體描述一下過去幾年出現(xiàn)的一些有關(guān) GAN 的進(jìn)展和類型。

深度卷積 GAN(DCGAN)

TL; DR:DCGAN 是 GAN 架構(gòu)的第一大改進(jìn)。它們?cè)谟?xùn)練方面更穩(wěn)定,并產(chǎn)生更高質(zhì)量的采樣。

[文章](鏈接:https://arxiv.org/abs/1511.06434)

DCGAN 的作者著重于改進(jìn)初始 GAN 的架構(gòu)。我認(rèn)為他們花了很長時(shí)間來做深度學(xué)習(xí)里最令人興奮的事情:嘗試很多參數(shù)!好極了!最后,它完全有了回報(bào)。除此之外,他們發(fā)現(xiàn):

兩個(gè)網(wǎng)絡(luò)都必須進(jìn)行批量歸一化。

采用完全隱藏的連接層不是一個(gè)好主意。

避免池化(pooling),簡(jiǎn)單地跨越你的卷積!

ReLU 激活是你的朋友(幾乎總是)。

DCGAN 也是相關(guān)的,因?yàn)樗鼈円呀?jīng)成為實(shí)現(xiàn)和使用 GAN 的主要基準(zhǔn)之一。在本文發(fā)表之后不久,Theano、Torch、Tensorflow 和 Chainer 中有容易獲得的不同實(shí)現(xiàn)用于測(cè)試你所能想到的任何數(shù)據(jù)集。因此,如果你遇到奇怪的生成數(shù)據(jù)集,你完全可以責(zé)怪這些人。

在以下情況,你可能想要使用 DCGAN:

你想要比常規(guī) GAN 更好的東西(或者說,總是)。常規(guī) GAN 可以在簡(jiǎn)單的數(shù)據(jù)集上工作,但是 DCGAN 相比要好得多。

你正在尋找一個(gè)堅(jiān)實(shí)的基準(zhǔn),以便與、較先進(jìn)的 GAN 算法進(jìn)行比較。

從這一點(diǎn)上,我將描述的所有類型的 GAN 都被假定為具有 DCGAN 架構(gòu),除非明確說明。

改進(jìn)的 DCGAN

TL; DR:一系列改進(jìn)以前 DCGAN 的技術(shù)。比如,這個(gè)改進(jìn)的基準(zhǔn)允許生成更好的高分辨率圖像。

[文章](鏈接:https://arxiv.org/abs/1606.03498)

與 GAN 有關(guān)的主要問題之一是它們的收斂性。它是不能保證的,而且即使優(yōu)化了 DCGAN 架構(gòu),訓(xùn)練仍然相當(dāng)不穩(wěn)定。在這篇文章中,作者提出了對(duì) GAN 訓(xùn)練的不同增強(qiáng)方案。這里是其中的一些:

特征匹配:他們沒有使生成器盡可能地欺騙鑒別器,而是提出了一個(gè)新的目標(biāo)函數(shù)。該目標(biāo)要求生成器生成與實(shí)際數(shù)據(jù)的統(tǒng)計(jì)信息相匹配的數(shù)據(jù)。在這種情況下,鑒別器僅用于指出哪些是值得匹配的統(tǒng)計(jì)信息。

歷史平均:更新參數(shù)時(shí),還要考慮其過去值。

單邊標(biāo)簽平滑:這一點(diǎn)很簡(jiǎn)單:只需將你的鑒別器目標(biāo)輸出從 [0 = 假圖像,1 = 真圖像] 切換到 [0 = 假圖像,0.9 =真圖像]。是的,這改善了訓(xùn)練。

虛擬批量歸一化:通過使用在一個(gè)參考批處理中收集的統(tǒng)計(jì)信息,避免同一批次的數(shù)據(jù)依賴性。它在計(jì)算上的代價(jià)很大,所以僅用于生成器。

所有這些技術(shù)都可以使模型更好地生成高分辨率圖像,這是 GAN 的弱點(diǎn)之一。作為對(duì)比,請(qǐng)參見原始 DCGAN 與改進(jìn)的 DCGAN 在 128x128 圖像上的區(qū)別:

這些應(yīng)該是狗的圖像。如你所見,DCGAN 無法表征它們,而使用改進(jìn)的 DCGAN,你至少可以看到有一些像小狗一樣的東西。這也暴露了 GAN 的另一個(gè)局限,即生成結(jié)構(gòu)化的內(nèi)容。

你也許想要使用改進(jìn)的 DCGAN,如果:

你想要一個(gè)改進(jìn)版本的 DCGAN(我確信你原本不指望:P)以生成更高分辨率的圖像。

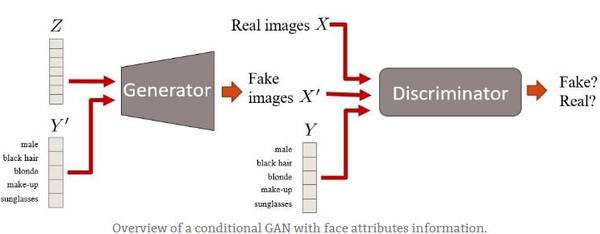

條件性 GAN(CGAN)

TL; DR:這些是使用額外標(biāo)簽信息的 GAN。這會(huì)帶來更好質(zhì)量的圖像,并能夠在一定程度上控制生成圖像的外觀。

[來源文章](https://arxiv.org/abs/1411.1784)

條件性 GAN 是 GAN 框架的擴(kuò)展。這里我們有條件信息 Y 來描述數(shù)據(jù)的一些方面。例如,如果我們正在處理人臉,則 Y 可以描述頭發(fā)顏色或性別等屬性。然后,將該屬性信息插入生成器和鑒別器。

具有面部屬性信息的條件性 GAN 概述。

條件性 GAN 有趣的原因有兩個(gè):

1. 當(dāng)你向模型輸入更多信息時(shí),GAN 學(xué)習(xí)利用它,因此能夠生成更好的樣本。

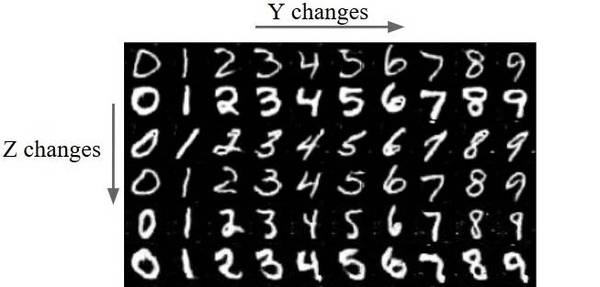

2. 我們有 2 種方式來控制圖像表示。沒有條件性 GAN,所有的圖像信息都被編碼在 Z 中。有了 cGAN,當(dāng)我們添加條件信息 Y 時(shí),現(xiàn)在這兩個(gè) Z 和 Y 將編碼不同的信息。例如,假設(shè) Y 編碼手寫數(shù)的數(shù)字(從 0 到 9)。然后,Z 將編碼所有不在 Y 中編碼的其它變量。例如,可以是數(shù)字的樣式(大小、重量、旋轉(zhuǎn)等)。

MNIST 樣本上 Z 和 Y 之間的差異。Z 固定在行上,Y 在列上。Z 編碼數(shù)字的樣式,Y 編碼數(shù)字本身。

最近的研究

有很多關(guān)于這個(gè)主題的有趣文章。我重點(diǎn)說這其中的兩個(gè):

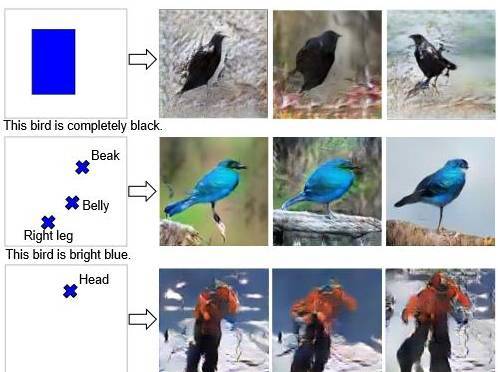

學(xué)習(xí)畫什么和在哪里畫 [文章](鏈接:https://arxiv.org/abs/1610.02454)[代碼](鏈接:https://github.com/reedscot/nips2016):在這篇文章中,作者提出了一種機(jī)制來告訴 GAN(通過文本描述),(a)你想要得到的圖像內(nèi)容是什么樣,(b)通過邊界框/地標(biāo)來告知元素的位置。看看它的生成結(jié)果:

StackGAN [article](鏈接:https://arxiv.org/abs/1612.03242)[code](https://github.com/hanzhanggit/StackGAN):這篇文章與前一篇相似。在這種情況下,他們專注于通過同時(shí)使用 2 個(gè) GAN 來提高圖像的質(zhì)量:Stage-I 和 Stage-II。Stage-I 用于獲取包含圖像「一般」構(gòu)想的低分辨率圖像。Stage II 采用更多的細(xì)節(jié)和更高的分辨率來優(yōu)化 Stage-I 的圖像。據(jù)我所知,這篇在生成高質(zhì)量圖像里是較好的模型之一。請(qǐng)自己看:

你也許想要使用條件性 GAN,如果:

你有一個(gè)已標(biāo)記的訓(xùn)練集,并希望提高生成圖像的質(zhì)量。

你想要明確控制圖像的某些方面(例如,我想在這一特定位置生成這一尺寸的紅鳥)。

InfoGANs

TL; DR:能夠以無監(jiān)督的方式在噪聲向量 Z 的一部分中編碼有意義的圖像特征的 GAN。例如,對(duì)一個(gè)數(shù)字的旋轉(zhuǎn)進(jìn)行編碼。

[文章](https://arxiv.org/abs/1606.03657)

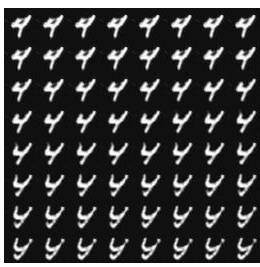

你有沒有想過輸入噪聲 Z 在一個(gè) GAN 中編碼的信息是什么?它通常以非常「嘈雜」的方式編碼圖像不同類型的特征。例如,你可以選擇 Z 向量的一個(gè)位置,并將其值從 -1 和 1 插值。這是你會(huì)在一個(gè)通過 MNIST 數(shù)字?jǐn)?shù)據(jù)集訓(xùn)練的模型上看到的:

對(duì) Z 插值。左上圖像的 Z 位置設(shè)置為 -1。然后,它被內(nèi)插到 1(右下圖像)。

在上圖中,生成的圖像看上去像是數(shù)字 4 慢慢變換成「Y」(最可能的是 4 和 9 之間的混合)。所以,這就是我所指的通過嘈雜的方式編碼這個(gè)信息:Z 的單一位置是圖像多個(gè)特征的參數(shù)。在這種情況下,這個(gè)位置改變了數(shù)字本身(某種程度上從 4 到 9)和樣式(從粗體到斜體)。然后,你無法定義 Z 的該位置的任何確切含義。

如果我們可以有一些 Z 的位置來表示和受限的信息會(huì)怎么樣呢,就像 cGAN 中的條件信息 Y 一樣?例如,如果第一個(gè)位置是一個(gè) 0 到 9 之間的值,它來控制數(shù)字的數(shù)量,而第二個(gè)位置控制其旋轉(zhuǎn),這會(huì)怎樣呢?這正是作者在文章中提出的。有意思的部分是,與 cGAN 不同,他們以無監(jiān)督的方式實(shí)現(xiàn)了這一點(diǎn),無需標(biāo)簽信息。

將 Z 矢量分成兩部分——C 和 Z——是他們成功的原因:

C 對(duì)數(shù)據(jù)分布的語義特征進(jìn)行編碼。

Z 編碼該分布的所有非結(jié)構(gòu)噪聲。

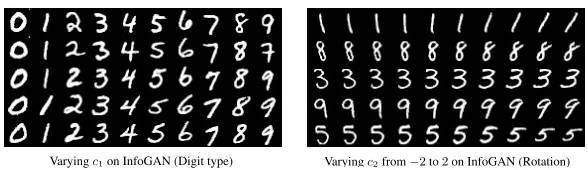

他們?nèi)绾螐?qiáng)制 C 對(duì)這些特征進(jìn)行編碼?他們改變了損失函數(shù)以防止 GAN 簡(jiǎn)單地忽略 C。因此,他們采用一個(gè)信息理論的規(guī)則,來確保 C 與生成器分配之間的高互信息。換句話說,如果 C 改變,生成的圖像也需要改變。結(jié)果,你無法明確控制哪種類型的信息會(huì)被編碼進(jìn) C,但 C 的每個(gè)位置都具有的含義。看一些視覺示例:

C 的第一個(gè)位置編碼數(shù)字類別,而第二個(gè)位置編碼旋轉(zhuǎn)。

但是,不使用標(biāo)簽信息需要付出代價(jià)。這里的限制是這些編碼僅適用于相當(dāng)簡(jiǎn)單的數(shù)據(jù)集,例如 MNIST 數(shù)字。此外,你仍然需要「手工制作」C 的每個(gè)位置。例如在文章中,他們需要指定 C 的第一個(gè)位置是 0 到 9 之間的整數(shù),因此它適用于數(shù)據(jù)集的 10 個(gè)數(shù)字類別。所以,你可能會(huì)認(rèn)為這不是 100% 無監(jiān)督,因?yàn)槟憧赡苄枰蚰P吞峁┮恍┬〖?xì)節(jié)。

你也許想要使用 infoGAN,如果:

你的數(shù)據(jù)集不是很復(fù)雜。

你想訓(xùn)練 cGAN,但你沒有標(biāo)簽信息。

你希望看到數(shù)據(jù)集的主要的有意義的圖像特征是什么,并且可以控制它們。

Wasserstein GAN

TL; DR:改變損失函數(shù)以包含 Wasserstein 距離。結(jié)果,WassGAN 具有與圖像質(zhì)量相關(guān)的損失函數(shù)。此外,訓(xùn)練穩(wěn)定性也提高了,而且不依賴于架構(gòu)。

[文章](https://arxiv.org/abs/1701.07875)

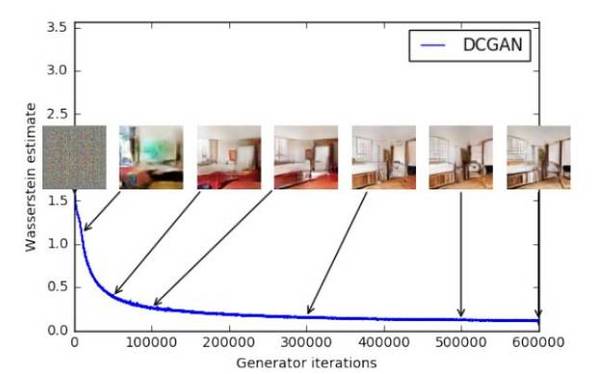

GAN 一直在收斂性方面存在問題,結(jié)果是,你不知道何時(shí)停止訓(xùn)練。換句話說,損失函數(shù)與圖像質(zhì)量不相關(guān)。這是一個(gè)頭痛的大問題,因?yàn)椋?/p>

你需要不斷查看樣本,以了解你的模型是否在正確訓(xùn)練。

你不知道何時(shí)應(yīng)該停止訓(xùn)練(沒有收斂)。

你沒有一個(gè)量化數(shù)值告訴你調(diào)整參數(shù)的效果如何。

例如,看這兩個(gè)能夠完美生成 MNIST 樣本的 DCGAN 的毫無信息量的損失函數(shù)圖:

僅通過看這個(gè)圖你知道什么時(shí)候停止訓(xùn)練嗎?我也不行。

這個(gè)可解釋性問題是 Wasserstein GAN 旨在解決的問題之一。怎么樣?GAN 可被解釋以最小化 Jensen-Shannon 發(fā)散,如果真和假的分布不重疊(通常是這種情況),則它為 0。所以,作者使用了 Wasserstein 距離,而不是最小化 JS 發(fā)散,它描述了從一個(gè)分布到另一個(gè)分布的「點(diǎn)」之間的距離。這大概是其主要思想,但如果你想了解更多,我強(qiáng)烈建議你訪問這一鏈接(http://suo.im/1wmf2t)進(jìn)行更深入的分析或閱讀文章本身。

因此,WassGAN 具有與圖像質(zhì)量相關(guān)的損失函數(shù)并能夠?qū)崿F(xiàn)收斂。它也更加穩(wěn)定,也就意味著它不依賴于架構(gòu)。例如,即使你去掉批處理歸一化或嘗試奇怪的架構(gòu),它也能很好地工作。

這是 WassGAN 損失函數(shù)的圖。損失越低,圖像質(zhì)量越高。整齊!

你也許想要使用 Wasserstein GAN,如果:

你正在尋找具有較高訓(xùn)練穩(wěn)定性的較先進(jìn)的 GAN。

你想要一個(gè)有信息量的可解釋的損失函數(shù)。

結(jié)語

所以,現(xiàn)在就是這些!我知道還有更有趣的研究去評(píng)論,但在這篇文章中,我決定專注于一個(gè)有限的集合。只是舉幾個(gè)例子,下面是一些我沒有評(píng)論的文章的簡(jiǎn)短列表,也許你想去看看:

GAN 應(yīng)用于視頻:https://github.com/SKTBrain/DiscoGAN

圖像完成:https://arxiv.org/abs/1609.04802

GAN + 可變性 AutoEncoder 混合:https://github.com/junyanz/iGAN

向 GAN 添加一個(gè)編碼器以重建樣本:https://phillipi.github.io/pix2pix/

圖像到圖像的翻譯:https://ishmaelbelghazi.github.io/ALI/

交互式圖像生成:https://arxiv.org/abs/1512.09300

使用 GAN 增加圖像質(zhì)量:https://bamos.github.io/2016/08/09/deep-completion/

將鞋子變成等價(jià)的包(DiscoGAN):http://web.mit.edu/vondrick/tinyvideo/

更廣泛的研究列表,請(qǐng)查看此鏈接:https://github.com/zhangqianhui/AdversarialNetsPapers。

此外,在這個(gè) repo(https://github.com/wiseodd/generative-models)中,你會(huì)發(fā)現(xiàn) Tensorflow 和 Torch 中的各種 GAN 實(shí)現(xiàn)。

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4514.html

摘要:生成對(duì)抗網(wǎng)絡(luò)的各種變體非常多,的發(fā)明者在上推薦了這份名為的各種變體列表,這也表明現(xiàn)在確實(shí)非常火,被應(yīng)用于各種各樣的任務(wù)。了解這些各種各樣的,或許能對(duì)你創(chuàng)造自己的有所啟發(fā)。這篇文章列舉了目前出現(xiàn)的各種變體,并將長期更新。 生成對(duì)抗網(wǎng)絡(luò)(GAN)的各種變體非常多,GAN 的發(fā)明者 Ian Goodfellow 在Twitter上推薦了這份名為The GAN Zoo的各種GAN變體列表,這也表明現(xiàn)...

摘要:論文可遷移性對(duì)抗樣本空間摘要對(duì)抗樣本是在正常的輸入樣本中故意添加細(xì)微的干擾,旨在測(cè)試時(shí)誤導(dǎo)機(jī)器學(xué)習(xí)模型。這種現(xiàn)象使得研究人員能夠利用對(duì)抗樣本攻擊部署的機(jī)器學(xué)習(xí)系統(tǒng)。 現(xiàn)在,卷積神經(jīng)網(wǎng)絡(luò)(CNN)識(shí)別圖像的能力已經(jīng)到了出神入化的地步,你可能知道在 ImageNet 競(jìng)賽中,神經(jīng)網(wǎng)絡(luò)對(duì)圖像識(shí)別的準(zhǔn)確率已經(jīng)超過了人。但同時(shí),另一種奇怪的情況也在發(fā)生。拿一張計(jì)算機(jī)已經(jīng)識(shí)別得比較準(zhǔn)確的圖像,稍作調(diào)整,...

摘要:二是精度查全率和得分,用來衡量判別式模型的質(zhì)量。精度查全率和團(tuán)隊(duì)還用他們的三角形數(shù)據(jù)集,測(cè)試了樣本量為時(shí),大范圍搜索超參數(shù)來進(jìn)行計(jì)算的精度和查全率。 從2014年誕生至今,生成對(duì)抗網(wǎng)絡(luò)(GAN)熱度只增不減,各種各樣的變體層出不窮。有位名叫Avinash Hindupur的國際友人建立了一個(gè)GAN Zoo,他的動(dòng)物園里目前已經(jīng)收集了多達(dá)214種有名有姓的GAN。DeepMind研究員們甚至將...

摘要:近日,英國小哥在上圖解了一系列生成式對(duì)抗網(wǎng)和變分自編碼器的實(shí)現(xiàn)。 近日,英國小哥Pawel.io在GitHub上圖解了一系列生成式對(duì)抗網(wǎng)(GAN)和變分自編碼器(VAE)的TensorFlow實(shí)現(xiàn)。生成式對(duì)抗網(wǎng)絡(luò)(GAN)GAN論文地址:https://arxiv.org/abs/1406.2661價(jià)值函數(shù):結(jié)構(gòu)圖:LSGAN論文地址:https://arxiv.org/abs/1611.0...

摘要:近日,谷歌大腦發(fā)布了一篇全面梳理的論文,該研究從損失函數(shù)對(duì)抗架構(gòu)正則化歸一化和度量方法等幾大方向整理生成對(duì)抗網(wǎng)絡(luò)的特性與變體。他們首先定義了全景圖損失函數(shù)歸一化和正則化方案,以及最常用架構(gòu)的集合。 近日,谷歌大腦發(fā)布了一篇全面梳理 GAN 的論文,該研究從損失函數(shù)、對(duì)抗架構(gòu)、正則化、歸一化和度量方法等幾大方向整理生成對(duì)抗網(wǎng)絡(luò)的特性與變體。作者們復(fù)現(xiàn)了當(dāng)前較佳的模型并公平地對(duì)比與探索 GAN ...

閱讀 2933·2023-04-26 02:22

閱讀 2291·2021-11-17 09:33

閱讀 3138·2021-09-22 16:06

閱讀 1078·2021-09-22 15:54

閱讀 3539·2019-08-29 13:44

閱讀 1917·2019-08-29 12:37

閱讀 1323·2019-08-26 14:04

閱讀 1917·2019-08-26 11:57