資訊專欄INFORMATION COLUMN

摘要:一段時(shí)間以來(lái),我一直在嘗試使用生成神經(jīng)網(wǎng)絡(luò)制作人物肖像。生成圖像的質(zhì)量與低分辨率輸出實(shí)現(xiàn)密切相關(guān)。在第一階段,根據(jù)給定描述生成相對(duì)原始的形狀和基本的色彩,得出低分辨圖像。使用生成的圖像比現(xiàn)有方法更加合理逼真。

一段時(shí)間以來(lái),我一直在嘗試使用生成神經(jīng)網(wǎng)絡(luò)制作人物肖像。早期試驗(yàn)基于類似 Deep Dream 的方法,但最近我開(kāi)始將精力集中在 GAN 上面。當(dāng)然,無(wú)論在什么時(shí)候,高精度和較精確的細(xì)節(jié)都是很難實(shí)現(xiàn)的,使用 GAN 生成人臉也一樣。首先,這些網(wǎng)絡(luò)的感受野往往不到 256×256 像素的大小。

解決這個(gè)問(wèn)題的一種辦法是使用 stack GAN。我用基于 stack GAN 的方法,終于將像素提升到 768×768 的大小,最多使用 3 個(gè)階段 stack 將像素提升到了 4k×4k。我不在意結(jié)果是否真實(shí),但細(xì)節(jié)紋理逼真很重要。

為了減少 artifact(模糊不清的地方),我需要應(yīng)對(duì) mode collapse 等各種問(wèn)題。具體說(shuō),光滑皮膚和多毛皮膚之間,第二階段 GAN 是 meta stable,往往導(dǎo)致輸出變成一塊一塊的。

現(xiàn)在我使用的最多是 vanilla GAN。當(dāng)然,我覺(jué)得我也該試一下 WGAN、CramerGAN 或 BEGAN,因?yàn)榇蠹叶颊f(shuō)后面幾種收斂更好。

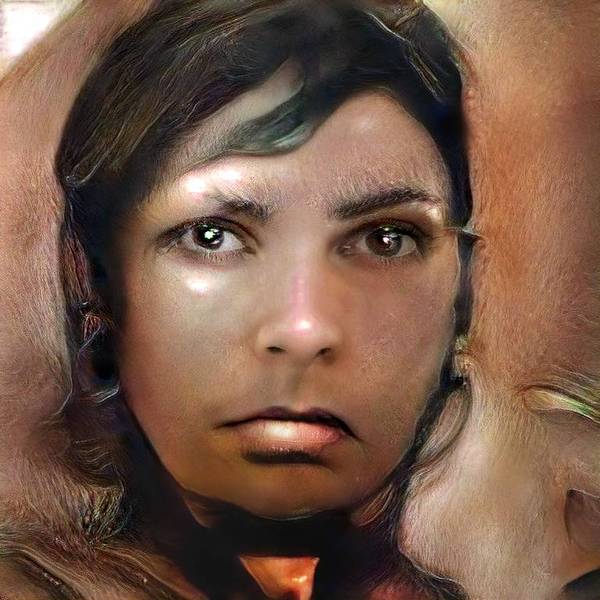

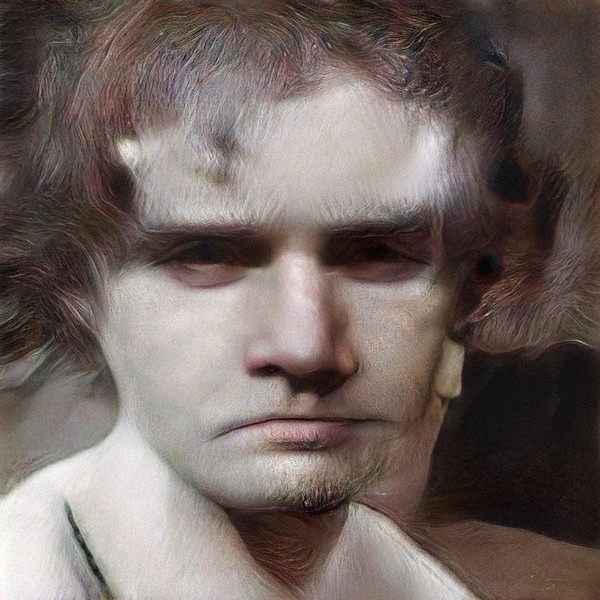

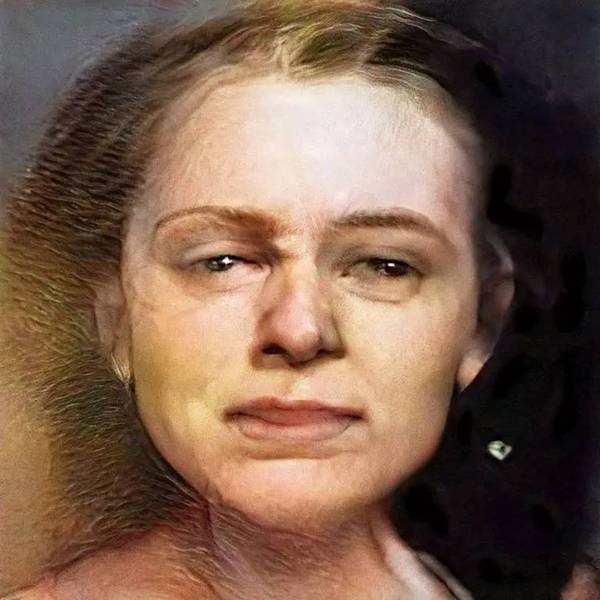

下面就是我使用 GAN 生成的空想人物肖像(我選了效果比較好的放上來(lái))。

生成圖像的質(zhì)量與低分辨率輸出(lowres output)實(shí)現(xiàn)密切相關(guān)。我通常在第一階段生成 128×128 或者 256×256 像素的結(jié)果,然后在第二階段提升至 768×768 或者 1024×1024。大多數(shù)情況下,生成的結(jié)果都很糟糕,遠(yuǎn)遠(yuǎn)沒(méi)有我挑選出來(lái)的這幾張好,但有些時(shí)候會(huì)出現(xiàn)非常富有藝術(shù)性的圖像,偶爾看上去還像是有藝術(shù)風(fēng)格誕生。

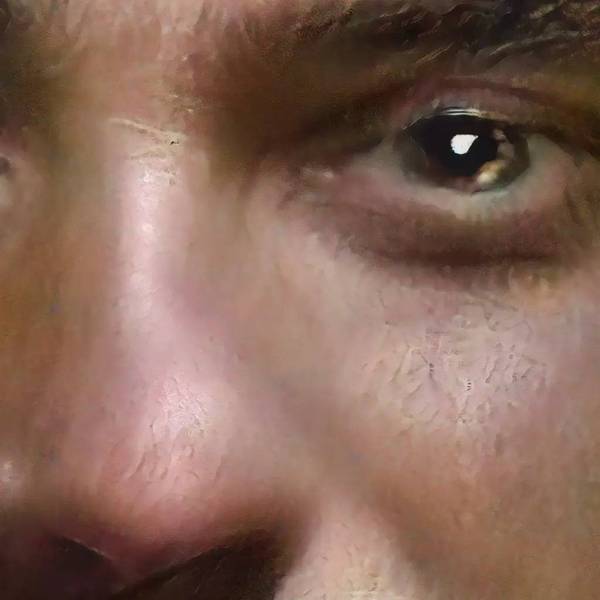

我在最后的第三階段將像素提升到 4k。但是,實(shí)際上我并沒(méi)有這個(gè)像素級(jí)別的訓(xùn)練數(shù)據(jù),也就是說(shuō),網(wǎng)絡(luò)做的只是大致預(yù)測(cè)邊緣是否平滑等等。

系統(tǒng)不可能知道皮膚高分辨率的人臉數(shù)據(jù)庫(kù)。毛孔或睫毛這些細(xì)節(jié)。因此,我們需要一個(gè)與高分辨率的人臉數(shù)據(jù)庫(kù)。

考慮到最終的印刷效果,在這種分辨率下故意保留一些 artifact 可能還不錯(cuò)(相比 )。

Mike Tyka 參考了下面這篇論文中所提到的方法 Stack-GAN,并且在論文基礎(chǔ)上做了 3 次堆疊。有興趣你也可以一試:)

摘要

根據(jù)文本描述合成逼真圖像是計(jì)算機(jī)視覺(jué)一大挑戰(zhàn),也有很多應(yīng)用。使用現(xiàn)有方法合成的圖像在細(xì)節(jié)和生動(dòng)方面差強(qiáng)人意。本文中,我們提出 StakeGAN 方法,根據(jù)文本描述生成逼真的圖像。在第一階段(Stage-I GAN),GAN 根據(jù)給定描述生成相對(duì)原始的形狀和基本的色彩,得出 Stage-I 低分辨圖像。Stage-II GAN 將 Stage-I GAN 和文本描述作為輸入,生成高分辨率的逼真圖像。Stage-II GAN 能夠修正錯(cuò)誤,增加令人信服的效果和細(xì)節(jié)。使用 StackGAN 生成的圖像比現(xiàn)有方法更加合理逼真。最重要的是,StackGAN 根據(jù)文本第一次生成 256×256 像素的圖像,現(xiàn)有方法最多只能生成 128×128 像素的圖像。

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4568.html

摘要:據(jù)報(bào)道,生成對(duì)抗網(wǎng)絡(luò)的創(chuàng)造者,前谷歌大腦著名科學(xué)家剛剛正式宣布加盟蘋(píng)果。他將在蘋(píng)果公司領(lǐng)導(dǎo)一個(gè)機(jī)器學(xué)習(xí)特殊項(xiàng)目組。在加盟蘋(píng)果后會(huì)帶來(lái)哪些新的技術(shù)突破或許我們很快就會(huì)看到了。 據(jù) CNBC 報(bào)道,生成對(duì)抗網(wǎng)絡(luò)(GAN)的創(chuàng)造者,前谷歌大腦著名科學(xué)家 Ian Goodfellow 剛剛正式宣布加盟蘋(píng)果。他將在蘋(píng)果公司領(lǐng)導(dǎo)一個(gè)「機(jī)器學(xué)習(xí)特殊項(xiàng)目組」。雖然蘋(píng)果此前已經(jīng)縮小了自動(dòng)駕駛汽車研究的規(guī)模,但...

摘要:文本谷歌神經(jīng)機(jī)器翻譯去年,谷歌宣布上線的新模型,并詳細(xì)介紹了所使用的網(wǎng)絡(luò)架構(gòu)循環(huán)神經(jīng)網(wǎng)絡(luò)。目前唇讀的準(zhǔn)確度已經(jīng)超過(guò)了人類。在該技術(shù)的發(fā)展過(guò)程中,谷歌還給出了新的,它包含了大量的復(fù)雜案例。谷歌收集該數(shù)據(jù)集的目的是教神經(jīng)網(wǎng)絡(luò)畫(huà)畫(huà)。 1. 文本1.1 谷歌神經(jīng)機(jī)器翻譯去年,谷歌宣布上線 Google Translate 的新模型,并詳細(xì)介紹了所使用的網(wǎng)絡(luò)架構(gòu)——循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)。關(guān)鍵結(jié)果:與...

閱讀 3807·2021-09-23 11:32

閱讀 2472·2021-09-06 15:01

閱讀 1632·2021-08-18 10:24

閱讀 3470·2019-12-27 11:44

閱讀 3616·2019-08-30 15:52

閱讀 2524·2019-08-30 11:11

閱讀 699·2019-08-29 17:27

閱讀 610·2019-08-29 16:22