資訊專欄INFORMATION COLUMN

摘要:本論文研究只有遺忘門的話會(huì)怎樣,并提出了,實(shí)驗(yàn)表明該模型的性能優(yōu)于標(biāo)準(zhǔn)。這里我們發(fā)現(xiàn),一個(gè)只有遺忘門且?guī)в衅庙?xiàng)的版本不僅能節(jié)省計(jì)算成本,而且在多個(gè)基準(zhǔn)數(shù)據(jù)集上的性能優(yōu)于標(biāo)準(zhǔn),能與一些當(dāng)下較好的模型競(jìng)爭(zhēng)。

本論文研究 LSTM 只有遺忘門的話會(huì)怎樣,并提出了 JANET,實(shí)驗(yàn)表明該模型的性能優(yōu)于標(biāo)準(zhǔn) LSTM。

1.介紹

優(yōu)秀的工程師確保其設(shè)計(jì)是實(shí)用的。目前我們已經(jīng)知道解決序列分析問題較好的方式是長(zhǎng)短期記憶(LSTM)循環(huán)神經(jīng)網(wǎng)絡(luò),接下來我們需要設(shè)計(jì)一個(gè)滿足資源受限的現(xiàn)實(shí)世界應(yīng)用的實(shí)現(xiàn)。鑒于使用兩個(gè)門的門控循環(huán)單元(Cho 等,2014)的成功,第一種設(shè)計(jì)更硬件高效的 LSTM 的方法可能是消除冗余門(redundant gate)。因?yàn)槲覀円獙で蟊?GRU 更高效的模型,所以只有單門 LSTM 模型值得我們研究。為了說明為什么這個(gè)單門應(yīng)該是遺忘門,讓我們從 LSTM 的起源講起。

在那個(gè)訓(xùn)練循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)十分困難的年代,Hochreiter 和 Schmidhuber(1997)認(rèn)為在 RNN 中使用單一權(quán)重(邊)來控制是否接受記憶單元的輸入或輸出帶來了沖突性更新(梯度)。本質(zhì)上來講,每一步中長(zhǎng)短期誤差(long and short-range error)作用于相同的權(quán)重,且如果使用 sigmoid 激活函數(shù)的話,梯度消失的速度要比權(quán)重增加速度快。之后他們提出長(zhǎng)短期記憶(LSTM)單元循環(huán)神經(jīng)網(wǎng)絡(luò),具備乘法輸入門和輸出門。這些門可以通過「保護(hù)」單元免受不相關(guān)信息(其他單元的輸入或輸出)影響,從而緩解沖突性更新問題。

LSTM 的第一個(gè)版本只有兩個(gè)門:Gers 等人(2000)首先發(fā)現(xiàn)如果沒有使記憶單元遺忘信息的機(jī)制,那么它們可能會(huì)無(wú)限增長(zhǎng),最終導(dǎo)致網(wǎng)絡(luò)崩潰。為解決這個(gè)問題,他們?yōu)檫@個(gè) LSTM 架構(gòu)加上了另一個(gè)乘法門,即遺忘門,完成了我們今天看到的 LSTM 版本。

?

鑒于遺忘門發(fā)現(xiàn)的重要性,那么設(shè)想 LSTM 僅使用一個(gè)遺忘門,輸入和輸出門是否必要呢?本研究將探索多帶帶使用遺忘門的優(yōu)勢(shì)。在五個(gè)任務(wù)中,僅使用遺忘門的模型提供了比使用全部三個(gè) LSTM 門的模型更好的解決方案。

3 JUST ANOTHER NETWORK

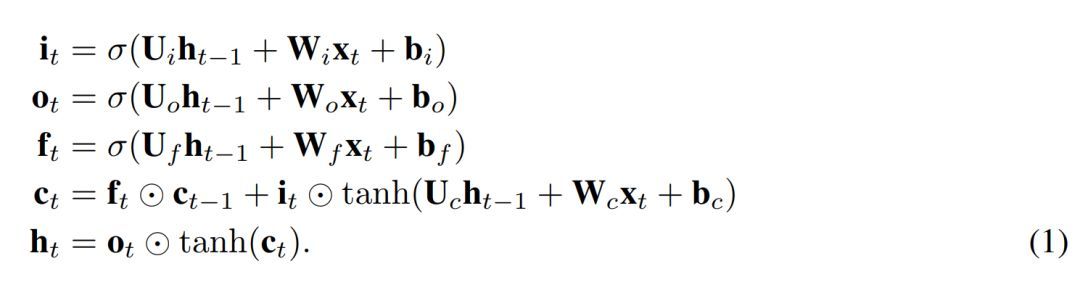

我們提出了一個(gè)簡(jiǎn)單的 LSTM 變體,其只有一個(gè)遺忘門。它是 Just Another NETwork,因此我們將其命名為 JANET。我們從標(biāo)準(zhǔn) LSTM(Lipton 等,2015)開始,其中符號(hào)具備標(biāo)準(zhǔn)含義,定義如下

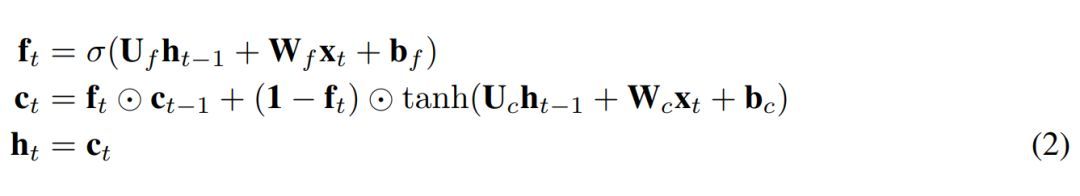

為了將上述內(nèi)容轉(zhuǎn)換成 JANET 架構(gòu),我們刪除了輸入和輸出門。將信息的累積和刪除關(guān)聯(lián)起來似乎是明智的,因此我們將輸入和遺忘調(diào)制結(jié)合起來,就像 Greff et al. (2015) 論文中所做的那樣,而這與 leaky unit 實(shí)現(xiàn) (Jaeger, 2002, §8.1) 類似。此外,h_t 的 tanh 激活函數(shù)使梯度在反向傳播期間出現(xiàn)收縮,這可能加劇梯度消失問題。權(quán)重 U? 可容納 [-1,1] 區(qū)間外的值,因此我們可移除這個(gè)不必要且可能帶來問題的 tanh 非線性函數(shù)。得出的 JANET 結(jié)果如下:

4 實(shí)驗(yàn)與結(jié)果

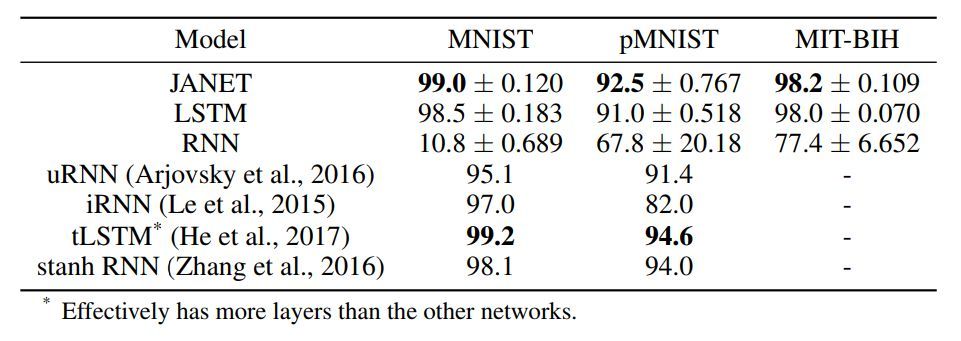

表 1:不同循環(huán)神經(jīng)網(wǎng)絡(luò)架構(gòu)的準(zhǔn)確率 [%]。圖中展示了 10 次獨(dú)立運(yùn)行得到的平均值和標(biāo)準(zhǔn)差。我們實(shí)驗(yàn)中的較佳準(zhǔn)確率結(jié)果以及引用論文中的較佳結(jié)果以粗體顯示。

令人驚訝的是,結(jié)果表明 JANET 比標(biāo)準(zhǔn) LSTM 的準(zhǔn)確率更高。此外,JANET 是在所有分析數(shù)據(jù)集上表現(xiàn)較佳的模型之一。因此,通過簡(jiǎn)化 LSTM,我們不僅節(jié)省了計(jì)算成本,還提高了測(cè)試集上的準(zhǔn)確率!

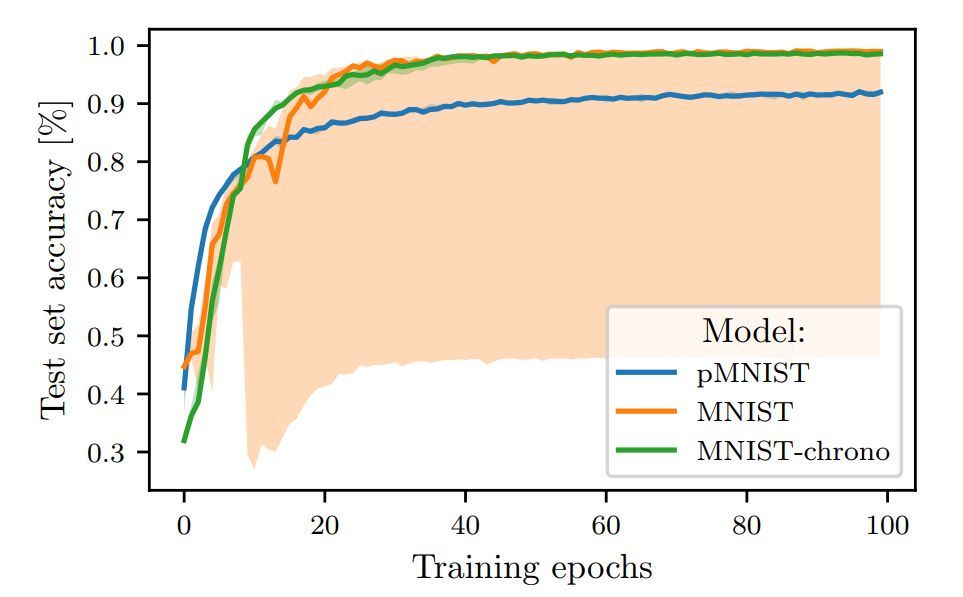

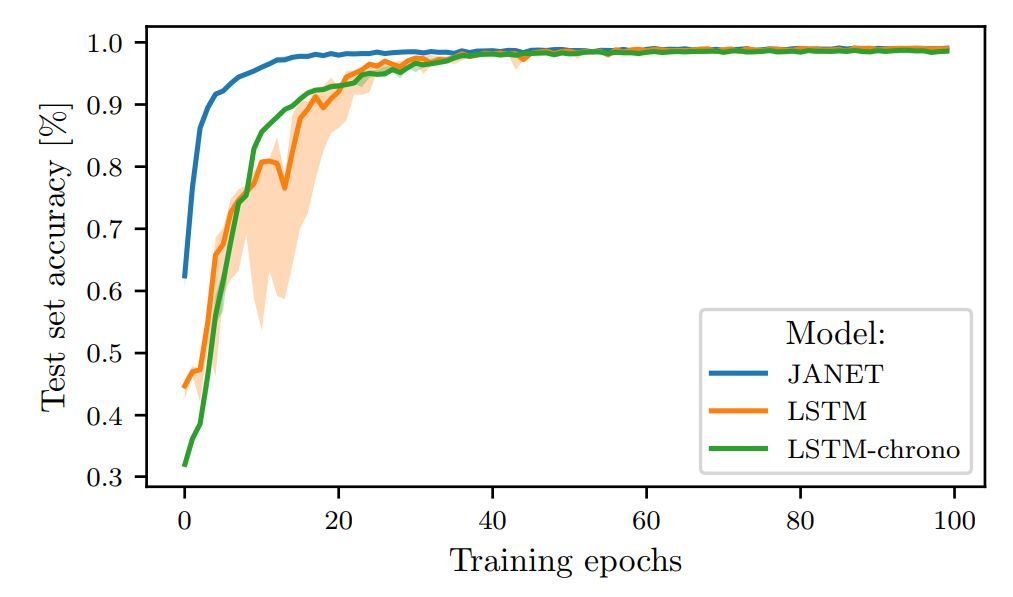

圖 1:在 MNIST 和 pMNIST 上訓(xùn)練的 LSTM 的測(cè)試準(zhǔn)確率。

圖 2:JANET 和 LSTM 在 MNIST 上訓(xùn)練時(shí)的測(cè)試集準(zhǔn)確率對(duì)比。

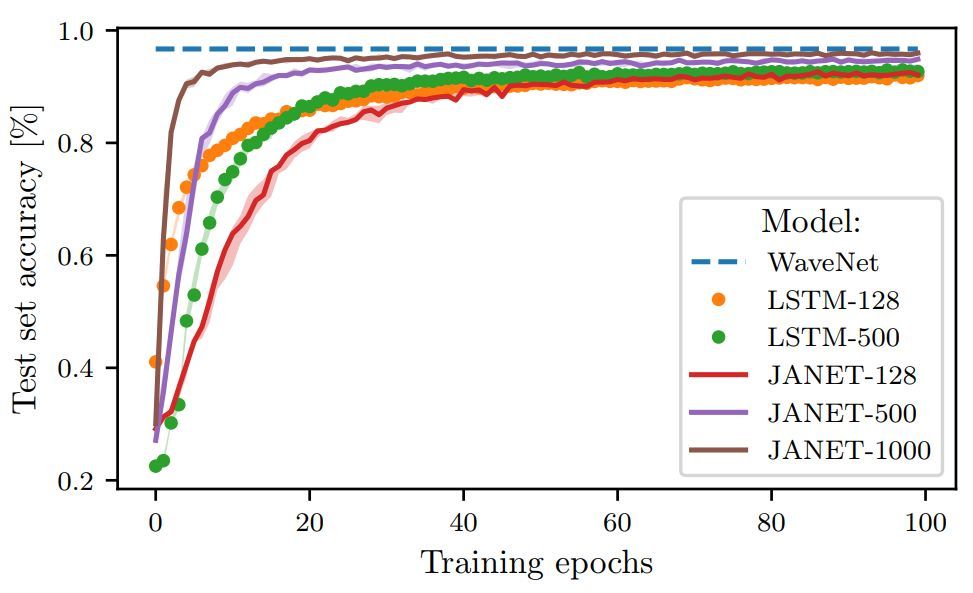

圖 3:不同層大小的 JANET 和 LSTM 在 pMNIST 數(shù)據(jù)集上的準(zhǔn)確率(%)。

論文:THE UNREASONABLE EFFECTIVENESS OF THE FORGET GATE

論文鏈接:https://arxiv.org/abs/1804.04849

摘要:鑒于門控循環(huán)單元(GRU)的成功,一個(gè)很自然的問題是長(zhǎng)短期記憶(LSTM)網(wǎng)絡(luò)中的所有門是否是必要的。之前的研究表明,遺忘門是 LSTM 中最重要的門之一。這里我們發(fā)現(xiàn),一個(gè)只有遺忘門且?guī)в?chrono-initialized 偏置項(xiàng)的 LSTM 版本不僅能節(jié)省計(jì)算成本,而且在多個(gè)基準(zhǔn)數(shù)據(jù)集上的性能優(yōu)于標(biāo)準(zhǔn) LSTM,能與一些當(dāng)下較好的模型競(jìng)爭(zhēng)。我們提出的網(wǎng)絡(luò) JANET,在 MNIST 和 pMNIST 數(shù)據(jù)集上分別達(dá)到了 99% 和 92.5% 的準(zhǔn)確率,優(yōu)于標(biāo)準(zhǔn) LSTM 98.5% 和 91% 的準(zhǔn)確率。

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4765.html

摘要:作為解決方案的和和是解決短時(shí)記憶問題的解決方案,它們具有稱為門的內(nèi)部機(jī)制,可以調(diào)節(jié)信息流。隨后,它可以沿著長(zhǎng)鏈序列傳遞相關(guān)信息以進(jìn)行預(yù)測(cè),幾乎所有基于遞歸神經(jīng)網(wǎng)絡(luò)的技術(shù)成果都是通過這兩個(gè)網(wǎng)絡(luò)實(shí)現(xiàn)的。和采用門結(jié)構(gòu)來克服短時(shí)記憶的影響。 短時(shí)記憶RNN 會(huì)受到短時(shí)記憶的影響。如果一條序列足夠長(zhǎng),那它們將很難將信息從較早的時(shí)間步傳送到后面的時(shí)間步。 因此,如果你正在嘗試處理一段文本進(jìn)行預(yù)測(cè),RNN...

摘要:前饋網(wǎng)絡(luò)的反向傳播從最后的誤差開始,經(jīng)每個(gè)隱藏層的輸出權(quán)重和輸入反向移動(dòng),將一定比例的誤差分配給每個(gè)權(quán)重,方法是計(jì)算權(quán)重與誤差的偏導(dǎo)數(shù),即兩者變化速度的比例。隨后,梯度下降的學(xué)習(xí)算法會(huì)用這些偏導(dǎo)數(shù)對(duì)權(quán)重進(jìn)行上下調(diào)整以減少誤差。 目錄前饋網(wǎng)絡(luò)遞歸網(wǎng)絡(luò)沿時(shí)間反向傳播梯度消失與梯度膨脹長(zhǎng)短期記憶單元(LSTM)涵蓋多種時(shí)間尺度本文旨在幫助神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)者了解遞歸網(wǎng)絡(luò)的運(yùn)作方式,以及一種主要的遞歸網(wǎng)絡(luò)...

摘要:得到的結(jié)果如下上圖是門卷積神經(jīng)網(wǎng)絡(luò)模型與和模型在數(shù)據(jù)集基準(zhǔn)上進(jìn)行測(cè)試的結(jié)果。雖然在這一研究中卷積神經(jīng)網(wǎng)絡(luò)在性能上表現(xiàn)出了對(duì)遞歸神經(jīng)網(wǎng)絡(luò),尤其是的全面超越,但是,現(xiàn)在談取代還為時(shí)尚早。 語(yǔ)言模型對(duì)于語(yǔ)音識(shí)別系統(tǒng)來說,是一個(gè)關(guān)鍵的組成部分,在機(jī)器翻譯中也是如此。近年來,神經(jīng)網(wǎng)絡(luò)模型被認(rèn)為在性能上要優(yōu)于經(jīng)典的 n-gram 語(yǔ)言模型。經(jīng)典的語(yǔ)言模型會(huì)面臨數(shù)據(jù)稀疏的難題,使得模型很難表征大型的文本,...

閱讀 2478·2021-11-22 15:35

閱讀 3770·2021-11-04 16:14

閱讀 2698·2021-10-20 13:47

閱讀 2509·2021-10-13 09:49

閱讀 2078·2019-08-30 14:09

閱讀 2380·2019-08-26 13:49

閱讀 889·2019-08-26 10:45

閱讀 2780·2019-08-23 17:54