資訊專欄INFORMATION COLUMN

摘要:反向傳播算法算法是目前用來訓(xùn)練人工神經(jīng)網(wǎng)絡(luò)的最常用且最有效的算法。作為谷歌機(jī)器學(xué)習(xí)速成課程的配套材料,谷歌推出一個(gè)演示網(wǎng)站,直觀地介紹了反向傳播算法的工作原理。網(wǎng)站地址反向傳播算法對(duì)于快速訓(xùn)練大型神經(jīng)網(wǎng)絡(luò)來說至關(guān)重要。

反向傳播算法(BP算法)是目前用來訓(xùn)練人工神經(jīng)網(wǎng)絡(luò)的最常用且最有效的算法。作為谷歌機(jī)器學(xué)習(xí)速成課程的配套材料,谷歌推出一個(gè)演示網(wǎng)站,直觀地介紹了反向傳播算法的工作原理。網(wǎng)站地址:

https://google-developers.appspot.com/machine-learning/crash-course/backprop-scroll/

反向傳播算法對(duì)于快速訓(xùn)練大型神經(jīng)網(wǎng)絡(luò)來說至關(guān)重要。本文將介紹該算法的工作原理。

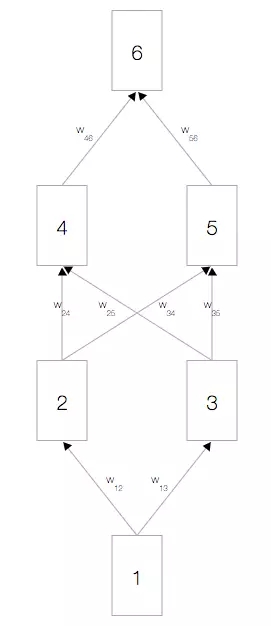

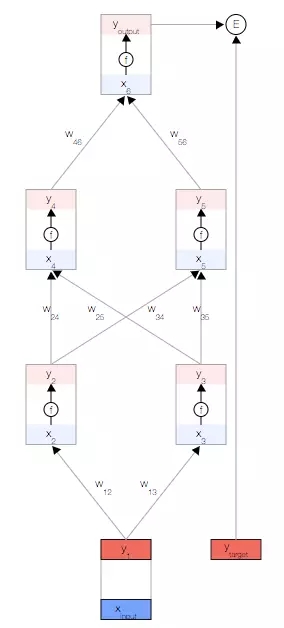

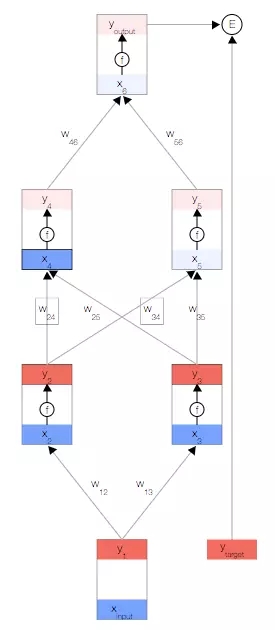

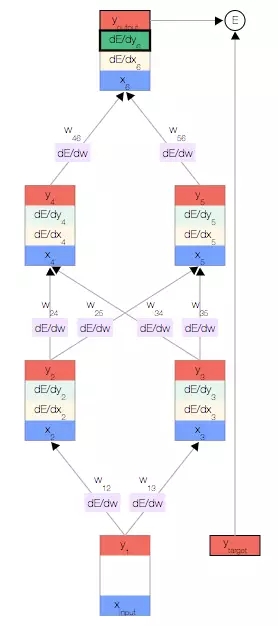

簡單的神經(jīng)網(wǎng)絡(luò)

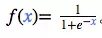

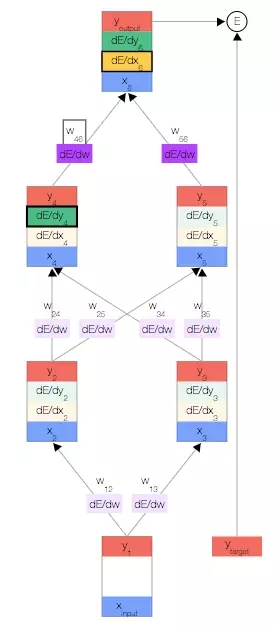

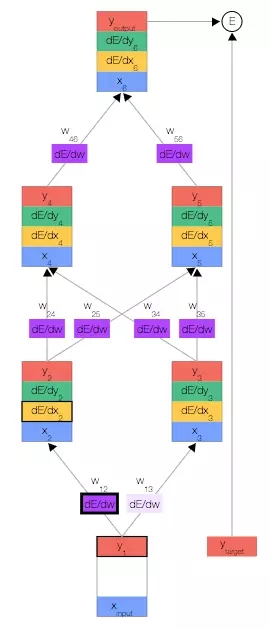

如上圖,你會(huì)看到一個(gè)神經(jīng)網(wǎng)絡(luò),其中包含一個(gè)輸入節(jié)點(diǎn)、一個(gè)輸出節(jié)點(diǎn),以及兩個(gè)隱藏層(分別有兩個(gè)節(jié)點(diǎn))。?

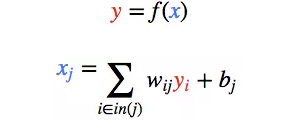

激活函數(shù)

每個(gè)節(jié)點(diǎn)都有一個(gè)總輸入 x、一個(gè)激活函數(shù) f(x) 以及一個(gè)輸出 y=f(x)。?

f(x)必須是非線性函數(shù),否則神經(jīng)網(wǎng)絡(luò)就只能學(xué)習(xí)線性模型。?

常用的激活函數(shù)是 S 型函數(shù):

誤差函數(shù)

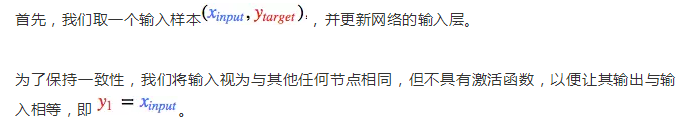

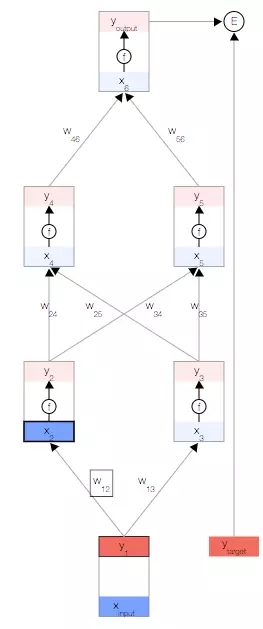

正向傳播

現(xiàn)在,我們更新第一個(gè)隱藏層。我們?nèi)∩弦粚庸?jié)點(diǎn)的輸出 y,并使用權(quán)重來計(jì)算下一層節(jié)點(diǎn)的輸入 x。

然后,我們更新第一個(gè)隱藏層中節(jié)點(diǎn)的輸出。 為此,我們使用激活函數(shù) f(x)。

使用這兩個(gè)公式,我們可以傳播到網(wǎng)絡(luò)的其余內(nèi)容,并獲得網(wǎng)絡(luò)的最終輸出。

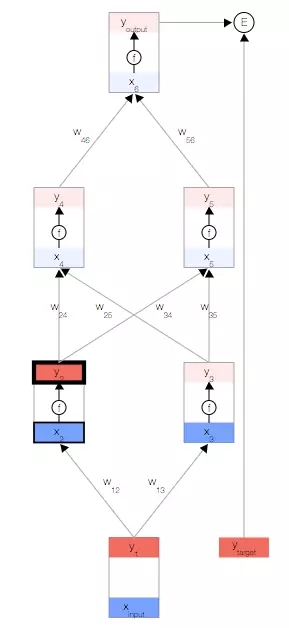

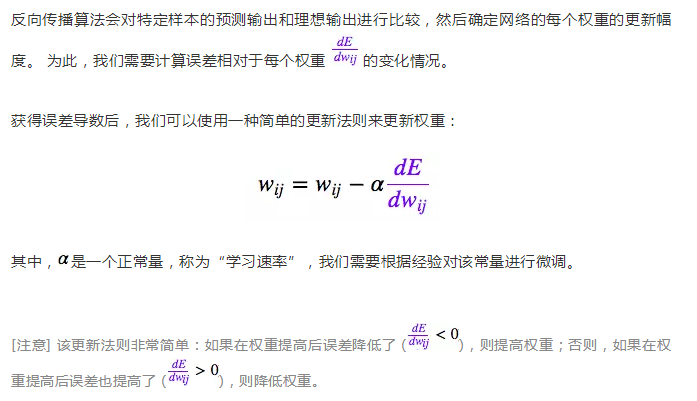

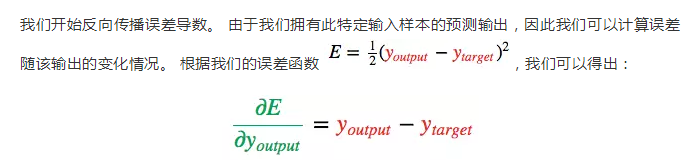

誤差導(dǎo)數(shù)

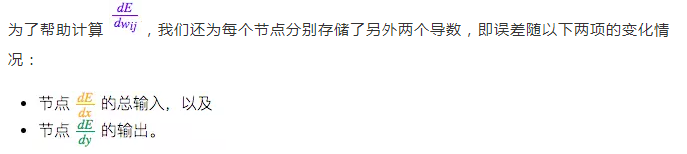

其他導(dǎo)數(shù)

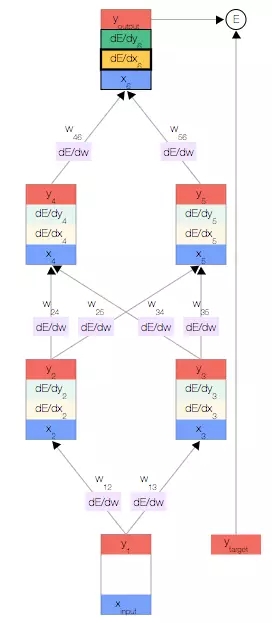

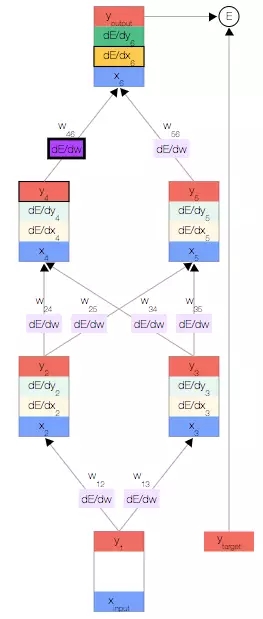

反向傳播

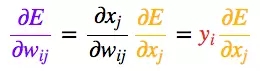

一旦得出相對(duì)于某節(jié)點(diǎn)的總輸入的誤差導(dǎo)數(shù),我們便可以得出相對(duì)于進(jìn)入該節(jié)點(diǎn)的權(quán)重的誤差導(dǎo)數(shù)。

接下來,只需重復(fù)前面的 3 個(gè)公式,直到計(jì)算出所有誤差導(dǎo)數(shù)即可。

結(jié)束。

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請(qǐng)聯(lián)系小編及時(shí)處理,謝謝!

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4795.html

摘要:在最近的一次人工智能會(huì)議上,表示自己對(duì)于反向傳播非常懷疑,并提出應(yīng)該拋棄它并重新開始。在人工智能多年的發(fā)展過程中,反向傳播已經(jīng)成為了深度學(xué)習(xí)不可或缺的一部分。最后,我們會(huì)將這些規(guī)則組合成可用于任意神經(jīng)網(wǎng)絡(luò)的反向傳播算法。 現(xiàn)在的深度學(xué)習(xí)發(fā)展似乎已經(jīng)陷入了大型化、深度化的怪圈,我們?cè)O(shè)計(jì)的模型容易被對(duì)抗樣本欺騙,同時(shí)又需要大量的訓(xùn)練數(shù)據(jù)——在無監(jiān)督學(xué)習(xí)上我們?nèi)〉玫耐黄七€很少。作為反向傳播這一深度...

摘要:深度學(xué)習(xí)在過去的幾年里取得了許多驚人的成果,均與息息相關(guān)。機(jī)器學(xué)習(xí)進(jìn)階筆記之一安裝與入門是基于進(jìn)行研發(fā)的第二代人工智能學(xué)習(xí)系統(tǒng),被廣泛用于語音識(shí)別或圖像識(shí)別等多項(xiàng)機(jī)器深度學(xué)習(xí)領(lǐng)域。零基礎(chǔ)入門深度學(xué)習(xí)長短時(shí)記憶網(wǎng)絡(luò)。 多圖|入門必看:萬字長文帶你輕松了解LSTM全貌 作者 | Edwin Chen編譯 | AI100第一次接觸長短期記憶神經(jīng)網(wǎng)絡(luò)(LSTM)時(shí),我驚呆了。原來,LSTM是神...

閱讀 819·2021-11-22 15:25

閱讀 1419·2021-09-08 09:45

閱讀 1704·2021-09-02 09:46

閱讀 1308·2019-08-30 15:56

閱讀 1540·2019-08-29 15:14

閱讀 1166·2019-08-29 13:06

閱讀 2019·2019-08-29 12:34

閱讀 1408·2019-08-26 12:14