資訊專欄INFORMATION COLUMN

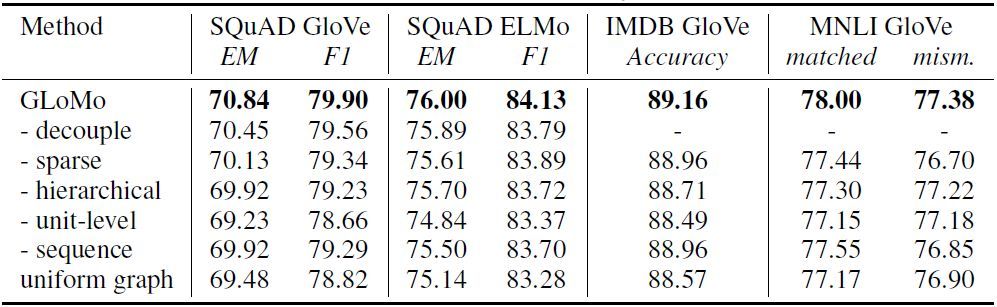

摘要:研究人員稱,其提出的可以無監(jiān)督地學(xué)習(xí)并遷移數(shù)據(jù)單元對之間的依賴關(guān)系和圖形表征,并在自然語言處理和計(jì)算機(jī)視覺任務(wù)中取得了很好的效果。表自然語言處理任務(wù)中的模型簡化測試。

近日,由卡耐基梅隆大學(xué)、紐約大學(xué)和 Facebook 的研究者楊植麟、Junbo Zhao 等人提交的論文將遷移學(xué)習(xí)向前推進(jìn)了一步。研究人員稱,其提出的 GLoMo 可以無監(jiān)督地學(xué)習(xí)并遷移數(shù)據(jù)單元對之間的依賴關(guān)系和圖形表征,并在自然語言處理和計(jì)算機(jī)視覺任務(wù)中取得了很好的效果。值得一提的是,該論文作者還包括何愷明、Ruslan Salakhutdinov 和 Yann LeCun 等人。

深度學(xué)習(xí)的進(jìn)展很大程度上依賴于諸如卷積網(wǎng)絡(luò)(CNN)[ 18 ] 和循環(huán)網(wǎng)絡(luò)(RNN)[ 14 ] 之類的架構(gòu)及注意力機(jī)制 [ 1 ]。這些架構(gòu)雖然具有較高的表征能力,但由于其內(nèi)置的「先天優(yōu)勢」,它們主要在網(wǎng)格狀或順序結(jié)構(gòu)上運(yùn)行。因此,CNN 和 RNN 在很大程度上依賴高表達(dá)能力來模擬復(fù)雜的結(jié)構(gòu)現(xiàn)象,抵消了它們沒有明確利用結(jié)構(gòu)和圖形表征的事實(shí)。

這種范式導(dǎo)致了遷移學(xué)習(xí)和預(yù)處理的標(biāo)準(zhǔn)化規(guī)范——在有監(jiān)督或無監(jiān)督的大數(shù)據(jù)集上擬合表達(dá)函數(shù),然后將該函數(shù)應(yīng)用到下游任務(wù)數(shù)據(jù)中進(jìn)行特征提取。值得重視的例子包括預(yù)處理的 ImageNet 特征 [ 13 ] 和預(yù)處理的單詞嵌入 [ 23,28 ]。

相比之下,現(xiàn)實(shí)世界中的各種數(shù)據(jù)顯示出比簡單的網(wǎng)格狀或順序結(jié)構(gòu)更豐富的關(guān)系圖結(jié)構(gòu)。最近的其他類似研究也強(qiáng)調(diào)了這一點(diǎn) [3]。例如在語言領(lǐng)域,語言學(xué)家使用解析樹來表示單詞之間的句法依賴性;信息檢索系統(tǒng)利用知識圖形反映實(shí)體關(guān)系;共指消解被設(shè)計(jì)成連接相同實(shí)體的不同表達(dá)式。因此,不管目標(biāo)任務(wù)如何,這些示例性結(jié)構(gòu)普遍存在于幾乎任何自然語言數(shù)據(jù)中,這意味著跨任務(wù)遷移的可能性。這些觀察也可以推廣到其他領(lǐng)域,如計(jì)算機(jī)視覺。在 CV 領(lǐng)域里,像素之間關(guān)系的建模被證明是有用的 [ 27,49,43 ]。然而,還存在一個(gè)障礙,許多通用結(jié)構(gòu)基本上是人為策劃的,并且大規(guī)模獲取成本高昂,而自動(dòng)誘發(fā)的結(jié)構(gòu)大多限于一項(xiàng)任務(wù)。

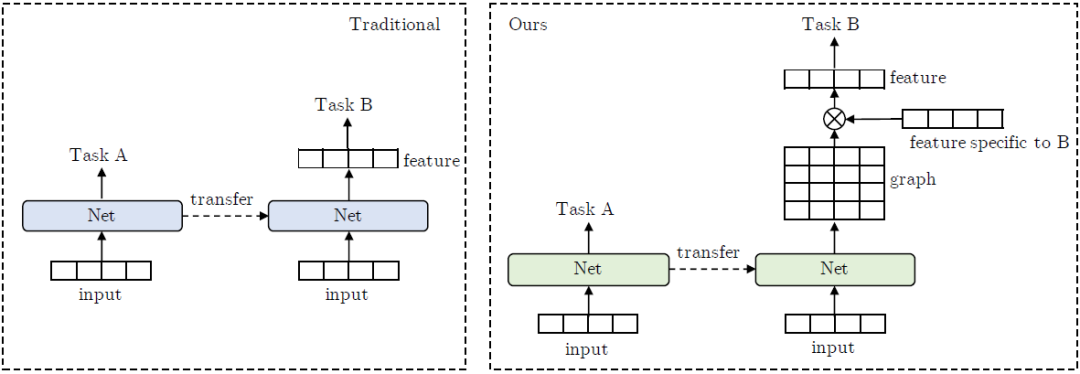

圖 1:傳統(tǒng)遷移學(xué)習(xí)與新遷移學(xué)習(xí)框架的對比。GLoMo 不是遷移特征,而是遷移網(wǎng)絡(luò)輸出的圖形。圖形與任務(wù)特定的特征(例如嵌入或隱藏狀態(tài))相乘,以產(chǎn)生結(jié)構(gòu)感知特征。

在本文中,我們試圖解決兩個(gè)挑戰(zhàn): 1)打破基于特征的深度遷移學(xué)習(xí)的標(biāo)準(zhǔn)化規(guī)范;2)以數(shù)據(jù)驅(qū)動(dòng)的方式學(xué)習(xí)數(shù)據(jù)中的通用結(jié)構(gòu)。我們對學(xué)習(xí)可遷移隱藏關(guān)系圖感興趣,其中隱藏圖的節(jié)點(diǎn)是輸入單元,例如句子中的所有單詞。隱藏關(guān)系圖學(xué)習(xí)的任務(wù)是學(xué)習(xí)一個(gè)相似矩陣,其中權(quán)重(可能為零)捕獲任意一對輸入單元之間的依賴關(guān)系。

為了實(shí)現(xiàn)上述目標(biāo),我們提出了一種新的無監(jiān)督隱藏圖學(xué)習(xí)框架,稱之為 GLoMo(Graphs from LOw-level unit MOdeling,低級單位建模圖)。具體來說,我們從大規(guī)模的未標(biāo)記數(shù)據(jù)中訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)來輸出隱藏圖型,并將該網(wǎng)絡(luò)遷移到提取下游任務(wù)的圖結(jié)構(gòu)來加強(qiáng)對它的訓(xùn)練。這種方法可以讓我們把表示每個(gè)單元語義含義的特征和反映單元如何交互的圖形分開。理想情況下,圖形捕捉數(shù)據(jù)背后的任務(wù)無關(guān)結(jié)構(gòu),從而適用于不同的功能集。圖 1 突出了傳統(tǒng)的基于特征的遷移學(xué)習(xí)和新框架之間的差異。

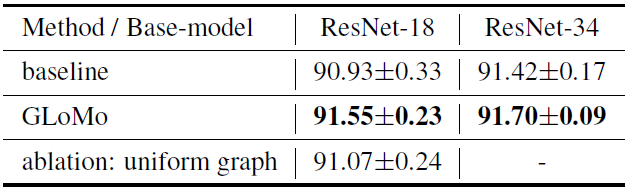

實(shí)驗(yàn)結(jié)果表明,GLoMo 提高了問答、自然語言推理和情感分析等各種語言任務(wù)的性能。我們還證實(shí),學(xué)習(xí)到的圖形是通用的,可以用于未經(jīng)過圖形訓(xùn)練的各種特征集任務(wù),包括 GloVe 嵌入 [28]、ELMo 嵌入 [ 29 ] 和任務(wù)特定的 RNN 狀態(tài)。我們還確定了學(xué)習(xí)成功通用圖的關(guān)鍵因素:解耦圖和特征、分層圖表征、稀疏性、單位級目標(biāo)和序列預(yù)測。為了證明該框架的通用性,我們應(yīng)用 GLoMo 來建模像素之間的關(guān)系依賴性,結(jié)果表明圖像分類任務(wù)的性能獲得改進(jìn)。

圖 2:GLoMo 方法概述。

在無監(jiān)督學(xué)習(xí)階段,特征預(yù)測器和圖形預(yù)測器被一起訓(xùn)練以執(zhí)行上下文預(yù)測。在遷移階段,圖形預(yù)測器被凍結(jié)并用于提取下游任務(wù)的圖形。RNN 解碼器應(yīng)用于特征預(yù)測器中的所有位置,但是簡單起見,我們僅指出了位置「A」處的一個(gè)。「Select one」表示圖形可以遷移到下游任務(wù)模型中的任何層。「FF」指前饋網(wǎng)絡(luò)。圖形預(yù)測器輸出的圖用作「weighted sum」操作中的權(quán)重(參見等式 2)。

表 2:自然語言處理任務(wù)中的模型簡化測試。

表 3:計(jì)算機(jī)視覺任務(wù):CIFAR - 10 的分類結(jié)果。我們采用一個(gè) 42000 / 8000 的訓(xùn)練/驗(yàn)證拆分——一旦根據(jù)驗(yàn)證誤差選擇了較佳模型,我們就直接將其轉(zhuǎn)發(fā)到測試集,而不進(jìn)行任何驗(yàn)證集退回再訓(xùn)練。我們僅使用水平翻轉(zhuǎn)來增加數(shù)據(jù)。上表中的結(jié)果是 5 輪實(shí)驗(yàn)的平均結(jié)果。

論文:GLoMo: Unsupervisedly Learned Relational Graphs as Transferable Representations

論文鏈接:https://arxiv.org/abs/1806.05662

摘要:現(xiàn)代深度遷移學(xué)習(xí)方法主要側(cè)重于從一個(gè)任務(wù)中學(xué)習(xí)可遷移到其他任務(wù)的通用特征向量,例如語言中的單詞嵌入和視覺中的預(yù)訓(xùn)練卷積特征。然而,這些方法通常遷移一元特征,卻很大程度上忽略了更結(jié)構(gòu)化的圖形表征。本論文探索了從大規(guī)模未標(biāo)記數(shù)據(jù)中學(xué)習(xí)捕獲數(shù)據(jù)單元對(例如單詞或像素)之間依賴關(guān)系的通用隱藏關(guān)系圖,并將這些圖傳遞給下游任務(wù)的可能性。我們提出的遷移學(xué)習(xí)框架提高了各種任務(wù)的性能,包括問答、自然語言推理、情感分析和圖像分類。我們的測試還表明,學(xué)習(xí)到的圖形是通用的,可以遷移到未經(jīng)過圖形訓(xùn)練的不同嵌入(包括 GloVe 嵌入、ELMo 嵌入和任務(wù)特定的 RNN 隱藏單元)或無嵌入單元(如圖形像素)。?

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/4796.html

摘要:人工智能的主流算法深度學(xué)習(xí)的歷史,堪稱也是深度學(xué)習(xí)三劍客和共同走過的年艱難而輝煌的不悔人生。之后使用一種稱為監(jiān)督學(xué)習(xí)的方法來訓(xùn)練感知器,以正確區(qū)分不同形狀。表示,多層次神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)并不會使感知器強(qiáng)大到有實(shí)用價(jià)值。 人工智能的主流算法Deep Learning深度學(xué)習(xí)的歷史,堪稱Deep History, 也是深度學(xué)習(xí)三劍客Geoff Hinton, Yann LeCun 和Yoshua B...

摘要:年的深度學(xué)習(xí)研討會,壓軸大戲是關(guān)于深度學(xué)習(xí)未來的討論。他認(rèn)為,有潛力成為深度學(xué)習(xí)的下一個(gè)重點(diǎn)。認(rèn)為這樣的人工智能恐懼和奇點(diǎn)的討論是一個(gè)巨大的牽引。 2015年ICML的深度學(xué)習(xí)研討會,壓軸大戲是關(guān)于深度學(xué)習(xí)未來的討論。基于平衡考慮,組織方分別邀請了來自工業(yè)界和學(xué)術(shù)界的六位專家開展這次圓桌討論。組織者之一Kyunghyun Cho(Bengio的博士后)在飛機(jī)上憑記憶寫下本文總結(jié)了討論的內(nèi)容,...

摘要:最近,這就是街舞第二季開播,又一次燃起了全民熱舞的風(fēng)潮。然而,真要自己跳起來,實(shí)際與想象之間,估計(jì)差了若干個(gè)羅志祥。系統(tǒng)映射結(jié)果展示對于系統(tǒng)的結(jié)果,研究人員表示還不完美。谷歌在和跳舞的結(jié)合上也花了心思。好了,先不說了,我要去跟學(xué)跳舞了。 最近,《這!就是街舞》第二季開播,又一次燃起了全民熱舞的風(fēng)潮。 剛開播沒多久,這個(gè)全程高能的節(jié)目,就在豆瓣上就得到了 9.6 的高分。舞者們在比賽中精...

摘要:近年來,深度學(xué)習(xí)在計(jì)算機(jī)感知自然語言處理和控制方面取得了重大進(jìn)展。位列新澤西州的發(fā)明家名人堂,并獲得年神經(jīng)網(wǎng)絡(luò)先鋒獎(jiǎng)年杰出研究獎(jiǎng)年終身成就獎(jiǎng)和來自墨西哥的名譽(yù)博士學(xué)位。 Yann Lecun是卷積網(wǎng)絡(luò)模型的發(fā)明者,該模型被廣泛地應(yīng)用于模式識別應(yīng)用中,因此他也被稱為卷積網(wǎng)絡(luò)之父,是公認(rèn)的世界人工智能三巨頭之一。 2018年11月08日,他來到加州大學(xué)圣巴巴拉分校,為在場師生作了一場關(guān)于自監(jiān)督學(xué)...

摘要:圖神經(jīng)網(wǎng)絡(luò)是近年發(fā)展起來的一個(gè)很有前景的深度學(xué)習(xí)方向,也是一種強(qiáng)大的圖點(diǎn)云和流形表示學(xué)習(xí)方法。地址基于的幾何深度學(xué)習(xí)擴(kuò)展庫是一個(gè)基于的幾何深度學(xué)習(xí)擴(kuò)展庫,用于不規(guī)則結(jié)構(gòu)輸入數(shù)據(jù),例如圖點(diǎn)云和流形。與相比,訓(xùn)練模型的速度快了倍。 過去十年來,深度學(xué)習(xí)方法(例如卷積神經(jīng)網(wǎng)絡(luò)和遞歸神經(jīng)網(wǎng)絡(luò))在許多領(lǐng)域取得了前所未有的成就,例如計(jì)算機(jī)視覺和語音識別。研究者主要將深度學(xué)習(xí)方法應(yīng)用于歐氏結(jié)構(gòu)數(shù)據(jù) (Eu...

閱讀 3461·2023-04-25 19:39

閱讀 3814·2021-11-18 13:12

閱讀 3641·2021-09-22 15:45

閱讀 2439·2021-09-22 15:32

閱讀 724·2021-09-04 16:40

閱讀 3734·2019-08-30 14:11

閱讀 1892·2019-08-30 13:46

閱讀 1569·2019-08-29 15:43