資訊專欄INFORMATION COLUMN

摘要:更廣泛地說,這些結(jié)果表明神經(jīng)網(wǎng)絡(luò)訓(xùn)練不需要被認為是一種煉丹術(shù),而是可以被量化和系統(tǒng)化。中間的曲線中存在彎曲,漸變噪聲標(biāo)度預(yù)測彎曲發(fā)生的位置。

由于復(fù)雜的任務(wù)往往具有更嘈雜的梯度,因此越來越大的batch計算包,可能在將來變得有用,從而消除了AI系統(tǒng)進一步增長的一個潛在限制。

更廣泛地說,這些結(jié)果表明神經(jīng)網(wǎng)絡(luò)訓(xùn)練不需要被認為是一種煉丹術(shù),而是可以被量化和系統(tǒng)化。

在過去的幾年里,AI研究人員通過數(shù)據(jù)并行技術(shù),在加速神經(jīng)網(wǎng)絡(luò)訓(xùn)練方面取得了越來越大的成功,數(shù)據(jù)并行性將大batch數(shù)據(jù)分散到許多機器上。

研究人員成功地使用了成各種的batch進行圖像分類和語言建模,甚至玩Dota 2。

這些大batch數(shù)據(jù)允許將越來越多的計算量有效地投入到單個模型的訓(xùn)練中,并且是人工智能訓(xùn)練計算快速增長的重要推動者。

但是,batch如果太大,則梯度消失。并且不清楚為什么這些限制對于某些任務(wù)影響更大而對其他任務(wù)影響較小。

我們已經(jīng)發(fā)現(xiàn),通過測量梯度噪聲標(biāo)度,一個簡單的統(tǒng)計量來量化網(wǎng)絡(luò)梯度的信噪比,我們可以近似預(yù)測較大有效batch大小。

同理,噪聲尺度可以測量模型所見的數(shù)據(jù)變化(在訓(xùn)練的給定階段)。當(dāng)噪聲規(guī)模很小時,快速并行查看大量數(shù)據(jù)變得多余;反之,我們?nèi)匀豢梢詮拇骲atch數(shù)據(jù)中學(xué)到很多東西。

這種類型的統(tǒng)計數(shù)據(jù)被廣泛用于樣本量選擇,并且已被提議用于深度學(xué)習(xí),但尚未被系統(tǒng)地測量或應(yīng)用于現(xiàn)代訓(xùn)練運行。

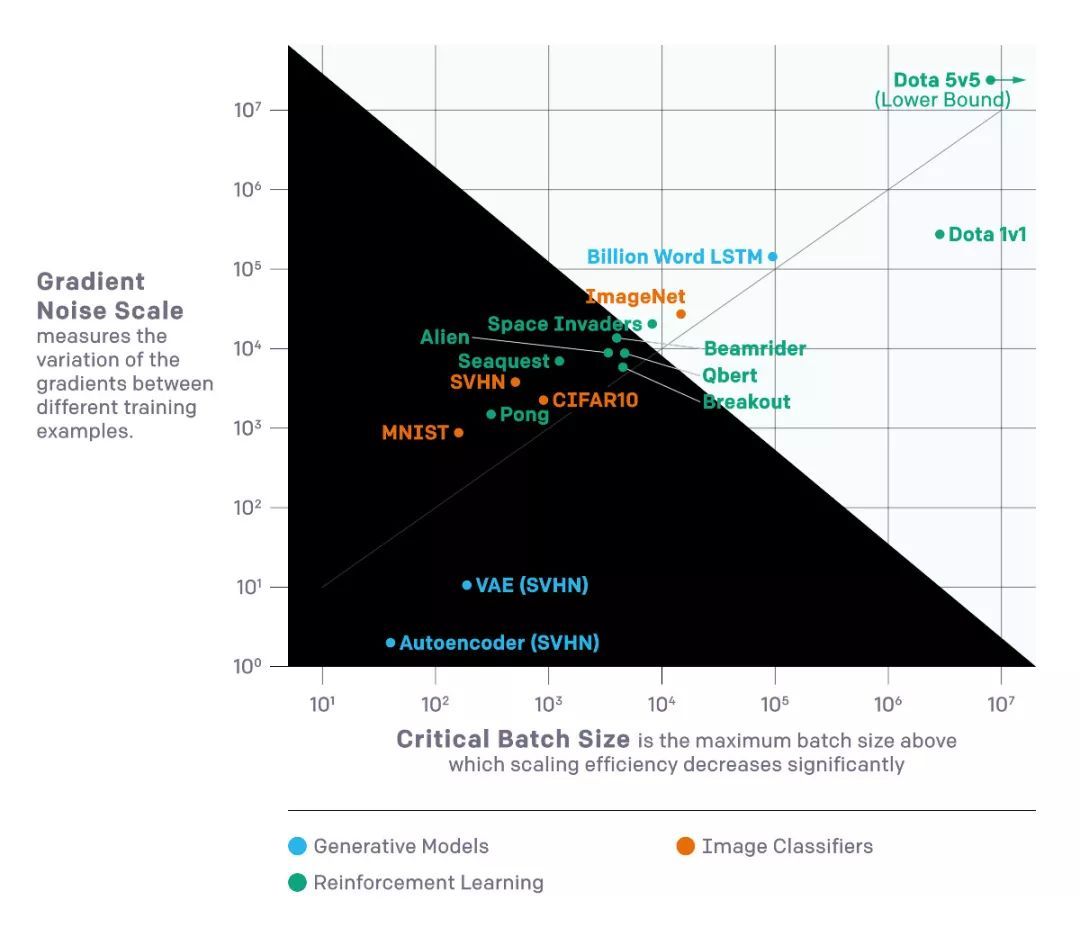

我們對上圖所示的各種機器學(xué)習(xí)任務(wù)進行了驗證,包括圖像識別,語言建模,Atari游戲和Dota。

由于大batch通常需要仔細和昂貴的調(diào)整或特殊高效的學(xué)習(xí)率,因此提前知道上限在訓(xùn)練新模型方面提供了顯著的實際優(yōu)勢。

我們發(fā)現(xiàn),根據(jù)訓(xùn)練的現(xiàn)實時間和我們用于進行訓(xùn)練的總體積計算(與美元成本成比例)之間的權(quán)衡,可視化這些實驗的結(jié)果是有幫助的。

在非常小的batch的情況下,batch加倍可以讓我們在不使用額外計算的情況下減少一半的訓(xùn)練。在非常大的batch,更多的并行化不會導(dǎo)致更快的訓(xùn)練。中間的曲線中存在“彎曲”,漸變噪聲標(biāo)度預(yù)測彎曲發(fā)生的位置。

我們通過設(shè)置性能水平(比如在Beam Rider的Atari游戲中得分為1000)來制作這些曲線,并觀察在不同batch大小下訓(xùn)練到該性能所需的時間。 結(jié)果與績效目標(biāo)的許多不同值相對較緊密地匹配了我們模型的預(yù)測。

梯度噪聲尺度中的模式

我們在梯度噪聲量表中觀察到了幾種模式,這些模式提供了人工智能訓(xùn)練未來可能存在的線索。

首先,在我們的實驗中,噪聲標(biāo)度通常在訓(xùn)練過程中增加一個數(shù)量級或更多。

直觀地,這意味著網(wǎng)絡(luò)在訓(xùn)練早期學(xué)習(xí)任務(wù)的“更明顯”的特征,并在以后學(xué)習(xí)更復(fù)雜的特征。

例如,在圖像分類器的情況下,網(wǎng)絡(luò)可能首先學(xué)習(xí)識別大多數(shù)圖像中存在的小尺度特征(例如邊緣或紋理),而稍后將這些部分組合成更一般的概念,例如貓和狗。

要查看各種各樣的邊緣或紋理,網(wǎng)絡(luò)只需要看到少量圖像,因此噪聲比例較小;一旦網(wǎng)絡(luò)更多地了解更大的對象,它就可以一次處理更多的圖像,而不會看到重復(fù)的數(shù)據(jù)。

我們看到一些初步跡象表明,在同一數(shù)據(jù)集上不同模型具有相同的效果。更強大的模型具有更高的梯度噪聲標(biāo)度,但這僅僅是因為它們實現(xiàn)了更低的損耗。

因此,有一些證據(jù)表明,訓(xùn)練中增加的噪聲比例不僅僅是收斂的假象,而是因為模型變得更好。如果這是真的,那么我們期望未來的更強大的模型具有更高的噪聲規(guī)模,因此可以更加并行化。

在監(jiān)督學(xué)習(xí)的背景下,從MNIST到SVHN到ImageNet都有明顯的進展。在強化學(xué)習(xí)的背景下,從Atari Pong到Dota 1v1到Dota 5v5有明顯的進展,較佳batch大小相差10,000倍以上。

因此,隨著AI進入新的和更困難的任務(wù),我們希望模型能夠容忍更高的batch。

啟示

數(shù)據(jù)并行度顯著影響AI功能的進展速度。更快的訓(xùn)練使更強大的模型成為可能,并通過更快的迭代時間加速研究。

在早期研究中,我們觀察到用于訓(xùn)練較大ML模型的計算,每3.5個月翻一番。我們注意到這種趨勢是由經(jīng)濟能力和算法并行訓(xùn)練的能力共同決定的。

后一因素(算法可并行性)更難以預(yù)測,其局限性尚不清楚,但我們目前的結(jié)果代表了系統(tǒng)化和量化的一步。

特別是,我們有證據(jù)表明,在同一任務(wù)中,更困難的任務(wù)和更強大的模型將允許比我們迄今為止看到的更激進的數(shù)據(jù)并行性,這為訓(xùn)練計算的持續(xù)快速指數(shù)增長提供了關(guān)鍵驅(qū)動因素。

參考鏈接:

https://blog.openai.com/science-of-ai/

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請聯(lián)系小編及時處理,謝謝!歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價值的辦法,實際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/4834.html

摘要:我仍然用了一些時間才從神經(jīng)科學(xué)轉(zhuǎn)向機器學(xué)習(xí)。當(dāng)我到了該讀博的時候,我很難在的神經(jīng)科學(xué)和的機器學(xué)習(xí)之間做出選擇。 1.你學(xué)習(xí)機器學(xué)習(xí)的歷程是什么?在學(xué)習(xí)機器學(xué)習(xí)時你最喜歡的書是什么?你遇到過什么死胡同嗎?我學(xué)習(xí)機器學(xué)習(xí)的道路是漫長而曲折的。讀高中時,我興趣廣泛,大部分和數(shù)學(xué)或科學(xué)沒有太多關(guān)系。我用語音字母表編造了我自己的語言,我參加了很多創(chuàng)意寫作和文學(xué)課程。高中畢業(yè)后,我進了大學(xué),盡管我不想去...

摘要:訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)需要大量的內(nèi)存,用戶使用這個工具包,可以在計算時間成本僅增加的基礎(chǔ)上,在上運行規(guī)模大倍的前饋模型。使用導(dǎo)入此功能,與使用方法相同,使用梯度函數(shù)來計算參數(shù)的損失梯度。隨后,在反向傳播中重新計算檢查點之間的節(jié)點。 OpenAI是電動汽車制造商特斯拉創(chuàng)始人 Elon Musk和著名的科技孵化器公司 Y Combinator總裁 Sam Altman于 2016年聯(lián)合創(chuàng)立的 AI公司...

閱讀 2526·2021-09-26 10:18

閱讀 3399·2021-09-22 10:02

閱讀 3209·2019-08-30 15:44

閱讀 3336·2019-08-30 15:44

閱讀 1841·2019-08-29 15:25

閱讀 2587·2019-08-26 14:04

閱讀 2052·2019-08-26 12:15

閱讀 2449·2019-08-26 11:43