資訊專(zhuān)欄INFORMATION COLUMN

摘要:年月日,將標(biāo)志著一個(gè)時(shí)代的終結(jié)。數(shù)據(jù)集最初由斯坦福大學(xué)李飛飛等人在的一篇論文中推出,并被用于替代數(shù)據(jù)集后者在數(shù)據(jù)規(guī)模和多樣性上都不如和數(shù)據(jù)集在標(biāo)準(zhǔn)化上不如。從年一個(gè)專(zhuān)注于圖像分類(lèi)的數(shù)據(jù)集,也是李飛飛開(kāi)創(chuàng)的。

2017 年 7 月 26 日,將標(biāo)志著一個(gè)時(shí)代的終結(jié)。

那一天,與計(jì)算機(jī)視覺(jué)頂會(huì) CVPR 2017 同期舉行的 Workshop——“超越 ILSVRC”(Beyond ImageNet Large Scale Visual Recogition Challenge),將宣布計(jì)算機(jī)視覺(jué)乃至整個(gè)人工智能發(fā)展史上的里程碑——IamgeNet 大規(guī)模視覺(jué)識(shí)別挑戰(zhàn)賽將于 2017 年正式結(jié)束,此后將專(zhuān)注于目前尚未解決的問(wèn)題及以后發(fā)展方向。

根據(jù)“超越 ILSVRC” Workshop 官網(wǎng)介紹,這堂研討會(huì)的內(nèi)容主要包括以下 4 點(diǎn):

發(fā)表 2017 年 ILSVRC 的結(jié)果

評(píng)估 ILSVRC 2017 圖像、視頻物體識(shí)別、分類(lèi)的當(dāng)前較佳結(jié)果

探討這與當(dāng)前在計(jì)算機(jī)視覺(jué)產(chǎn)業(yè)中應(yīng)用的最優(yōu)技術(shù)的關(guān)系

受邀講者(目前確定的有加州大學(xué)伯克利分校的 Jitendra Malik,以及斯坦福大學(xué)教授、目前谷歌云首席科學(xué)家李飛飛)發(fā)表講話(huà),論述在他們看來(lái)從認(rèn)知視覺(jué)到機(jī)器人視覺(jué)等領(lǐng)域存在的挑戰(zhàn)

ImageNet:深度學(xué)習(xí)熱潮的關(guān)鍵推動(dòng)者之一

ImageNet 可以說(shuō)是計(jì)算機(jī)視覺(jué)研究人員進(jìn)行大規(guī)模物體識(shí)別和檢測(cè)時(shí),最先想到的視覺(jué)大數(shù)據(jù)來(lái)源。ImageNet 數(shù)據(jù)集最初由斯坦福大學(xué)李飛飛等人在 CVPR 2009 的一篇論文中推出,并被用于替代 PASCAL 數(shù)據(jù)集(后者在數(shù)據(jù)規(guī)模和多樣性上都不如 ImageNet)和 LabelMe 數(shù)據(jù)集(在標(biāo)準(zhǔn)化上不如 ImageNet)。

ImageNet 從 Caltech101(2004 年一個(gè)專(zhuān)注于圖像分類(lèi)的數(shù)據(jù)集,也是李飛飛開(kāi)創(chuàng)的)。ImageNet 不但是計(jì)算機(jī)視覺(jué)發(fā)展的重要推動(dòng)者,也是這一波深度學(xué)習(xí)熱潮的關(guān)鍵驅(qū)動(dòng)力之一。

截至 2016 年,ImageNet 中含有超過(guò) 1500 萬(wàn)由人手工注釋的圖片網(wǎng)址,也就是帶標(biāo)簽的圖片,標(biāo)簽說(shuō)明了圖片中的內(nèi)容,超過(guò) 2.2 萬(wàn)個(gè)類(lèi)別。其中,至少有 100 萬(wàn)張里面提供了邊框(bounding box)。

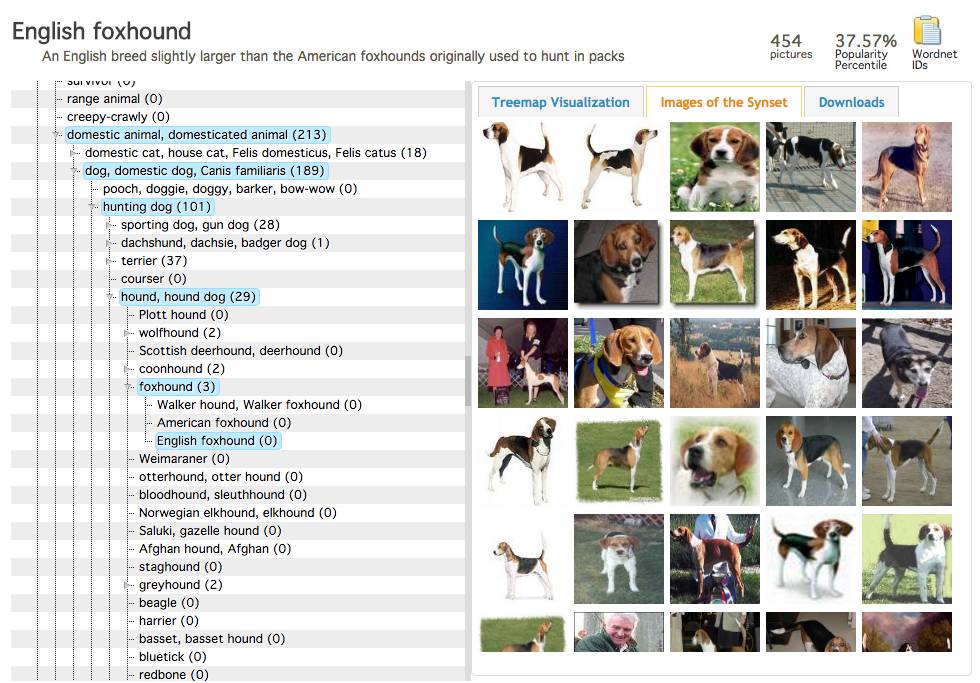

ImageNet 數(shù)據(jù)集中“獵狐犬”的部分示例

從 2010 年以來(lái),ImageNet 每年都會(huì)舉辦一次軟件競(jìng)賽,也即 ImageNet 大規(guī)模視覺(jué)識(shí)別挑戰(zhàn)賽(ILSVRC),參賽程序會(huì)相互比試,看誰(shuí)能以較高的正確率對(duì)物體和場(chǎng)景進(jìn)行分類(lèi)和檢測(cè),不僅牽動(dòng)著產(chǎn)學(xué)研三界的心,也是各團(tuán)隊(duì)、巨頭展示實(shí)力的競(jìng)技場(chǎng)。

從 2010 年以來(lái),每年的 ILSVRC 都主要包括以下 3 項(xiàng),后來(lái)逐漸增多:

圖像分類(lèi):算法產(chǎn)生圖像中存在的對(duì)象類(lèi)別列表

單物體定位:算法生成一個(gè)圖像中含有的物體類(lèi)別的列表,以及軸對(duì)齊的邊框,邊框指示每個(gè)物體類(lèi)別的每個(gè)實(shí)例的位置和比例

物體檢測(cè):算法生成圖像中含有的物體類(lèi)別的列表,以及每個(gè)物體類(lèi)別中每個(gè)實(shí)例的邊框,邊框表示這些實(shí)例的位置和比例。

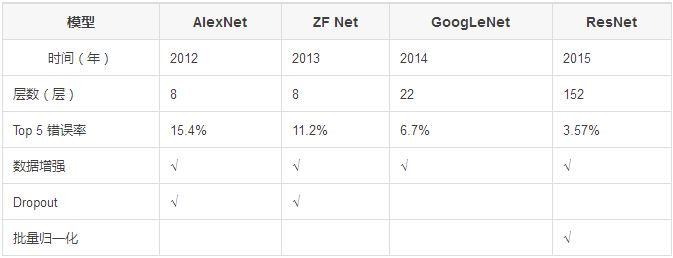

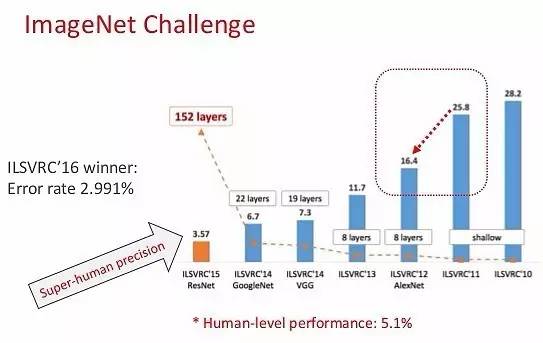

2012 年,Alex Krizhevsky、Ilya Sutskever 和 Geoffrey Hinton 創(chuàng)造了一個(gè)“大型的深度卷積神經(jīng)網(wǎng)絡(luò)”,也即現(xiàn)在眾所周知的 AlexNet,贏得了當(dāng)年的 ILSVRC。這是史上第一次有模型在 ImageNet 數(shù)據(jù)集表現(xiàn)如此出色。論文中提出的方法,比如數(shù)據(jù)增強(qiáng)和 dropout,直到現(xiàn)在也在使用,那篇論文“ImageNet Classification with Deep Convolutional Networks”,迄今被引用約 7000 次,被業(yè)內(nèi)普遍視為行業(yè)最重要的論文之一,真正展示了 CNN 的優(yōu)點(diǎn),并且以破紀(jì)錄的比賽成績(jī)實(shí)打?qū)嵉刈鲋巍?/p>

2012 年是 CNN 首次實(shí)現(xiàn) Top 5 誤差率 15.4% 的一年,當(dāng)時(shí)的次優(yōu)項(xiàng)誤差率為 26.2%。這個(gè)表現(xiàn)震驚了整個(gè)計(jì)算機(jī)視覺(jué)界。可以說(shuō),是自那時(shí)起,CNN 才成了家喻戶(hù)曉的名字。

ImageNet 歷屆冠軍及技術(shù)回顧:

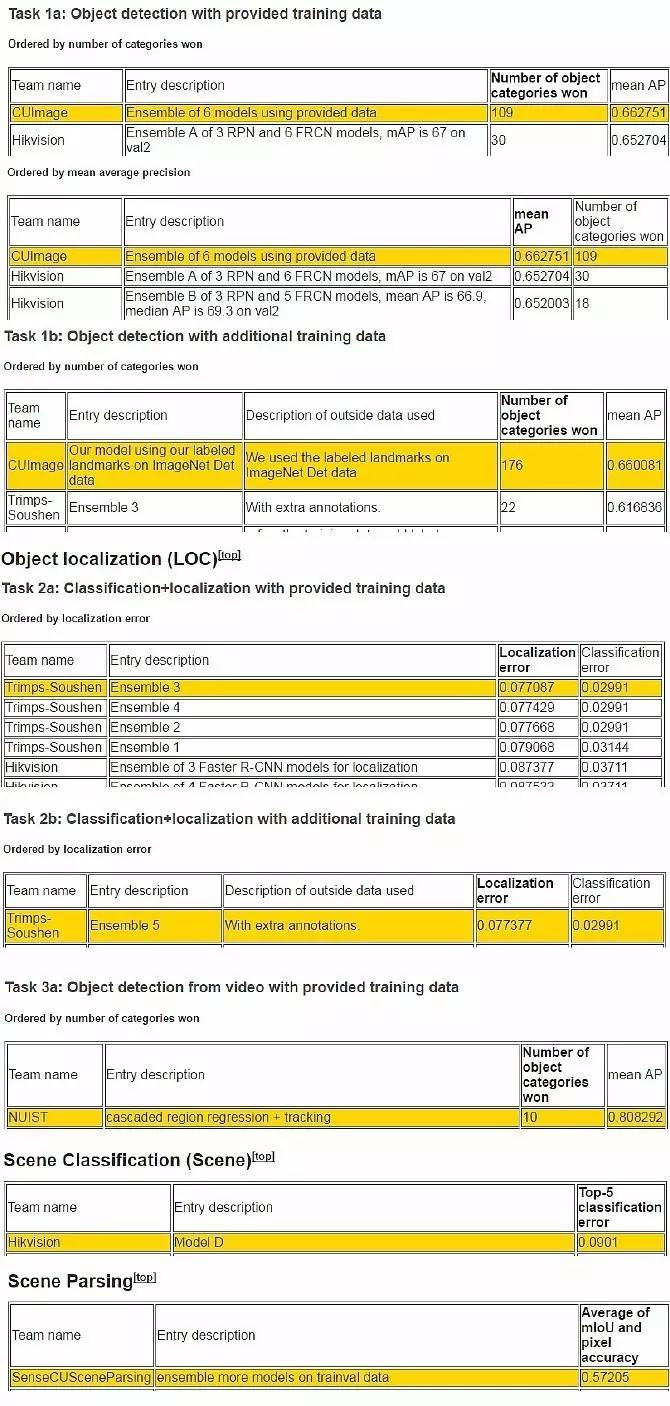

中國(guó)團(tuán)隊(duì)在 ImageNet 競(jìng)賽中的亮眼表現(xiàn)

2016 年的 ILSVRC,來(lái)自中國(guó)的團(tuán)隊(duì)大放異彩:

CUImage(商湯和港中文),Trimps-Soushen(公安部三所),CUvideo(商湯和港中文),HikVision(海康威視),SenseCUSceneParsing(商湯和香港城市大學(xué)),NUIST(南京信息工程大學(xué))包攬了各個(gè)項(xiàng)目的冠軍。

從下圖中可見(jiàn),無(wú)論的圖像分類(lèi)、物體檢測(cè)、物體識(shí)別,計(jì)算機(jī)的正確率都已經(jīng)遠(yuǎn)遠(yuǎn)超越人類(lèi)。可以說(shuō),計(jì)算機(jī)視覺(jué)在感知方面的問(wèn)題已經(jīng)得到了很好的解決。

那么,計(jì)算機(jī)視覺(jué)的未來(lái)的重點(diǎn)將是什么,ImageNet 競(jìng)賽之后,又會(huì)出現(xiàn)什么呢?

超越 ILSVRC:側(cè)重圖像學(xué)習(xí)和理解的 WebVision 競(jìng)賽

WebVision 數(shù)據(jù)集是通過(guò)蘇黎世科技大學(xué)計(jì)算機(jī)視覺(jué)實(shí)驗(yàn)室的網(wǎng)絡(luò)數(shù)據(jù)團(tuán)隊(duì)收集的。這一數(shù)據(jù)集的開(kāi)發(fā)得到了谷歌研究院蘇黎世分部的支持。

WebVision 數(shù)據(jù)集使用與 2012 年 ImageNet 競(jìng)賽相同的 1000 個(gè)類(lèi)別,涵蓋了直接從網(wǎng)絡(luò)收集到的 240 萬(wàn)張現(xiàn)代圖像(包括谷歌圖像搜索中獲得的 100 萬(wàn)張,以及來(lái)自 Flickr 的 140 萬(wàn)張圖像)和元數(shù)據(jù)。

在 CVPR 2017 上,也會(huì)舉辦 WebVision Challenge,這一比賽更加注重對(duì)圖像和視頻數(shù)據(jù)的學(xué)習(xí)和理解,它有可能會(huì)成為未來(lái)的 ImageNet 競(jìng)賽嗎?

摘要

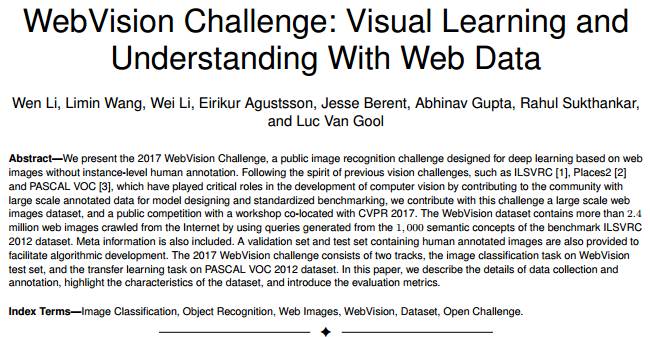

我們提出 2017 年 WebVision 競(jìng)賽,這是一項(xiàng)公開(kāi)的圖像識(shí)別挑戰(zhàn)賽,旨在基于網(wǎng)頁(yè)圖像進(jìn)行深度學(xué)習(xí),而無(wú)需人手工對(duì)實(shí)例進(jìn)行標(biāo)注。此前的計(jì)算機(jī)視覺(jué)挑戰(zhàn)賽,如 ILSVRC、Places2 和 PASCAL VOC,通過(guò)提供大量的注釋數(shù)據(jù),用于模型設(shè)計(jì)和標(biāo)準(zhǔn)化的基準(zhǔn)測(cè)試,為計(jì)算機(jī)視覺(jué)的發(fā)展發(fā)揮了關(guān)鍵作用。為了延續(xù)它們的精神,我們?cè)诒緦?CVPR 2017 舉辦研討會(huì),進(jìn)行一項(xiàng)基于大規(guī)模網(wǎng)絡(luò)圖像數(shù)據(jù)集的公開(kāi)競(jìng)賽。WebVision 數(shù)據(jù)集包含從互聯(lián)網(wǎng)上用爬蟲(chóng)收集的 240 多萬(wàn)的網(wǎng)絡(luò)圖像,方法是使用從 ILSVRC 2012 基準(zhǔn)中的 1000 個(gè)語(yǔ)義概念生成的查詢(xún)(query)。元信息(Meta information)也包含在內(nèi)。

此外,WebVision 數(shù)據(jù)集也提供檢驗(yàn)數(shù)據(jù)集和測(cè)試數(shù)據(jù)集,這些數(shù)據(jù)集中的數(shù)據(jù)都帶有人手工標(biāo)注的標(biāo)簽,從而便于算法的開(kāi)發(fā)。2017 年 WebVision ?挑戰(zhàn)賽分為兩類(lèi),一是在 WebVision 測(cè)試數(shù)據(jù)集上進(jìn)行圖像分類(lèi),以及在 PASCAL VOC 2012 數(shù)據(jù)集上進(jìn)行遷移學(xué)習(xí)。在本文中,我們描述了數(shù)據(jù)收集和注釋的細(xì)節(jié),突出了 WebVision 數(shù)據(jù)集的特點(diǎn),并介紹了相關(guān)評(píng)估指標(biāo)。

編譯來(lái)源:

超越 ILSRVC 研討會(huì)介紹:http://image-net.org/challenges/beyond_ilsvrc

WebVision Challenge 介紹:http://www.vision.ee.ethz.ch/webvision/about.html

WebVision Challenge 論文:https://arxiv.org/pdf/1705.05640.pdf

商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://m.specialneedsforspecialkids.com/yun/4583.html

摘要:在本次競(jìng)賽中,南京信息工程大學(xué)和帝國(guó)理工學(xué)院的團(tuán)隊(duì)獲得了目標(biāo)檢測(cè)的最優(yōu)成績(jī),最優(yōu)檢測(cè)目標(biāo)數(shù)量為平均較精確率為。最后在視頻目標(biāo)檢測(cè)任務(wù)中,帝國(guó)理工大學(xué)和悉尼大學(xué)所組成的團(tuán)隊(duì)取得了較佳表現(xiàn)。 在本次 ImageNet 競(jìng)賽中,南京信息工程大學(xué)和帝國(guó)理工學(xué)院的團(tuán)隊(duì) BDAT 獲得了目標(biāo)檢測(cè)的最優(yōu)成績(jī),最優(yōu)檢測(cè)目標(biāo)數(shù)量為 85、平均較精確率為 0.732227。而在目標(biāo)定位任務(wù)中Momenta和牛津...

摘要:為了探索多種訓(xùn)練方案,何愷明等人嘗試了在不同的迭代周期降低學(xué)習(xí)率。實(shí)驗(yàn)中,何愷明等人還用預(yù)訓(xùn)練了同樣的模型,再進(jìn)行微調(diào),成績(jī)沒(méi)有任何提升。何愷明在論文中用來(lái)形容這個(gè)結(jié)果。 何愷明,RBG,Piotr Dollár。三位從Mask R-CNN就開(kāi)始合作的大神搭檔,剛剛再次聯(lián)手,一文終結(jié)了ImageNet預(yù)訓(xùn)練時(shí)代。他們所針對(duì)的是當(dāng)前計(jì)算機(jī)視覺(jué)研究中的一種常規(guī)操作:管它什么任務(wù),拿來(lái)ImageN...

摘要:月日,各項(xiàng)競(jìng)賽的排名將決定最終的成績(jī)排名。選手通過(guò)訓(xùn)練模型,對(duì)虛擬股票走勢(shì)進(jìn)行預(yù)測(cè)。冠軍將獲得萬(wàn)元人民幣的獎(jiǎng)勵(lì)。 showImg(https://segmentfault.com/img/bVUzA7?w=477&h=317); 2017年9月4日,AI challenger全球AI挑戰(zhàn)賽正式開(kāi)賽,來(lái)自世界各地的AI高手,將展開(kāi)為期三個(gè)多月的比拼,獲勝團(tuán)隊(duì)將分享總額超過(guò)200萬(wàn)人民幣的...

摘要:但是,有一些研究人員在同一個(gè)深度神經(jīng)網(wǎng)絡(luò)中巧妙地實(shí)現(xiàn)了二者能力的結(jié)合。一次讀取并解釋輸入文本中的一個(gè)字或字符圖像,因此深度神經(jīng)網(wǎng)絡(luò)必須等待直到當(dāng)前字的處理完成,才能去處理下一個(gè)字。 從有一些有趣的用例看,我們似乎完全可以將 CNN 和 RNN/LSTM 結(jié)合使用。許多研究者目前正致力于此項(xiàng)研究。但是,CNN 的研究進(jìn)展趨勢(shì)可能會(huì)令這一想法不合時(shí)宜。一些事情正如水與油一樣,看上去無(wú)法結(jié)合在一起...

摘要:阿里巴巴有一群天馬行空腳踏實(shí)地的阿里星。天馬行空腳踏實(shí)地奮斗在阿里巴巴生態(tài)圈里,阿里星們高考狀元清華博士論文達(dá)人的光環(huán)早已褪去,但是不斷學(xué)習(xí),不斷接受挑戰(zhàn),仍然是這些學(xué)霸的本色。 showImg(https://segmentfault.com/img/remote/1460000018728353); 阿里巴巴有一群天馬行空腳踏實(shí)地的阿里星。 阿里巴巴的春季校招已經(jīng)啟動(dòng)。在阿里的技術(shù)...

閱讀 3211·2023-04-26 01:30

閱讀 674·2021-11-08 13:15

閱讀 1795·2021-09-24 10:35

閱讀 1008·2021-09-22 15:41

閱讀 1933·2019-08-30 15:44

閱讀 602·2019-08-30 13:22

閱讀 1012·2019-08-30 13:06

閱讀 1203·2019-08-29 13:22