資訊專欄INFORMATION COLUMN

摘要:深度神經(jīng)網(wǎng)絡(luò)里面,大部分節(jié)點都是等同的,但是在人類神經(jīng)網(wǎng)絡(luò)里面,并不是這樣。神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)目前的深度神經(jīng)網(wǎng)絡(luò)主要是三種結(jié)構(gòu),全連接的卷積,循環(huán)。總結(jié)一下,就是深度神經(jīng)網(wǎng)絡(luò)和大腦皮層有共通的地方,但是并不能算是模擬。

神經(jīng)元

在深度學(xué)習(xí)領(lǐng)域,神經(jīng)元是最底層的單元,如果用感知機的模型, wx + b, 加上一個激活函數(shù)構(gòu)成了全部,輸入和輸出都是數(shù)字,研究的比較清楚。別的不說,在參數(shù)已知的情況下,有了輸入可以計算輸出,有了輸出可以計算輸入。

但在神經(jīng)科學(xué)領(lǐng)域,神經(jīng)元并不是最底層的單位。

舉例來說,有人在做神經(jīng)元膜離子通道相關(guān)的工作。一個神經(jīng)元的輸入,可以分為三部分,從其他神經(jīng)元來的電信號輸入,化學(xué)信號輸入,還有編碼在細胞內(nèi)的信號(興奮,抑制類型,這里可以類比為 激活函數(shù)?),輸出也是三個,電輸出,化學(xué)輸出,改變自身狀態(tài)(LTP 長時程增強, LTD長時程抑制)。

我們是否足夠了解神經(jīng)元? 我個人十分懷疑這一點,前幾天還看到一個關(guān)于神經(jīng)元的進展,大意是神經(jīng)元不僅能對單一信號產(chǎn)生反應(yīng)。還能對一定一定間隔的信號產(chǎn)生反應(yīng)。。 神經(jīng)元的底層編碼能力其實更強。我們神經(jīng)科學(xué)發(fā)展了這么久,可能真的連神經(jīng)元都沒真正的搞清楚。

在這另外說一句。 深度神經(jīng)網(wǎng)絡(luò)里面,大部分節(jié)點都是等同的,但是在人類神經(jīng)網(wǎng)絡(luò)里面,并不是這樣。不同的腦區(qū),甚至腦區(qū)內(nèi)部,神經(jīng)元的形態(tài)都可以有很大的差異,如V1內(nèi)部的六層就是基于神經(jīng)元形態(tài)的區(qū)分。從這個角度,人類神經(jīng)系統(tǒng)要更復(fù)雜一些。我個人并不否認每一種神經(jīng)元可以用不同初始化參數(shù)的 節(jié)點來代替,但是目前來說,復(fù)雜度還是要比深度神經(jīng)網(wǎng)絡(luò)要高。

信號編碼方式

再說編碼方式,神經(jīng)科學(xué)里面的 神經(jīng)元是會產(chǎn)生0-1 的動作電位,通過動作電位的頻率來編碼相應(yīng)的信號(腦子里面的大部分是這樣,外周會有其他形式的),而人工神經(jīng)網(wǎng)絡(luò)?大部分我們聽到的,看到的應(yīng)該都不是這種方式編碼的,但是 脈沖神經(jīng)網(wǎng)絡(luò) 這個東西確實也有,(去ASSC 開會的時候看到了一個很有趣的工作,在評論區(qū)簡單說了下,有興趣可以去看。)

神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)

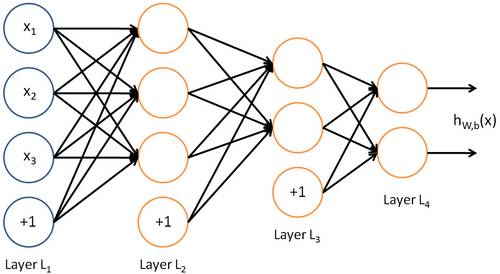

目前的深度神經(jīng)網(wǎng)絡(luò)主要是三種結(jié)構(gòu), DNN(全連接的)、CNN(卷積), RNN(循環(huán))。還有一些很奇怪的, 比如說...Attention 的?不好意思,文章還沒看,不敢亂說。

DNN:

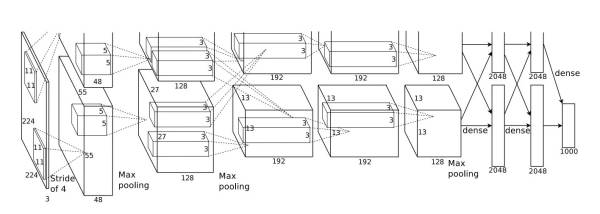

CNN:

出處: AlexNet

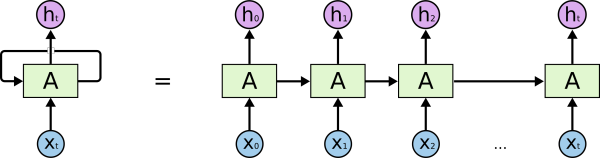

RNN:

出處: Understanding LSTM Networks

http://colah.github.io/posts/2015-08-Understanding-LSTMs/

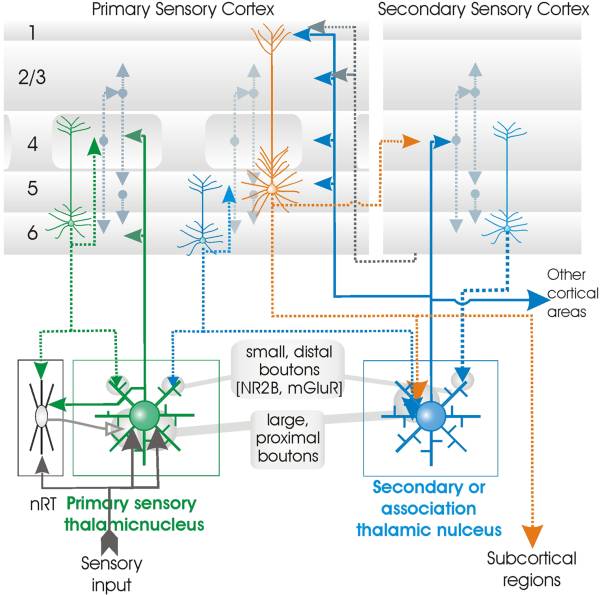

神經(jīng)科學(xué)里面的網(wǎng)絡(luò)結(jié)構(gòu),此處以V1 為例:

和大家想的不同,視覺區(qū)分了V1,V2,V3,V4,V5(MT),上面還有FFA, 和一些掌管更高級功能的腦區(qū)。在這里面每一個小的視皮層里面,并不是純由神經(jīng)元互相連接構(gòu)成的,仍然存在不同的層級結(jié)構(gòu)。這里去google 找了一張圖,不用管具體的文章,主要說明的是V1 的精細結(jié)構(gòu)和連接關(guān)系。V1 的主要功能是 識別點和不同角度的線段(Hubel 和W 在上世紀50年代在貓上的工作),但是其實不止如此,V1 還對顏色有一定的感知。

如果在這個層面作比較,我自己的理解是, 人類神經(jīng)網(wǎng)絡(luò)是 DNN+ CNN + RNN 再加上脈沖作為編碼方式。層內(nèi)更像DNN, 層間和CNN 很類似,在時間上展開就是RNN。

好,我們繼續(xù)。

訓(xùn)練方式

深度神經(jīng)網(wǎng)絡(luò)的訓(xùn)練方式主要是反向傳播,從輸出層一直反向傳播到第一層,每一層不斷修正出現(xiàn)的錯誤。但是大腦里面并沒有類似反向傳播機制,最簡單的解釋,神經(jīng)元信號傳遞具有方向性,并沒機會把信號返回上一層。舉個例子,我要拿起手邊的杯子,視覺發(fā)現(xiàn)向右偏移了一點,那我會自然而然的移動整個手臂向左一點,然后試著去重新抓住杯子。好像沒人是讓手指,手,最后是手臂朝杯子移動,甚至多次才能最后成功吧。在此引用下一篇文章里面的圖。

來源文章: Towards Biologically Plausible Error Signal Transmission in Neural Networks

https://arxiv.org/abs/1702.07097

我們的大腦,更像最后 DFA 的原理。出錯了,把誤差送到一個更靠近輸入的地方,然后重新訓(xùn)練。

記憶和遺忘

提到記憶的話,這里主要說的是LSTM, LSTM 的記憶儲存在每個節(jié)點的權(quán)重里面,同時有專門的 遺忘門 控制遺忘速率。這些都是以數(shù)字的形式存儲的。

在神經(jīng)系統(tǒng)里面,記憶的存儲是由一些腦區(qū)的突觸的形成和消失來存儲的。其實他們有一個比較共通的地方在于,他們在訓(xùn)練過程中都是漸變的。得益于反向傳播機制和 神經(jīng)系統(tǒng)的生物性,他們在訓(xùn)練過程中和在不斷的學(xué)習(xí)過程中都只能以一個相對慢的速度發(fā)生改變,從學(xué)習(xí)速率角度來講,他們是比較相似的。

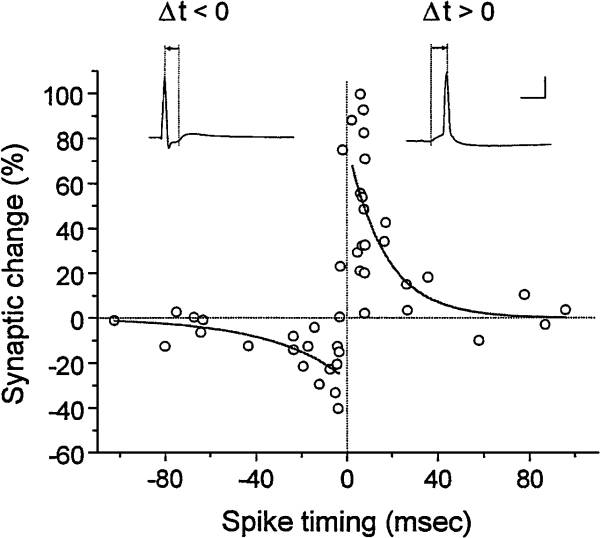

然后我們來說遺忘。遺忘在LSTM 里面是通過門來控制的,在神經(jīng)系統(tǒng)里面,我覺得是和STDP相關(guān)的,它的基礎(chǔ)是 Hebb 假說, Fire Together, Wire Together, 同步放電的神經(jīng)元傾向于建立一個更強的連接。STDP 拓展了這一點,考慮了兩神經(jīng)元放電的先后順序帶來的影響。

來源:Synaptic Modification by Correlated Activity: Hebb's Postulate Revisited

http://annualreviews.org/doi/abs/10.1146/annurev.neuro.24.1.139

簡單來說,如果突觸前神經(jīng)元放電先于突觸后神經(jīng)元(神經(jīng)元信號傳導(dǎo)具有方向性,從突觸前到突觸后),這個突觸會進入一個LTP 長時程增強狀態(tài),會對來自突觸前的信號有更強的反應(yīng)。反之,如果突觸前神經(jīng)元放電后于突觸后,則會進入一個長時程抑制的狀態(tài)(說明他倆并沒有接收到相同來源的信號,信號不相關(guān)),一段時間的反應(yīng)更弱。

深度神經(jīng)網(wǎng)絡(luò)里面門的權(quán)重也是 反向傳播訓(xùn)練出來的,也有漸變的這個性質(zhì),當對于快速變化的刺激,有一定的滯后。從這個角度來說,人類神經(jīng)系統(tǒng)要更靈活一些,可以在很短的時間內(nèi)完成狀態(tài)的切換。

覺得想說的大概就是這些,因為我自己做的研究是 視覺注意,更多在人身上做,所以對于中間的環(huán)路級別的研究,并不是特別的熟悉。再往上,談到人類大腦皮層的工作,個人覺得做的十分的有限,對于大部分腦區(qū),我們并不知道他們是怎么工作的,只是能把不同的腦區(qū)和不同的功能對應(yīng)起來(還不一定準)。在這個角度上談他們的異同是不太負責的。。容易被打臉。

接下來我會試著邀請幾個朋友來說下環(huán)路這個級別的事情。然后會找其他同行幫我挑錯和補充。很多東西都是按照記憶寫的。一些東西不一定準確。。

我的觀點

正如在提綱里面提到的。 對的答案往往類似,而錯誤的答案各有不同。地球上這么多高等的生命都有類似的底層網(wǎng)絡(luò)結(jié)構(gòu),而其中的一種還發(fā)展出了這么偉大的文明,神經(jīng)網(wǎng)絡(luò)這個結(jié)構(gòu),至少已經(jīng)被我們自己證明是一種有效的形式。但是是不是智能這個形式的全局最優(yōu)解?我個人持懷疑態(tài)度。

神經(jīng)網(wǎng)絡(luò)是一個有效的結(jié)構(gòu),所以大家用這個結(jié)構(gòu)做出一些很好的結(jié)果,我一定都不吃驚。但是如果談模擬的話,就是盡力要往這個方向靠。這點上,我個人并不是十分看好這種方式。我們向蝙蝠學(xué)習(xí)用聲音定位,發(fā)展的聲吶無論是距離還是效果都遠超蝙蝠。我們能超過蝙蝠的原因,第一是我們的技術(shù)有拓展性,底層原理共通的情況下,解決工程和機械問題,我們可以不那么輕松但是也做到了探測幾千米,甚至幾十公里。第二個原因就是我們需要而蝙蝠不需要,他們天天在山洞里面睡覺。。哪用得著探測幾十公里的距離,探到了也吃不著。

其實人類大腦也很類似,大腦是一個進化的產(chǎn)物。是由環(huán)境不斷塑造而成的,人為什么沒進化出計算機一樣的計算能力,因為不需要。但是其實反過來也有一定的共通的地方,大腦里面的一些東西,我們也不需要,我們千百年來忍饑挨餓進化出的 對于脂肪攝入的需求,在兒童時期對于糖類攝取的需求。這么說的話,我們對于大腦,同樣去其糟粕,取其精華不是更好嗎?

我上面提到的是一個理想的情況,我們對大腦已經(jīng)了解的比較透徹的,知道該去掉哪,留下哪。但是現(xiàn)在......可能還要走一段模擬的路子。

總結(jié)一下,就是深度神經(jīng)網(wǎng)絡(luò)和大腦皮層有共通的地方,但是并不能算是模擬。只是大家都找到了解題的同一個思路而已。

拓展閱讀以及參考文獻:

從科研到腦科學(xué) - 知乎專欄

https://zhuanlan.zhihu.com/VisNeuro

Understanding LSTM Networks

http://colah.github.io/posts/2015-08-Understanding-LSTMs/

AlexNet: ImageNet Classification with Deep Convolutional Neural Networks

http://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks

Towards Biologically Plausible Error Signal Transmission in Neural Networks

https://arxiv.org/abs/1702.07097

STDP: Synaptic Modification by Correlated Activity: Hebb's Postulate Revisited

http://annualreviews.org/doi/abs/10.1146/annurev.neuro.24.1.139

神經(jīng)元對一定間隔信號反應(yīng): Learned response sequences in cerebellar Purkinje cells

http://www.pnas.org/content/114/23/6127.short

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價值的辦法,實際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://m.specialneedsforspecialkids.com/yun/4601.html

摘要:深度學(xué)習(xí)方法是否已經(jīng)強大到可以使科學(xué)分析任務(wù)產(chǎn)生最前沿的表現(xiàn)在這篇文章中我們介紹了從不同科學(xué)領(lǐng)域中選擇的一系列案例,來展示深度學(xué)習(xí)方法有能力促進科學(xué)發(fā)現(xiàn)。 深度學(xué)習(xí)在很多商業(yè)應(yīng)用中取得了前所未有的成功。大約十年以前,很少有從業(yè)者可以預(yù)測到深度學(xué)習(xí)驅(qū)動的系統(tǒng)可以在計算機視覺和語音識別領(lǐng)域超過人類水平。在勞倫斯伯克利國家實驗室(LBNL)里,我們面臨著科學(xué)領(lǐng)域中最具挑戰(zhàn)性的數(shù)據(jù)分析問題。雖然商業(yè)...

摘要:深度學(xué)習(xí)學(xué)習(xí)筆記整理系列作者聲明該的學(xué)習(xí)系列是整理自網(wǎng)上很大牛和機器學(xué)習(xí)專家所無私奉獻的資料的。但是自年以來,機器學(xué)習(xí)領(lǐng)域,取得了突破性的進展。 Deep Learning(深度學(xué)習(xí))學(xué)習(xí)筆記整理系列 zouxy09@qq.com http://blog.csdn.net/zouxy09 作者:Zouxy version 1.0? 2013-04-08聲明:1)該Deep Lea...

摘要:下文主要講述前饋神經(jīng)網(wǎng)絡(luò)這個值稱之為損失,我們的目標就是使對所有訓(xùn)練數(shù)據(jù)的損失和盡可能的小。對于前饋神經(jīng)網(wǎng)絡(luò)中,這個有向圖是沒有回路的。反饋神經(jīng)網(wǎng)絡(luò)也是一類重要的神經(jīng)網(wǎng)絡(luò)。深度學(xué)習(xí)中的也屬于一種反饋神經(jīng)網(wǎng)絡(luò)。 監(jiān)督學(xué)習(xí)中,如果預(yù)測的變量是離散的,我們稱其為分類(如決策樹,支持向量機等); 如果預(yù)測的變量是連續(xù)的,我們稱其為回歸。 反向傳播算法(back propagation alg...

摘要:深度學(xué)習(xí)通過組合低層特征形成更加抽象的高層表示屬性類別或特征,以發(fā)現(xiàn)數(shù)據(jù)的分布式特征表示。深度學(xué)習(xí)的概念由等人于年提出。但是自年以來,機器學(xué)習(xí)領(lǐng)域,取得了突破性的進展。 深度學(xué)習(xí)是機器學(xué)習(xí)研究中的一個新的領(lǐng)域,其動機在于建立、模擬人腦進行分析學(xué)習(xí)的神經(jīng)網(wǎng)絡(luò),它模仿人腦的機制來解釋數(shù)據(jù),例如圖像,聲音和文本。深度學(xué)習(xí)是無監(jiān)督學(xué)習(xí)的一種。 深度學(xué)習(xí)的概念源于人工神經(jīng)網(wǎng)絡(luò)的研究。含多隱層的多層感知...

摘要:生物學(xué)上合理的認知計算模型用梯度下降算法訓(xùn)練的經(jīng)典認知計算模型需要將基于準確的前饋神經(jīng)元突觸權(quán)重的誤差信號反向傳播,這在生物學(xué)的神經(jīng)系統(tǒng)中被認為是不可能的。 反向傳播(BP)算法被認為是用于訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)的事實上(de-facto)的方法。它使用前饋權(quán)重的轉(zhuǎn)置,以較精確的方式將輸出層的誤差反向傳播到隱藏層。然而,有人認為,這在生物學(xué)上是不合理的,因為在生物神經(jīng)系統(tǒng)中,帶有準確輸入權(quán)重的誤差...

閱讀 2813·2021-10-11 10:57

閱讀 2413·2021-08-27 16:20

閱讀 1393·2019-08-30 13:03

閱讀 1568·2019-08-30 12:50

閱讀 3348·2019-08-29 14:16

閱讀 1565·2019-08-29 11:12

閱讀 1618·2019-08-28 17:53

閱讀 2898·2019-08-27 10:58